最近,中山大学和字节智创数字人团队搞了个大新闻,他们提出了一个叫做MMTryon的虚拟试穿框架。这玩意儿可不简单,只要输入几件衣服的图片,再加上几句穿法的文本指令,就能一键生成模特试穿效果,而且质量还特别高。

想象一下,你选中了一件大衣、一条裤子,再搭个包,然后“啪”的一下,它们就自动穿到了人像上。不管你是真人还是漫画人物,都能一键搞定,这操作简直不要太酷炫!

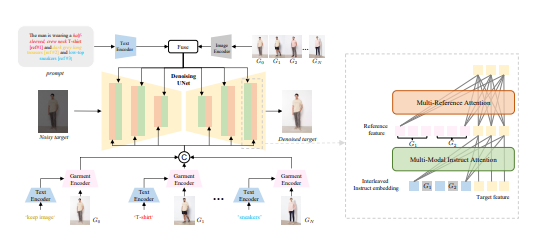

而且,MMTryon的厉害之处还不止于此。它在单图换装方面,利用了大量的数据设计了一个服装编码器,能够处理各种复杂的换装场景和任意服装款式。至于组合换装,它更是打破了传统算法对服装精细分割的依赖,一条文本指令就能搞定,生成的效果既真实又自然。

在基准测试中,MMTryon直接拿下了新SOTA,这成绩可不是盖的。研究团队还搞了个多模态多参考注意机制,让换装效果更精确、更灵活。以前的虚拟试穿方案,要么只能试穿单件,要么对着装风格束手无策。但现在,MMTryon统统给你解决。

而且,MMTryon还特别聪明,它用了一个表征能力丰富的服装编码器,加上新颖的可扩展数据生成流程,让换装过程无需任何分割,直接通过文本和多个试穿对象就能实现高质量虚拟换装。

在开源数据集和复杂场景下的大量实验证明,MMTryon在定性和定量上都优于现有的SOTA方法。研究团队还预训练了一个服装编码器,利用文本作为query,激活文本对应区域的特征,摆脱了对服装分割的依赖。

更牛的是,为了训练组合换装,研究团队提出了一个基于大模型的数据扩增模式,构建了100w的增强数据集,让MMTryon在各种类型的换装上都能有真实的虚拟试穿效果。

MMTryon就像是一个时尚界的黑科技,不仅能帮你一键试穿,还能作为一个fashion换装辅助设计,帮你挑衣服。在量化指标和Human evaluation上,MMTryon都超越了其他baseline模型,效果杠杠的。

论文地址:https://arxiv.org/abs/2405.00448