En el campo de la inteligencia artificial, los grandes modelos de lenguaje (LLM) como GPT-3 y Llama-2 han logrado avances significativos, capaces de comprender y generar lenguaje humano con precisión. Sin embargo, la enorme cantidad de parámetros de estos modelos requiere una gran cantidad de recursos computacionales durante su entrenamiento e implementación, lo que supone un desafío para entornos con recursos limitados.

Enlace al artículo: https://arxiv.org/html/2406.10260v1

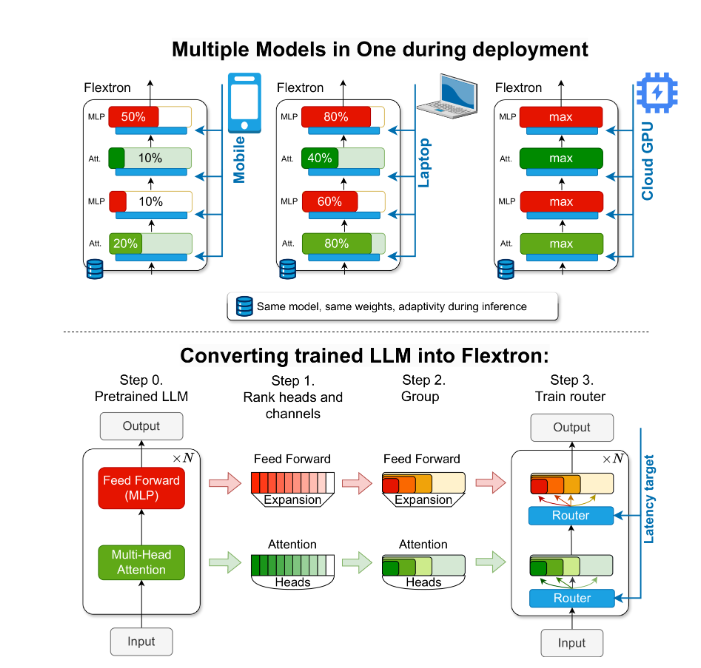

Tradicionalmente, para lograr un equilibrio entre eficiencia y precisión con diferentes limitaciones de recursos computacionales, los investigadores necesitaban entrenar múltiples versiones de un modelo. Por ejemplo, la serie de modelos Llama-2 incluye variantes con 70 mil millones, 13 mil millones y 700 millones de parámetros. Sin embargo, este método requiere una gran cantidad de datos y recursos computacionales, y no es eficiente.

Para solucionar este problema, los investigadores de NVIDIA y la Universidad de Texas en Austin presentaron el marco Flextron. Flextron es un novedoso marco de arquitectura de modelos flexibles y optimización posterior al entrenamiento que permite la implementación adaptable de modelos sin necesidad de un reentrenamiento adicional, resolviendo así la ineficiencia de los métodos tradicionales.

Flextron transforma un LLM preentrenado en un modelo flexible mediante métodos de entrenamiento eficientes en muestras y un algoritmo de enrutamiento avanzado. Esta arquitectura emplea un diseño flexible anidado que permite un ajuste dinámico durante la inferencia para satisfacer objetivos específicos de latencia y precisión. Esta adaptabilidad permite el uso de un único modelo preentrenado en diversos escenarios de implementación, reduciendo significativamente la necesidad de múltiples variantes de modelos.

La evaluación del rendimiento de Flextron muestra que supera en eficiencia y precisión a varios modelos entrenados de extremo a extremo y otras redes flexibles de vanguardia. Por ejemplo, Flextron obtuvo excelentes resultados en varias pruebas de referencia como ARC-easy, LAMBADA, PIQA, WinoGrande, MMLU y HellaSwag, utilizando solo el 7,63% de las etiquetas de entrenamiento del preentrenamiento original, lo que ahorra una gran cantidad de recursos y tiempo de computación.

El marco Flextron también incluye capas de perceptrón multicapa (MLP) flexibles y capas de atención multi-cabeza (MHA) flexibles, lo que aumenta aún más su adaptabilidad. Las capas MHA flexibles utilizan eficazmente la memoria y la capacidad de procesamiento disponibles seleccionando un subconjunto de cabezas de atención según los datos de entrada, lo que las hace especialmente adecuadas para entornos con recursos computacionales limitados.

Puntos clave:

🌐 El marco Flextron admite la implementación flexible de modelos de IA sin necesidad de reentrenamiento adicional.

🚀 Mediante el entrenamiento eficiente en muestras y un algoritmo de enrutamiento avanzado, se mejora la eficiencia y la precisión del modelo.

💡 Las capas de atención multi-cabeza flexibles optimizan el uso de los recursos, especialmente en entornos con recursos computacionales limitados.

Esta información pretende ofrecer a los estudiantes de secundaria una explicación sencilla y comprensible de la importancia y la innovación del marco Flextron.