El laboratorio de investigación de inteligencia artificial chino DeepSeek AI, muy esperado, ha logrado otro gran avance en el campo de los modelos lingüísticos grandes (LLM), tras su potente modelo lingüístico de código abierto DeepSeek-R1. Recientemente, DeepSeek AI presentó oficialmente una innovadora tecnología llamada ajuste de crítica con principios propios (Self-Principled Critique Tuning, SPCT), destinada a construir modelos de recompensa de IA (Reward Models, RM) más generales y escalables. Esta tecnología promete mejorar significativamente la capacidad de la IA para comprender y responder en tareas abiertas y entornos complejos, allanando el camino para aplicaciones de IA más inteligentes.

Contexto: Modelos de recompensa — la "guía" del aprendizaje por refuerzo

En el desarrollo de LLM avanzados, el aprendizaje por refuerzo (Reinforcement Learning, RL) se ha convertido en una tecnología clave. El RL utiliza señales de retroalimentación para guiar el ajuste fino del modelo, permitiéndole generar respuestas de mayor calidad. En este proceso, los modelos de recompensa juegan un papel crucial, como un "árbitro" que evalúa la salida del LLM y proporciona una puntuación o "recompensa" correspondiente. Estas señales de recompensa guían eficazmente el proceso de RL, impulsando al LLM a aprender a generar contenido más útil.

Sin embargo, los modelos de recompensa actuales también enfrentan varias limitaciones. Suelen destacar en áreas estrechas con reglas claras o respuestas fáciles de verificar; por ejemplo, el excelente rendimiento de modelos como DeepSeek-R1 en problemas matemáticos y de programación se debe a las "respuestas correctas" claramente definidas en dichas áreas. Sin embargo, para consultas de dominio general complejas, abiertas o subjetivas, construir un modelo de recompensa eficaz sigue siendo un gran desafío. Los investigadores de DeepSeek AI señalan en su artículo: "Los modelos de recompensa generales necesitan generar recompensas de alta calidad fuera de dominios específicos, donde los estándares de recompensa son más diversos y complejos, y a menudo no hay respuestas de referencia o estándares claros."

SPCT: Abordando cuatro desafíos para crear un modelo de recompensa general

Para superar las limitaciones de los modelos de recompensa existentes, los investigadores de DeepSeek AI propusieron la nueva tecnología SPCT. Destacan cuatro desafíos clave que deben abordarse para construir modelos de recompensa generales:

- Flexibilidad de entrada (Input flexibility): Los modelos de recompensa deben poder procesar diversos tipos de entrada y evaluar simultáneamente una o más respuestas.

- Precisión (Accuracy): En diversos dominios complejos y estándar que carecen de respuestas claras, los modelos de recompensa deben generar señales de recompensa precisas.

- Escalabilidad en tiempo de inferencia (Inference-time scalability): Al asignar más recursos computacionales para la inferencia, los modelos de recompensa deberían generar recompensas de mayor calidad.

- Aprendizaje de comportamientos escalables (Learning scalable behaviors): Para que los modelos de recompensa se puedan escalar eficazmente en tiempo de inferencia, deben aprender comportamientos que mejoren su rendimiento a medida que aumentan los recursos computacionales.

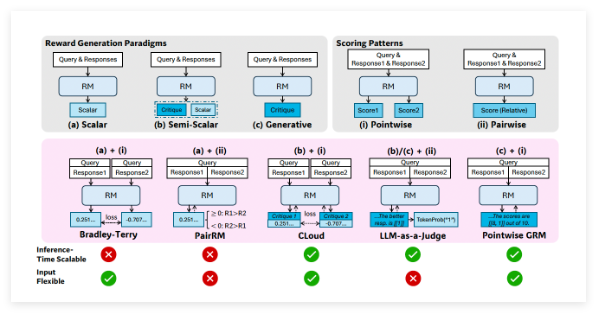

Los investigadores señalan que el "modelado de recompensa generativa puntual" (Pointwise Generative Reward Modeling, GRM), es decir, el método por el cual el modelo genera comentarios de texto y de ahí deriva puntuaciones, puede proporcionar la flexibilidad y escalabilidad necesarias para tareas generales. Los experimentos preliminares del equipo DeepSeek en modelos como GPT-4o y Gemma-2-27B sugieren que "ciertos principios pueden guiar a los modelos de recompensa generativos a generar recompensas dentro de los estándares apropiados, mejorando así la calidad de las recompensas", lo que les inspiró a explorar si la escalabilidad en tiempo de inferencia de los modelos de recompensa se podía lograr ampliando la generación de principios de alta calidad y comentarios precisos.

El mecanismo central de SPCT: Principios propios y ajuste de crítica

Basándose en estos hallazgos, el equipo DeepSeek desarrolló la tecnología SPCT, que entrena a GRM para generar dinámicamente principios y comentarios según la consulta y la respuesta. Los investigadores argumentan que los principios deben ser "parte de la generación de recompensas, no un paso de preprocesamiento". De esta manera, GRM puede generar principios sobre la marcha según la tarea que está evaluando y luego generar comentarios críticos basados en esos principios.

SPCT consta de dos fases principales:

- Ajuste fino por rechazo (Rejective fine-tuning): Esta fase entrena a GRM para generar principios y comentarios con el formato correcto para diversos tipos de entrada. El modelo genera principios, comentarios y recompensas para una consulta/respuesta dada. Solo se aceptan las trayectorias generadas si la recompensa predicha coincide con la realidad (por ejemplo, la identificación correcta de la mejor respuesta), de lo contrario, se rechazan. Este proceso se repite, y el modelo se ajusta finamente en los ejemplos filtrados para mejorar su capacidad de generación de principios/comentarios.

- Aprendizaje por refuerzo basado en reglas (Rule-based RL): En esta fase, el modelo se ajusta finamente aún más mediante el aprendizaje por refuerzo basado en resultados. GRM genera principios y comentarios para cada consulta, y la señal de recompensa se calcula utilizando reglas de precisión simples (por ejemplo, si se seleccionó la mejor respuesta conocida). Luego, el modelo se actualiza para alentar a GRM a aprender a generar principios y comentarios precisos de forma dinámica y escalable.

Para abordar el desafío de la escalabilidad en tiempo de inferencia, los investigadores ejecutan GRM varias veces en la misma entrada, generando diferentes conjuntos de principios y comentarios. La recompensa final se determina mediante votación (agregación de puntuaciones de muestra). Esto permite que el modelo considere perspectivas más amplias, generando así juicios más precisos y matizados cuando se dispone de más recursos.

Además, para abordar el problema de que algunos principios/comentarios generados pueden ser de baja calidad o estar sesgados, los investigadores introdujeron un "modelo de recompensa meta" (meta RM): un RM escalar separado y ligero, específicamente para predecir si los principios/comentarios generados por el GRM principal probablemente conducirán a una recompensa final correcta. Durante la inferencia, el meta RM evalúa las muestras generadas y filtra los juicios de baja calidad, mejorando aún más el rendimiento de escalabilidad.

El excelente rendimiento de DeepSeek-GRM

Los investigadores aplicaron SPCT al modelo de código abierto de Google Gemma-2-27B, creando DeepSeek-GRM-27B. En varias pruebas de referencia, lo compararon con varios RM de referencia potentes (incluidos LLM-as-a-Judge, RM escalares y RM semi-escalares), así como modelos públicos (como GPT-4o y Nemotron-4-340B-Reward). Los resultados muestran que DeepSeek-GRM-27B supera a los métodos de referencia entrenados en los mismos datos.

En comparación con el ajuste fino estándar, SPCT mejora significativamente la calidad de las recompensas y, lo que es más importante, mejora la escalabilidad en tiempo de inferencia. Al escalar la inferencia generando más muestras, el rendimiento de DeepSeek-GRM-27B aumenta considerablemente, incluso superando a modelos más grandes como Nemotron-4-340B-Reward y GPT-4o. La introducción del meta RM mejora aún más la escalabilidad, logrando los mejores resultados mediante el filtrado de juicios. Los investigadores señalan: "Mediante un muestreo a mayor escala, DeepSeek-GRM puede realizar juicios más precisos basándose en principios más diversos y generar recompensas más refinadas". Curiosamente, en comparación con los RM escalares que funcionan bien en tareas verificables pero mal en otros aspectos, SPCT muestra menos sesgo en diferentes dominios.

El desarrollo de modelos de recompensa más generales y escalables tiene un gran potencial para las aplicaciones de IA a nivel empresarial. Las áreas que podrían beneficiarse incluyen tareas creativas y aplicaciones donde el modelo debe adaptarse a entornos dinámicos (como las preferencias cambiantes de los clientes).

A pesar de los resultados notables, DeepSeek-GRM aún presenta desafíos en términos de rendimiento y eficiencia en tareas puramente verificables en comparación con los RM no generativos. El equipo de DeepSeek indica que el trabajo futuro se centrará en mejorar la eficiencia y la integración más profunda. Concluyen: "Las direcciones futuras podrían incluir la integración de GRM en los flujos de RL en línea como una interfaz general para los sistemas de recompensas, la exploración de la escalabilidad colaborativa en tiempo de inferencia con modelos de políticas o como un evaluador fuera de línea robusto para modelos básicos."

Artículo:https://arxiv.org/abs/2504.02495