L'équipe Qwen d'Alibaba a récemment lancé QwQ-32B, le dernier membre de sa famille de grands modèles linguistiques (LLM) open source. Ce modèle d'inférence de 32 milliards de paramètres vise à améliorer les performances sur les tâches de résolution de problèmes complexes grâce au renforcement par apprentissage (RL).

QwQ-32B est disponible en open source sur Hugging Face et ModelScope sous licence Apache2.0. Cela signifie que le modèle peut être utilisé à des fins commerciales et de recherche. Les entreprises peuvent l'intégrer directement dans leurs produits et applications, y compris les services payants. Les utilisateurs individuels peuvent également accéder au modèle via Qwen Chat.

QwQ, acronyme de Qwen-with-Questions, est un modèle d'inférence open source initialement lancé par Alibaba en novembre 2024. Son objectif est de rivaliser avec le modèle o1-preview d'OpenAI. Le QwQ original améliore son raisonnement logique et ses capacités de planification en examinant et en améliorant ses propres réponses pendant le processus d'inférence, excellant notamment dans les tâches mathématiques et de codage.

La version initiale de QwQ, avec ses 32 milliards de paramètres et une longueur de contexte de 32 000 jetons, a surpassé o1-preview sur des benchmarks mathématiques comme AIME et MATH, ainsi que sur des tâches de raisonnement scientifique comme GPQA. Cependant, les versions précédentes de QwQ étaient relativement faibles sur des benchmarks de programmation comme LiveCodeBench et présentaient des défis tels que le mélange de langues et des raisonnements circulaires occasionnels.

Malgré cela, Alibaba a choisi de publier le modèle sous licence Apache2.0, le différenciant des alternatives propriétaires comme o1 d'OpenAI, permettant ainsi aux développeurs et aux entreprises de l'adapter et de le commercialiser librement. Avec l'évolution du domaine de l'IA, les limites des LLM traditionnels deviennent de plus en plus apparentes, l'amélioration des performances apportée par l'extension à grande échelle ralentissant progressivement. Cela a stimulé l'intérêt pour les grands modèles d'inférence (LRM). Les LRM améliorent la précision grâce à l'inférence à l'inférence et à l'autoréflexion, comme le montre la série o3 d'OpenAI et DeepSeek-R1.

Le dernier QwQ-32B, grâce à l'intégration du renforcement par apprentissage et de l'auto-questionnement structuré, améliore encore ses performances et vise à devenir un concurrent majeur dans le domaine de l'IA inférentielle. Les recherches de l'équipe QwQ montrent que le renforcement par apprentissage peut considérablement améliorer la capacité du modèle à résoudre des problèmes complexes. QwQ-32B utilise une méthode d'entraînement par renforcement par apprentissage en plusieurs étapes pour améliorer le raisonnement mathématique, les capacités de codage et la résolution de problèmes généraux.

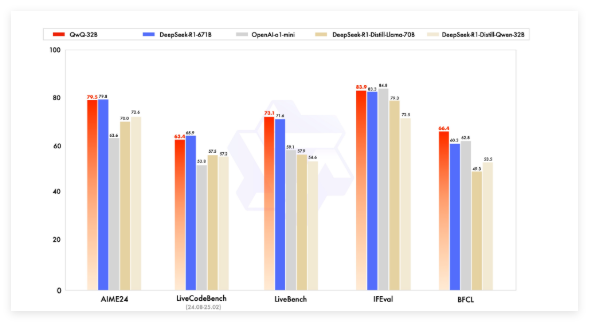

Lors des tests de référence, QwQ-32B a été comparé à des modèles de pointe tels que DeepSeek-R1, o1-mini et DeepSeek-R1-Distilled-Qwen-32B, obtenant des résultats compétitifs malgré un nombre de paramètres inférieur à certains concurrents. Par exemple, DeepSeek-R1 possède 671 milliards de paramètres (37 milliards activés), tandis que QwQ-32B, avec des performances comparables, nécessite moins de mémoire vive, généralement 24 Go de VRAM sur GPU, alors que l'exécution de DeepSeek R1 complet nécessite plus de 1500 Go de VRAM.

QwQ-32B utilise une architecture de modèle linguistique causal et a subi plusieurs optimisations, notamment 64 couches Transformer, RoPE, SwiGLU, RMSNorm et Attention QKV bias. Il utilise également l'attention de requête généralisée (GQA), possède une longueur de contexte étendue de 131 072 jetons et a subi un entraînement en plusieurs étapes, comprenant le pré-entraînement, l'ajustement fin supervisé et le renforcement par apprentissage.

Le processus de renforcement par apprentissage de QwQ-32B se déroule en deux phases : la première se concentre sur les capacités mathématiques et de codage, utilisant un vérificateur de précision et un serveur d'exécution de code pour l'entraînement. La deuxième phase utilise un modèle de récompense général et un vérificateur basé sur des règles pour l'entraînement par récompense, afin d'améliorer le suivi des instructions, l'alignement humain et les capacités d'inférence par agent, sans compromettre ses capacités mathématiques et de codage.

QwQ-32B possède également des capacités agentiques, capables d'adapter dynamiquement le processus d'inférence en fonction des retours de l'environnement. L'équipe Qwen recommande d'utiliser des paramètres d'inférence spécifiques pour obtenir des performances optimales et prend en charge le déploiement avec vLLM.

L'équipe Qwen considère QwQ-32B comme une première étape pour améliorer les capacités d'inférence grâce à l'extension du renforcement par apprentissage. Elle prévoit d'explorer plus avant l'extension du renforcement par apprentissage, d'intégrer les agents et le renforcement par apprentissage pour réaliser une inférence à long terme, et de continuer à développer des modèles de base optimisés pour le renforcement par apprentissage, afin de progresser vers une intelligence artificielle générale (AGI).

Modèle : https://qwenlm.github.io/blog/qwq-32b/

Points clés :

🚀 Alibaba lance QwQ-32B, un grand modèle d'inférence open source, utilisant la technique du renforcement par apprentissage pour améliorer la résolution de problèmes complexes.

💡 QwQ-32B offre des performances comparables à celles de modèles à plus grand nombre de paramètres dans les tests de référence mathématiques et de programmation, avec une consommation mémoire plus faible. Il est disponible en open source sous licence Apache2.0 et peut être utilisé gratuitement à des fins commerciales.

🧠 Ce modèle possède une longueur de contexte étendue (130 000 jetons) et des capacités agentiques. De futures recherches exploreront le potentiel du renforcement par apprentissage pour améliorer l'intelligence des modèles.