Des chercheurs de Meta et de l'Université de Waterloo ont récemment dévoilé MoCha, un nouveau système d'IA capable de générer des personnages animés complets avec synchronisation vocale et mouvements naturels à partir de simples descriptions textuelles. Cette technologie innovante promet d'améliorer considérablement l'efficacité et l'expressivité de la création de contenu, et présente un potentiel d'application immense dans de nombreux domaines.

Une rupture avec les traditions : animation du corps entier et synchronisation labiale précise

Contrairement aux modèles d'IA précédents qui se concentraient principalement sur les expressions faciales, MoCha se distingue par sa capacité à restituer des mouvements naturels du corps entier. Que ce soit en gros plan ou en plan moyen, le système génère des mouvements détaillés en fonction du texte, incluant la synchronisation labiale, les gestes et les interactions entre plusieurs personnages. Les premières démonstrations se sont concentrées sur le haut du corps, montrant comment le système fait correspondre précisément la bouche du personnage au dialogue, et comment le langage corporel s'accorde naturellement au sens du texte.

Pour une synchronisation labiale plus précise, l'équipe de recherche a introduit de manière innovante un mécanisme d'"attention fenêtre audio-vidéo". Ce mécanisme résout efficacement deux défis de longue date dans la génération de vidéos par IA : la compression d'informations lors du traitement vidéo lorsque l'audio conserve sa résolution complète, et le décalage de la bouche lors de la génération vidéo parallèle. Le principe fondamental consiste à limiter l'accès de chaque image à des données audio dans une fenêtre de portée spécifique. Cette méthode imite le fonctionnement de la parole humaine : les mouvements de la bouche dépendent du son immédiat, tandis que le langage corporel suit des schémas textuels plus larges. En ajoutant des marqueurs avant et après chaque segment audio, MoCha génère des transitions plus fluides et une synchronisation labiale plus précise.

Gestion aisée de plusieurs personnages, système d'invite simple et efficace

Pour gérer les scènes à plusieurs personnages, l'équipe MoCha a développé un système d'invite simple et efficace. L'utilisateur n'a qu'à définir une fois les informations sur les personnages, puis les référencer dans différentes scènes à l'aide de simples étiquettes (par exemple, « Person1 », « Person2 »). Cette méthode évite la description répétitive et fastidieuse des personnages, simplifiant ainsi la création d'animations à plusieurs personnages.

Performances exceptionnelles, surpassant les systèmes concurrents

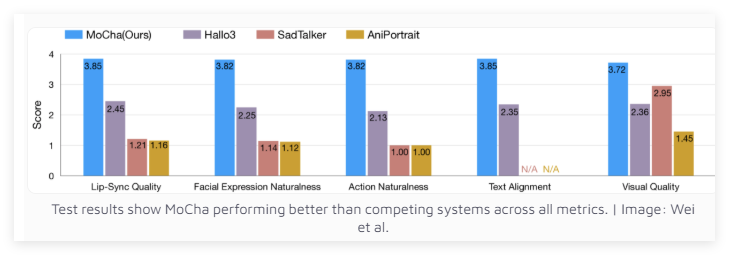

Après des tests dans 150 scénarios différents, MoCha surpasse les systèmes concurrents en termes de synchronisation labiale et de qualité des mouvements naturels. Des évaluateurs indépendants ont salué le réalisme des vidéos générées par MoCha. Les résultats des tests montrent que MoCha surpasse ses concurrents sur tous les indicateurs.

L'équipe de recherche de Meta estime que MoCha présente un potentiel d'application immense dans les domaines des assistants numériques, des avatars virtuels, de la publicité et du contenu éducatif. Cependant, Meta n'a pas encore révélé si le système serait open source ou resterait un prototype de recherche. Il est à noter que le développement de MoCha intervient à un moment crucial où les grandes entreprises de médias sociaux rivalisent pour développer des technologies vidéo basées sur l'IA.

Meta avait précédemment lancé MovieGen, et ByteDance, la société mère de TikTok, développe activement son propre système d'animation par IA, notamment INFP, OmniHuman-1 et Goku. Cette course à la technologie vidéo par IA ne manquera pas d'accélérer le progrès et l'adoption de ces technologies.

Accès au projet : https://top.aibase.com/tool/mocha