चीन के बहुप्रतीक्षित आर्टिफिशियल इंटेलिजेंस रिसर्च लैब, DeepSeek AI ने अपने शक्तिशाली ओपन-सोर्स भाषा मॉडल DeepSeek-R1 के बाद, बड़े भाषा मॉडल (LLM) के क्षेत्र में एक और महत्वपूर्ण सफलता हासिल की है। हाल ही में, DeepSeek AI ने आत्म-सिद्धांतवादी आलोचना ट्यूनिंग (Self-Principled Critique Tuning, संक्षेप में SPCT) नामक एक नई तकनीक शुरू की है, जिसका उद्देश्य अधिक सामान्य और अधिक स्केलेबल AI पुरस्कार मॉडल (Reward Models, संक्षेप में RMs) बनाना है। इस तकनीक से AI की खुले कार्य और जटिल वातावरणों में समझ और प्रतिक्रिया करने की क्षमता में उल्लेखनीय रूप से सुधार होने की उम्मीद है, जिससे अधिक बुद्धिमान AI अनुप्रयोगों का मार्ग प्रशस्त होगा।

पृष्ठभूमि: पुरस्कार मॉडल - सुदृढीकरण अधिगम का "दिशा निर्देशक"

उन्नत LLM के विकास में, सुदृढीकरण अधिगम (Reinforcement Learning, संक्षेप में RL) एक महत्वपूर्ण तकनीक बन गया है। RL मॉडल के ठीक-ठीक समायोजन का मार्गदर्शन करने के लिए प्रतिक्रिया संकेतों का परिचय देता है, जिससे यह उच्च गुणवत्ता वाले उत्तर उत्पन्न कर सकता है। और इस प्रक्रिया में, पुरस्कार मॉडल एक महत्वपूर्ण भूमिका निभाता है, जैसे एक "रेफरी", जो LLM के आउटपुट का मूल्यांकन करता है और उसके अनुसार स्कोर या "पुरस्कार" देता है। ये पुरस्कार संकेत RL प्रक्रिया को प्रभावी ढंग से निर्देशित कर सकते हैं, जिससे LLM अधिक उपयोगी सामग्री सीख सकता है।

हालांकि, वर्तमान पुरस्कार मॉडल भी कई सीमाओं का सामना करते हैं। वे अक्सर स्पष्ट नियमों या आसानी से सत्यापित उत्तरों वाले संकीर्ण क्षेत्रों में अच्छा प्रदर्शन करते हैं, उदाहरण के लिए DeepSeek-R1 जैसे मॉडल गणित और प्रोग्रामिंग समस्याओं में उत्कृष्ट प्रदर्शन करते हैं, क्योंकि इन समस्याओं में स्पष्ट "सही उत्तर" होते हैं। लेकिन, जटिल, खुले या अधिक व्यक्तिपरक सामान्य क्षेत्रों के प्रश्नों के लिए, एक प्रभावी पुरस्कार मॉडल बनाना अभी भी एक बड़ी चुनौती है। DeepSeek AI के शोधकर्ताओं ने अपने शोध पत्र में कहा है: "सामान्य पुरस्कार मॉडल को विशिष्ट क्षेत्रों के बाहर उच्च-गुणवत्ता वाले पुरस्कार उत्पन्न करने की आवश्यकता होती है, और इन क्षेत्रों में पुरस्कार मानदंड अधिक विविध और जटिल होते हैं, और अक्सर स्पष्ट संदर्भ या मानक उत्तर नहीं होते हैं।"

SPCT: चार चुनौतियों का सामना करना, एक सामान्य पुरस्कार मॉडल बनाना

मौजूदा पुरस्कार मॉडल की सीमाओं को दूर करने के लिए, DeepSeek AI के शोधकर्ताओं ने SPCT नामक एक नई तकनीक प्रस्तावित की है। उन्होंने सामान्य पुरस्कार मॉडल के निर्माण के लिए चार प्रमुख चुनौतियों पर जोर दिया है:

- इनपुट लचीलापन (Input flexibility): पुरस्कार मॉडल को विभिन्न प्रकार के इनपुट को संभालने में सक्षम होना चाहिए, और एक या एक से अधिक उत्तरों का मूल्यांकन एक साथ कर सकता है।

- शुद्धता (Accuracy): मानक जटिल और स्पष्ट उत्तरों की कमी वाले विभिन्न क्षेत्रों में, पुरस्कार मॉडल को सटीक पुरस्कार संकेत उत्पन्न करने में सक्षम होना चाहिए।

- अनुमान समय स्केलेबिलिटी (Inference-time scalability): जब अनुमान के लिए अधिक कंप्यूटिंग संसाधन आवंटित किए जाते हैं, तो पुरस्कार मॉडल को उच्च गुणवत्ता वाले पुरस्कार उत्पन्न करने में सक्षम होना चाहिए।

- सीखने योग्य स्केलेबल व्यवहार (Learning scalable behaviors): पुरस्कार मॉडल को अनुमान समय में प्रभावी ढंग से स्केल करने के लिए, उन्हें ऐसे व्यवहार सीखने की आवश्यकता होती है जो कंप्यूटिंग संसाधनों में वृद्धि के साथ प्रदर्शन में सुधार कर सकें।

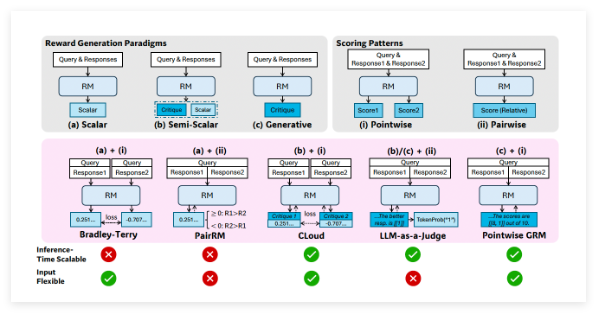

शोधकर्ताओं ने बताया कि "बिंदुवार जनरेटिव पुरस्कार मॉडलिंग" (Pointwise Generative Reward Modeling, GRM), अर्थात् मॉडल पाठ टिप्पणियाँ उत्पन्न करता है और उनसे स्कोर प्राप्त करता है, सामान्य कार्यों के लिए आवश्यक लचीलापन और स्केलेबिलिटी प्रदान कर सकता है। DeepSeek टीम ने GPT-4o और Gemma-2-27B जैसे मॉडल पर प्रारंभिक प्रयोगों में दिखाया कि "कुछ सिद्धांत जनरेटिव पुरस्कार मॉडल को उपयुक्त मानकों के भीतर पुरस्कार उत्पन्न करने के लिए निर्देशित कर सकते हैं, जिससे पुरस्कार की गुणवत्ता में सुधार होता है", इसने उन्हें उच्च-गुणवत्ता वाले सिद्धांतों और सटीक टिप्पणियों के उत्पादन का विस्तार करके पुरस्कार मॉडल की अनुमान समय स्केलेबिलिटी को प्राप्त करने के लिए प्रेरित किया।

SPCT का मूल तंत्र: आत्म-सिद्धांतवादी सिद्धांत और आलोचनात्मक ट्यूनिंग

उपरोक्त निष्कर्षों के आधार पर, DeepSeek टीम ने SPCT तकनीक विकसित की है, जो GRM को क्वेरी और प्रतिक्रिया के अनुसार गतिशील रूप से सिद्धांत और टिप्पणियाँ उत्पन्न करने के लिए प्रशिक्षित करती है। शोधकर्ताओं का मानना है कि सिद्धांत "पुरस्कार उत्पादन का हिस्सा होना चाहिए, न कि पूर्व-संसाधन चरण"। इस तरह, GRM अपने द्वारा मूल्यांकन किए जा रहे कार्य के अनुसार तुरंत सिद्धांत उत्पन्न कर सकता है, और फिर इन सिद्धांतों के आधार पर आलोचनात्मक टिप्पणियाँ उत्पन्न कर सकता है।

SPCT में दो मुख्य चरण शामिल हैं:

- अस्वीकृति ठीक-ठीक समायोजन (Rejective fine-tuning): इस चरण में GRM को विभिन्न प्रकार के इनपुट के लिए सिद्धांत और टिप्पणियाँ उत्पन्न करने के लिए सही प्रारूप का उपयोग करने के लिए प्रशिक्षित किया जाता है। मॉडल किसी दिए गए क्वेरी/प्रतिक्रिया के लिए सिद्धांत, टिप्पणियाँ और पुरस्कार उत्पन्न करता है। केवल तभी जब अनुमानित पुरस्कार वास्तविक स्थिति (उदाहरण के लिए, बेहतर प्रतिक्रिया की सही पहचान) के अनुरूप होता है, तो उत्पन्न प्रक्षेपवक्र को स्वीकार किया जाता है, अन्यथा इसे अस्वीकार कर दिया जाता है। यह प्रक्रिया बार-बार दोहराई जाती है, और मॉडल को फ़िल्टर किए गए उदाहरणों पर ठीक-ठीक समायोजित किया जाता है ताकि इसकी सिद्धांत/टिप्पणी उत्पादन क्षमता में सुधार हो सके।

- नियम-आधारित RL (Rule-based RL): इस चरण में, मॉडल को परिणाम-आधारित सुदृढीकरण अधिगम के माध्यम से आगे ठीक-ठीक समायोजित किया जाता है। GRM प्रत्येक क्वेरी के लिए सिद्धांत और टिप्पणियाँ उत्पन्न करता है, और पुरस्कार संकेत सरल सटीकता नियमों (उदाहरण के लिए, क्या ज्ञात सर्वोत्तम प्रतिक्रिया का चयन किया गया है) के आधार पर गणना किए जाते हैं। फिर मॉडल को अपडेट किया जाता है ताकि GRM को गतिशील और स्केलेबल तरीके से प्रभावी सिद्धांत और सटीक टिप्पणियाँ उत्पन्न करना सिखाया जा सके।

अनुमान समय स्केलेबिलिटी की चुनौती का समाधान करने के लिए, शोधकर्ताओं ने GRM को एक ही इनपुट पर कई बार चलाया, जिससे विभिन्न सिद्धांतों और टिप्पणियों का सेट उत्पन्न हुआ। अंतिम पुरस्कार को वोटिंग (नमूना स्कोर को एकत्रित करना) द्वारा निर्धारित किया जाता है। इससे मॉडल अधिक व्यापक दृष्टिकोणों पर विचार कर सकता है, जिससे अधिक संसाधन प्राप्त होने पर अधिक सटीक और सूक्ष्म अंतिम निर्णय उत्पन्न हो सकता है।

इसके अलावा, कुछ उत्पन्न सिद्धांतों/टिप्पणियों की गुणवत्ता कम या पक्षपाती होने की समस्या का समाधान करने के लिए, शोधकर्ताओं ने एक "मेटा पुरस्कार मॉडल" (meta RM) पेश किया है - एक अलग, हल्का स्केलर RM, जो विशेष रूप से यह अनुमान लगाने के लिए डिज़ाइन किया गया है कि मुख्य GRM द्वारा उत्पन्न सिद्धांत/टिप्पणियाँ सही अंतिम पुरस्कार का कारण बन सकती हैं या नहीं। अनुमान प्रक्रिया में, मेटा RM उत्पन्न नमूनों का मूल्यांकन करता है और निम्न-गुणवत्ता वाले निर्णयों को फ़िल्टर करता है, जिससे स्केलेबिलिटी में और सुधार होता है।

DeepSeek-GRM का उत्कृष्ट प्रदर्शन

शोधकर्ताओं ने SPCT को Google के ओपन-सोर्स मॉडल Gemma-2-27B पर लागू किया, जिससे DeepSeek-GRM-27B बनाया गया। कई बेंचमार्क परीक्षणों में, उन्होंने इसकी तुलना कई शक्तिशाली बेसलाइन RM (LLM-as-a-Judge, स्केलर RM और सेमी-स्केलर RM सहित) और सार्वजनिक मॉडल (जैसे GPT-4o और Nemotron-4-340B-Reward) से की। परिणामों से पता चला है कि DeepSeek-GRM-27B समान डेटा पर प्रशिक्षित बेसलाइन विधियों से बेहतर प्रदर्शन करता है।

मानक ठीक-ठीक समायोजन की तुलना में, SPCT ने पुरस्कार की गुणवत्ता में उल्लेखनीय रूप से सुधार किया है, और इससे भी महत्वपूर्ण बात यह है कि अनुमान समय स्केलेबिलिटी में सुधार हुआ है। अधिक नमूनों को उत्पन्न करके अनुमान समय स्केलिंग के माध्यम से, DeepSeek-GRM-27B का प्रदर्शन बहुत अधिक बढ़ गया है, यहां तक कि बड़े मॉडल जैसे Nemotron-4-340B-Reward और GPT-4o से भी अधिक। मेटा RM की शुरूआत से स्केलेबिलिटी में और सुधार हुआ है, जिससे निर्णयों को फ़िल्टर करके सर्वोत्तम परिणाम प्राप्त हुए हैं। शोधकर्ताओं ने कहा: "बड़े पैमाने पर नमूनाकरण के माध्यम से, DeepSeek-GRM अधिक विविध सिद्धांतों के आधार पर अधिक सटीक निर्णय ले सकता है और अधिक सूक्ष्म पुरस्कारों का उत्पादन कर सकता है।" दिलचस्प बात यह है कि स्केलर RM की तुलना में, जो सत्यापन योग्य कार्यों पर अच्छा प्रदर्शन करते हैं लेकिन अन्य क्षेत्रों में खराब प्रदर्शन करते हैं, SPCT विभिन्न क्षेत्रों में कम पूर्वाग्रह दिखाता है।

अधिक सामान्य और स्केलेबल पुरस्कार मॉडल का विकास उद्यम-स्तरीय AI अनुप्रयोगों के लिए व्यापक संभावनाएँ प्रदान करता है। संभावित लाभकारी क्षेत्रों में रचनात्मक कार्य और ऐसे अनुप्रयोग शामिल हैं जहाँ मॉडल को गतिशील वातावरण (जैसे लगातार बदलती ग्राहक प्राथमिकताएँ) के अनुकूल होना चाहिए।

उल्लेखनीय परिणाम प्राप्त करने के बावजूद, गैर-जनरेटिव RM की तुलना में, DeepSeek-GRM अभी भी विशुद्ध रूप से सत्यापन योग्य कार्यों पर प्रदर्शन और दक्षता के मामले में चुनौतियों का सामना करता है। DeepSeek टीम ने कहा कि भविष्य के काम में दक्षता में सुधार और गहन एकीकरण पर ध्यान केंद्रित किया जाएगा। उन्होंने कहा: "भविष्य की दिशाओं में पुरस्कार प्रणाली के सामान्य इंटरफ़ेस के रूप में ऑनलाइन RL प्रक्रियाओं में GRM को एकीकृत करना, नीति मॉडल के साथ अनुमान समय सहयोगी स्केलिंग का पता लगाना, या आधार मॉडल के लिए एक मजबूत ऑफ़लाइन मूल्यांकक के रूप में शामिल हो सकता है।"

शोध पत्र:https://arxiv.org/abs/2504.02495