Recentemente, a ByteDance lançou um novo framework de sincronização labial chamado LatentSync, projetado para alcançar uma sincronização labial mais precisa usando um modelo de difusão latente condicionado a áudio. Este framework é baseado no Stable Diffusion e foi otimizado para consistência temporal.

Diferentemente dos métodos anteriores baseados em difusão no espaço de pixels ou geração em duas etapas, o LatentSync usa uma abordagem de ponta a ponta, sem representação de movimento intermediária, permitindo modelar diretamente a complexa relação entre áudio e visual.

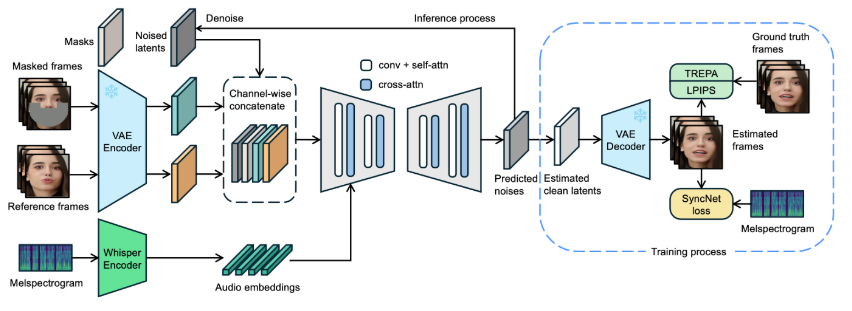

No framework LatentSync, o espectrograma de áudio é primeiro convertido em embeddings de áudio usando o Whisper, e integrado ao modelo U-Net através de uma camada de atenção cruzada. O framework usa a concatenação em nível de canal do frame de referência e do frame mascarado com a variável latente ruidosa como entrada para a U-Net.

Durante o treinamento, um método de etapa única é usado para estimar a variável latente limpa a partir do ruído previsto, que é então decodificada para gerar o frame limpo. Simultaneamente, o modelo introduz o mecanismo Temporal REPresentation Alignment (TREPA) para melhorar a consistência temporal, garantindo que o vídeo gerado seja temporalmente coerente, além de ter precisão na sincronização labial.

Para demonstrar a eficácia da tecnologia, o projeto fornece uma série de vídeos de exemplo, mostrando os vídeos originais e os vídeos processados com sincronização labial. Através dos exemplos, os usuários podem sentir intuitivamente o progresso significativo do LatentSync na sincronização labial de vídeo.

Vídeo original:

Vídeo de saída:

Além disso, o projeto planeja abrir o código de inferência e os checkpoints, facilitando o treinamento e os testes dos usuários. Para usuários que desejam experimentar a inferência, basta baixar os arquivos de pesos do modelo necessários. O fluxo de processamento de dados completo também foi projetado, abrangendo todas as etapas, do processamento de arquivos de vídeo ao alinhamento facial, garantindo que os usuários possam começar facilmente.

Página do projeto do modelo: https://github.com/bytedance/LatentSync

Destaques:

🌟 LatentSync é um framework de sincronização labial de ponta a ponta baseado em um modelo de difusão latente condicionado a áudio, sem representação de movimento intermediária.

🎤 Este framework utiliza o Whisper para converter o espectrograma de áudio em embeddings, melhorando a precisão e a consistência temporal do processo de sincronização labial.

📹 O projeto fornece uma série de vídeos de exemplo e planeja abrir o código e o fluxo de processamento de dados, facilitando o uso e o treinamento pelos usuários.