Gemma-2B-10M

Gemma 2B模型,支持10M序列长度,优化内存使用,适用于大规模语言模型应用。

普通产品编程语言模型注意力机制

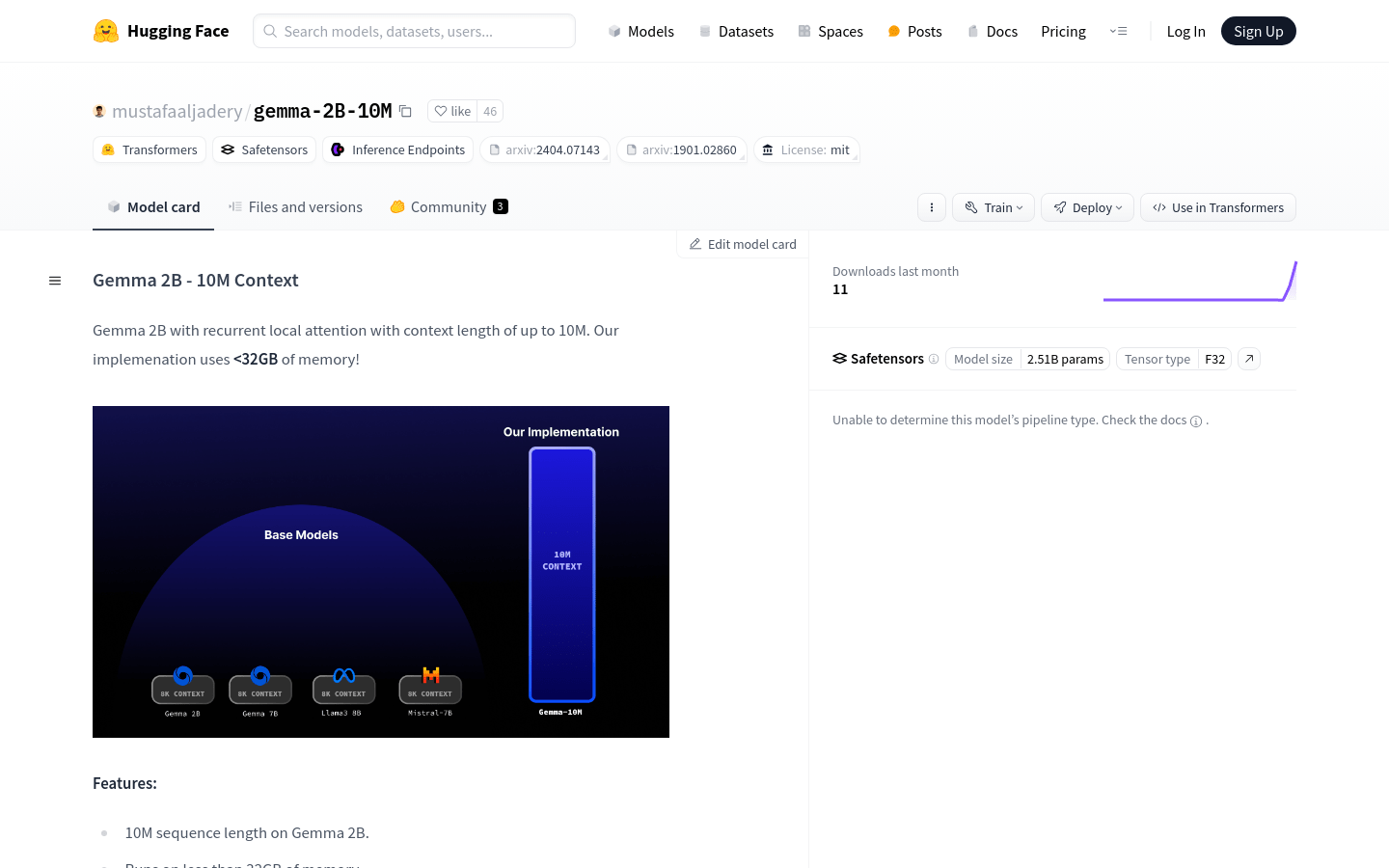

Gemma 2B - 10M Context是一个大规模的语言模型,它通过创新的注意力机制优化,能够在内存使用低于32GB的情况下处理长达10M的序列。该模型采用了循环局部注意力技术,灵感来源于Transformer-XL论文,是处理大规模语言任务的强大工具。

Gemma-2B-10M 最新流量情况

月总访问量

26103677

跳出率

43.69%

平均页面访问数

5.5

平均访问时长

00:04:43