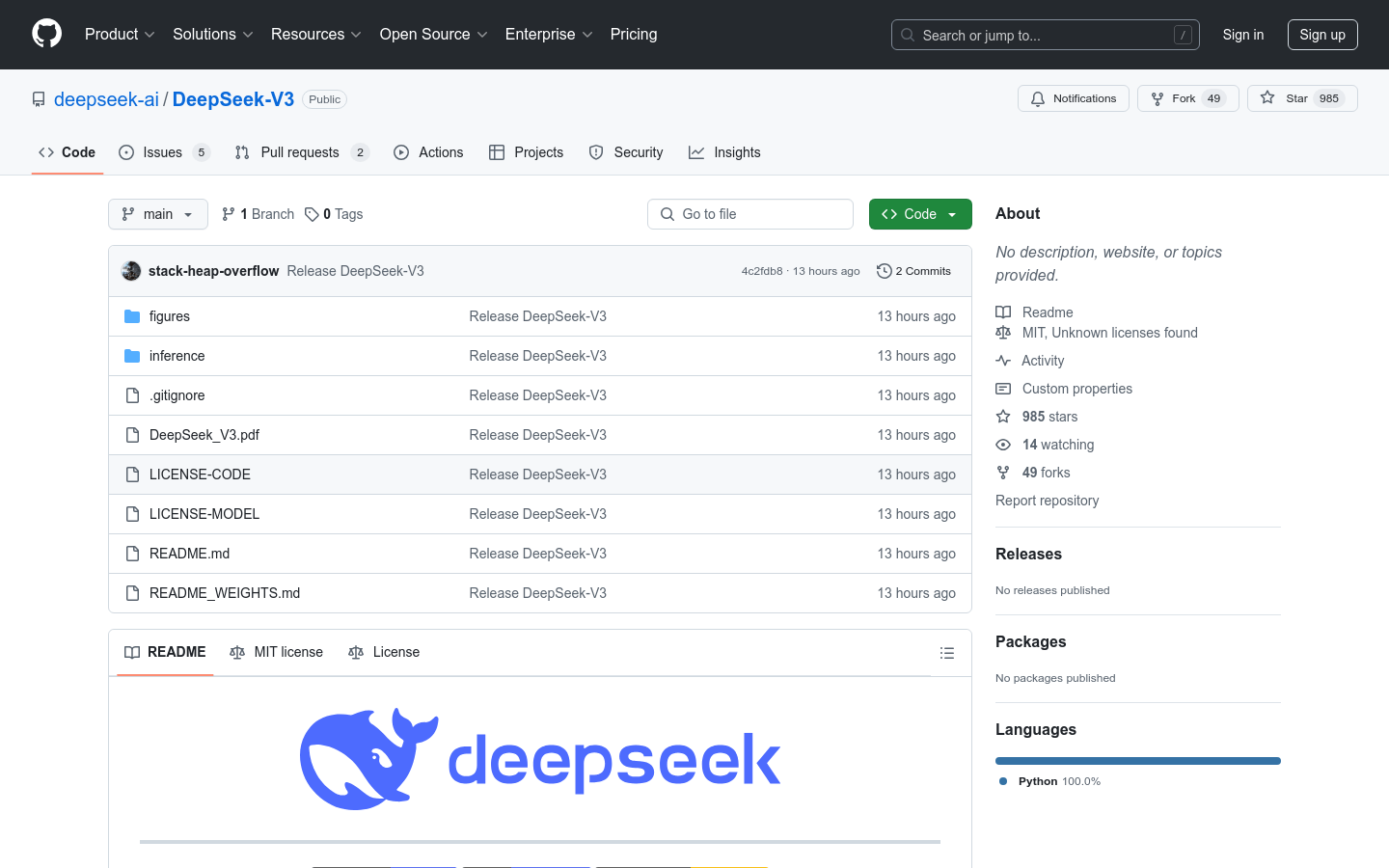

DeepSeek-V3

一款具有671B参数的Mixture-of-Experts语言模型。

中文精选生产力自然语言处理深度学习

DeepSeek-V3是一个强大的Mixture-of-Experts (MoE) 语言模型,拥有671B的总参数量,每次激活37B参数。它采用了Multi-head Latent Attention (MLA) 和 DeepSeekMoE架构,这些架构在DeepSeek-V2中得到了充分的验证。此外,DeepSeek-V3首次采用了无辅助损失的负载均衡策略,并设置了多令牌预测训练目标,以实现更强大的性能。DeepSeek-V3在14.8万亿高质量令牌上进行了预训练,随后进行了监督式微调和强化学习阶段,以充分利用其能力。综合评估显示,DeepSeek-V3超越了其他开源模型,并达到了与领先的闭源模型相当的性能。尽管性能出色,DeepSeek-V3的完整训练仅需要2.788M H800 GPU小时,并且训练过程非常稳定。

DeepSeek-V3 最新流量情况

月总访问量

502571820

跳出率

37.10%

平均页面访问数

5.9

平均访问时长

00:06:29