Memória

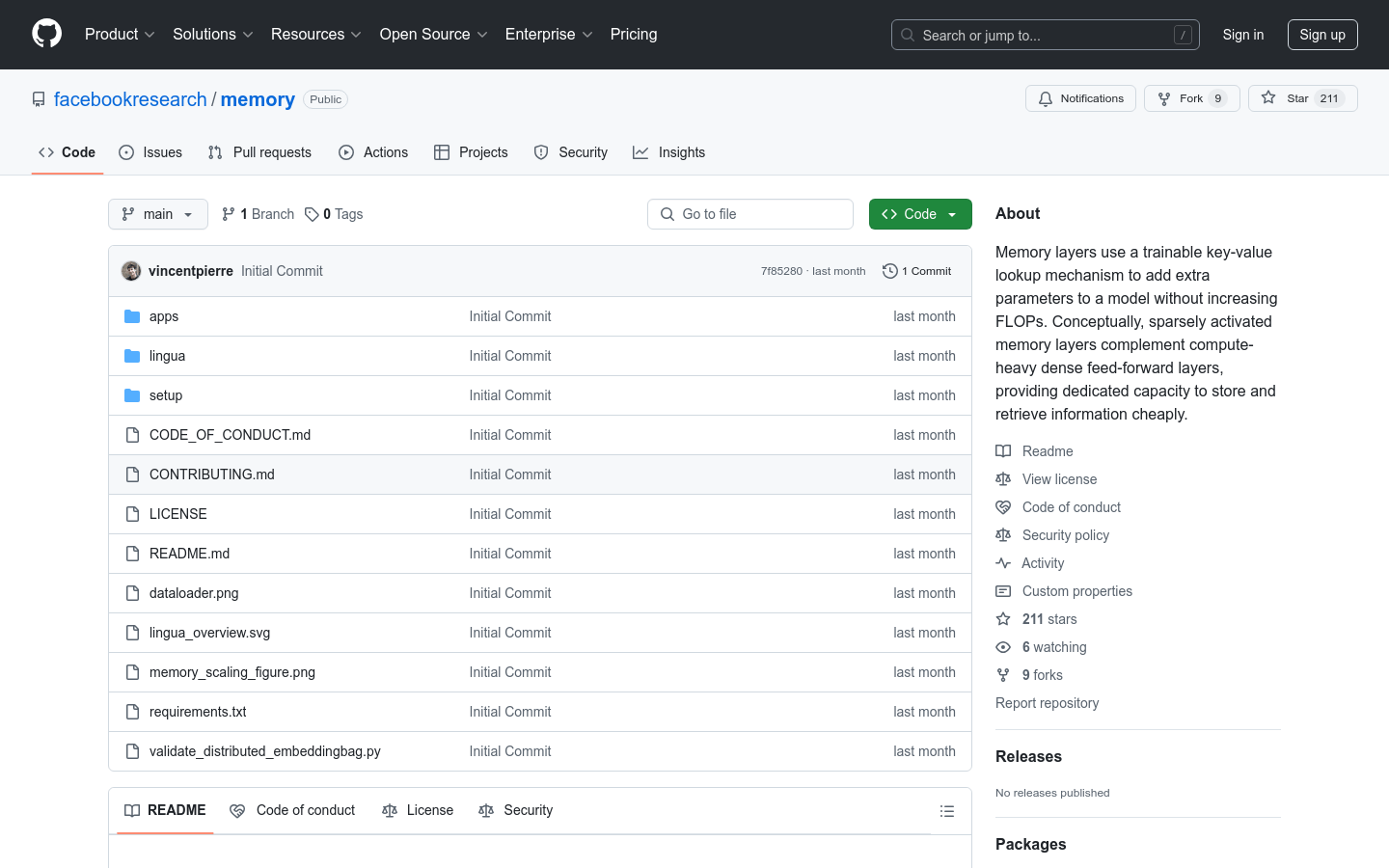

Implementação de uma camada de memória escalável, que permite expandir os parâmetros do modelo sem aumentar a carga computacional.

Memória Situação do Tráfego Mais Recente

Total de Visitas Mensais

474564576

Taxa de Rejeição

36.20%

Média de Páginas por Visita

6.1

Duração Média da Visita

00:06:34