Das in San Francisco ansässige KI-Startup Cosine hat ein neues KI-Modell namens Genie vorgestellt, das speziell für die Unterstützung von Softwareentwicklern entwickelt wurde. Laut dem Unternehmen übertrifft Genie die Konkurrenz in Benchmarks deutlich und zeigt außergewöhnliche Fähigkeiten.

Cosine arbeitete mit OpenAI zusammen und trainierte eine GPT-4-Variante mit hochwertigen Daten, was zu bemerkenswerten Benchmark-Ergebnissen führte. Das Unternehmen erklärt, der Schlüssel zum Erfolg von Genie liege in seiner Fähigkeit zum „kodierenden menschlichen Schlussfolgern“, einer Fähigkeit, die möglicherweise nicht nur auf die Softwareentwicklung beschränkt ist.

Genie übernimmt die Führung im Bereich SWE

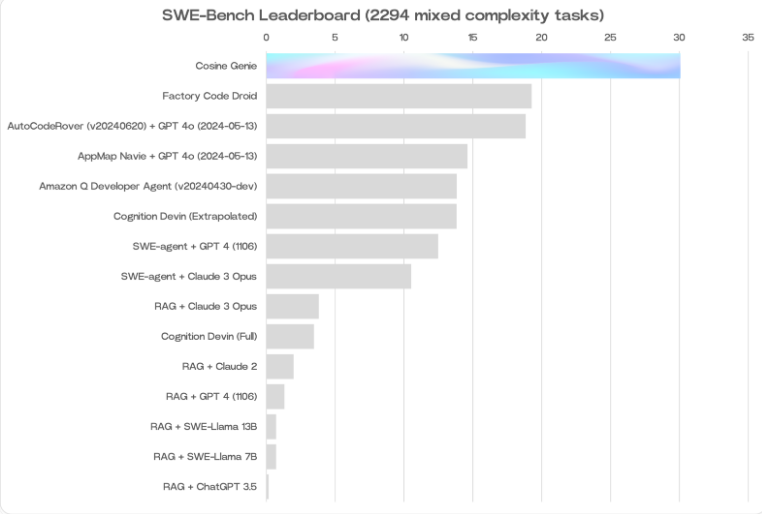

Alistair Pullen, Mitbegründer und CEO von Cosine, gab bekannt, dass Genie im SWE-Bench-Test eine Punktzahl von 30 % erreicht hat – die bisher höchste Punktzahl eines KI-Modells in diesem Bereich. Dieses Ergebnis übertrifft andere auf das Codieren spezialisierte Sprachmodelle wie das Modell von Amazon (19 %) und Cognitions Devin (13,8 % in Teilen des SWE-Bench-Tests).

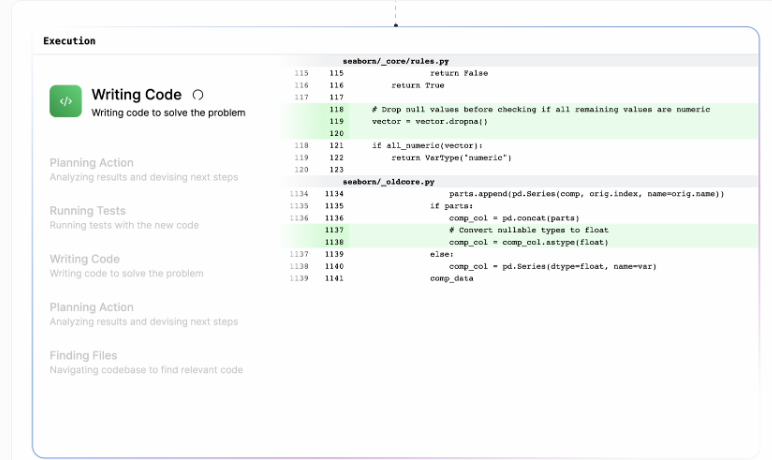

Die Architektur von Genie zielt darauf ab, die kognitiven Prozesse menschlicher Entwickler nachzuahmen. Es kann eigenständig oder kollaborativ Fehler beheben, neue Funktionen entwickeln, Code umstrukturieren und verschiedene Programmieraufgaben ausführen.

Selbstverbesserung durch synthetische Daten

Bei der Entwicklung von Genie wurde ein proprietärer Prozess verwendet, bei dem eine nicht öffentlich zugängliche GPT-4-Variante mit Milliarden hochwertiger Daten trainiert und feinabgestimmt wurde. Cosine verbrachte fast ein Jahr damit, diese Daten mit Hilfe erfahrener Entwickler zu kuratieren. Der Datensatz enthält 21 % JavaScript und Python, 14 % TypeScript und TSX sowie 3 % anderer Sprachen (einschließlich Java, C++ und Ruby).

Die hervorragende Leistung von Genie ist teilweise auf sein selbstverbesserndes Training zurückzuführen. Anfangs lernte das Modell hauptsächlich aus perfektem, effizientem Code, war aber bei der Behandlung eigener Fehler verwirrt. Cosine löste dieses Problem durch die Verwendung synthetischer Daten: Wenn Genies anfängliche Lösung falsch war, wurde dem Modell gezeigt, wie sie durch das richtige Ergebnis verbessert werden kann. Mit jeder Iteration wurden Genies Lösungen immer besser und die benötigte Anzahl an Korrekturen verringerte sich.

Überwindung technischer Grenzen

Pullen erkannte bereits Anfang 2022 das Potenzial großer Sprachmodelle bei der Unterstützung menschlicher Softwareentwicklung. Die damalige Technologie war jedoch noch nicht ausgereift genug, um die Vision von Genie zu verwirklichen. Die Token-Kapazität des Kontextfensters war oft auf 4000 Token begrenzt, was einen großen Engpass darstellte. Heute können Modelle wie Gemini 1.5 Pro bis zu 2 Millionen Token in einer einzigen Aufforderung verarbeiten. Obwohl Cosine die genaue Token-Kapazität von Genie noch nicht bekannt gegeben hat, bildete dieser technologische Fortschritt zweifellos eine solide Grundlage für Genies Erfolg.