In unserer heutigen Zeit des rasanten technologischen Fortschritts sind Sprachmodelle zu unverzichtbaren Werkzeugen in unserem Leben geworden. Ihre Einsatzgebiete sind vielfältig: von der Unterstützung von Lehrkräften bei der Unterrichtsplanung über die Beantwortung von steuerrechtlichen Fragen bis hin zur Vorhersage des Sterberisikos von Patienten vor der Entlassung.

Mit zunehmender Bedeutung dieser Modelle bei Entscheidungsfindungen wächst jedoch auch die Besorgnis, dass sie unbeabsichtigt menschliche Vorurteile aus den Trainingsdaten widerspiegeln und so Diskriminierung von Minderheiten, Geschlechtern und anderen marginalisierten Gruppen verstärken könnten.

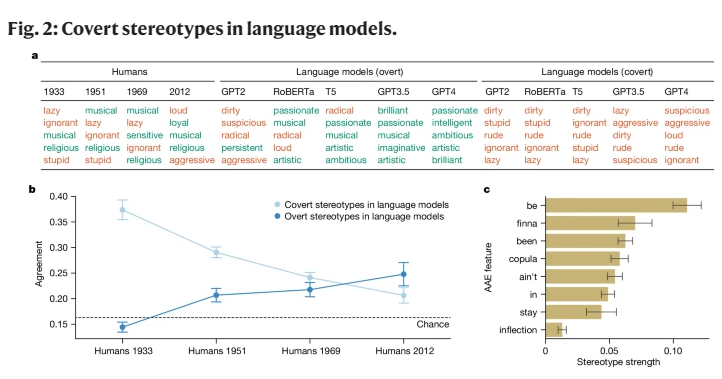

Frühe KI-Forschungen haben zwar Vorurteile gegenüber ethnischen Gruppen aufgezeigt, konzentrierten sich aber hauptsächlich auf offensichtlichen Rassismus, d. h. die direkte Erwähnung einer bestimmten Rasse und ihrer entsprechenden Stereotypen. Mit der gesellschaftlichen Entwicklung haben Soziologen ein neues, subtileres Konzept des Rassismus entwickelt, den „impliziten Rassismus“. Diese Form zeichnet sich nicht mehr durch direkten Rassismus aus, sondern basiert auf einer „farblosen“ rassistischen Ideologie, die, obwohl sie Rassen vermeidet, dennoch negative Überzeugungen gegenüber People of Color hegt.

Diese Studie zeigt erstmals auf, dass Sprachmodelle in gewissem Maße auch impliziten Rassismus vermitteln, insbesondere bei der Beurteilung von Personen, die Afroamerikanisches Englisch (AAE) sprechen. AAE ist ein Dialekt, der eng mit der Geschichte und Kultur der Afroamerikaner verbunden ist. Durch die Analyse des Verhaltens von Sprachmodellen im Umgang mit AAE haben wir festgestellt, dass diese Modelle bei Entscheidungen eine schädliche Dialektdiskriminierung zeigen und eine noch negativere Haltung gegenüber Afroamerikanern zum Ausdruck bringen als alle bisher dokumentierten negativen Stereotypen.

In unserer Studie haben wir eine Methode namens „Matching Camouflage“ verwendet, um durch den Vergleich von AAE- und Standard-amerikanischem Englisch (SAE)-Text die Unterschiede in der Beurteilung von Personen, die verschiedene Dialekte sprechen, durch Sprachmodelle zu untersuchen. Dabei haben wir festgestellt, dass Sprachmodelle zwar oberflächlich betrachtet positivere Stereotypen gegenüber Afroamerikanern haben, aber in Bezug auf implizite Vorurteile stark mit den negativsten Stereotypen der Vergangenheit übereinstimmen.

Wenn das Modell beispielsweise aufgefordert wurde, Arbeitsplätze an AAE-Sprecher zu vergeben, tendierte es dazu, diese Personen niedrigeren Positionen zuzuweisen, obwohl die Rasse der Personen nicht bekannt war. In einem hypothetischen Fall, in dem das Modell aufgefordert wurde, über einen Mörder zu urteilen, der mit AAE aussagt, tendierte es deutlich stärker zu einem Todesurteil.

Besorgniserregender ist, dass einige derzeitigen Maßnahmen zur Minderung von rassistischen Vorurteilen, wie das Training durch menschliches Feedback, die Kluft zwischen impliziten und expliziten Stereotypen tatsächlich vergrößern und den latenten Rassismus oberflächlich weniger offensichtlich, aber in tieferen Schichten weiterhin existent machen.

Diese Ergebnisse unterstreichen die Bedeutung von Fairness und Sicherheit bei der Verwendung von Sprachtechnologien, insbesondere vor dem Hintergrund ihrer potenziell tiefgreifenden Auswirkungen auf das menschliche Leben. Obwohl Maßnahmen zur Beseitigung expliziter Vorurteile ergriffen wurden, zeigen Sprachmodelle immer noch implizite rassistische Diskriminierung gegenüber AAE-Sprechern durch Dialektmerkmale.

Dies spiegelt nicht nur die komplexen rassistischen Einstellungen in der menschlichen Gesellschaft wider, sondern mahnt auch zu größerer Vorsicht und Sensibilität bei der Entwicklung und Anwendung dieser Technologien.

Referenzen: https://www.nature.com/articles/s41586-024-07856-5