Das KI-Videounternehmen Genmo hat kürzlich Mochi1 vorgestellt, ein brandneues Open-Source-Modell zur Videogenerierung, mit dem Benutzer mithilfe von Textprompts hochwertige Videos erstellen können. Mochi1 liefert Ergebnisse, die mit den führenden, geschlossenen Konkurrenzprodukten auf dem Markt wie Runway, Lumas Dream Machine, Kuaishous Keling und Minimax' Hailuo vergleichbar sind, teilweise sogar besser.

Das Modell steht unter der Apache2.0-Lizenz zur Verfügung, sodass Benutzer die Spitzentechnologie der Videogenerierung kostenlos nutzen können, während die Preise der Konkurrenzprodukte von eingeschränkten kostenlosen Plänen bis zu 94,99 US-Dollar pro Monat reichen.

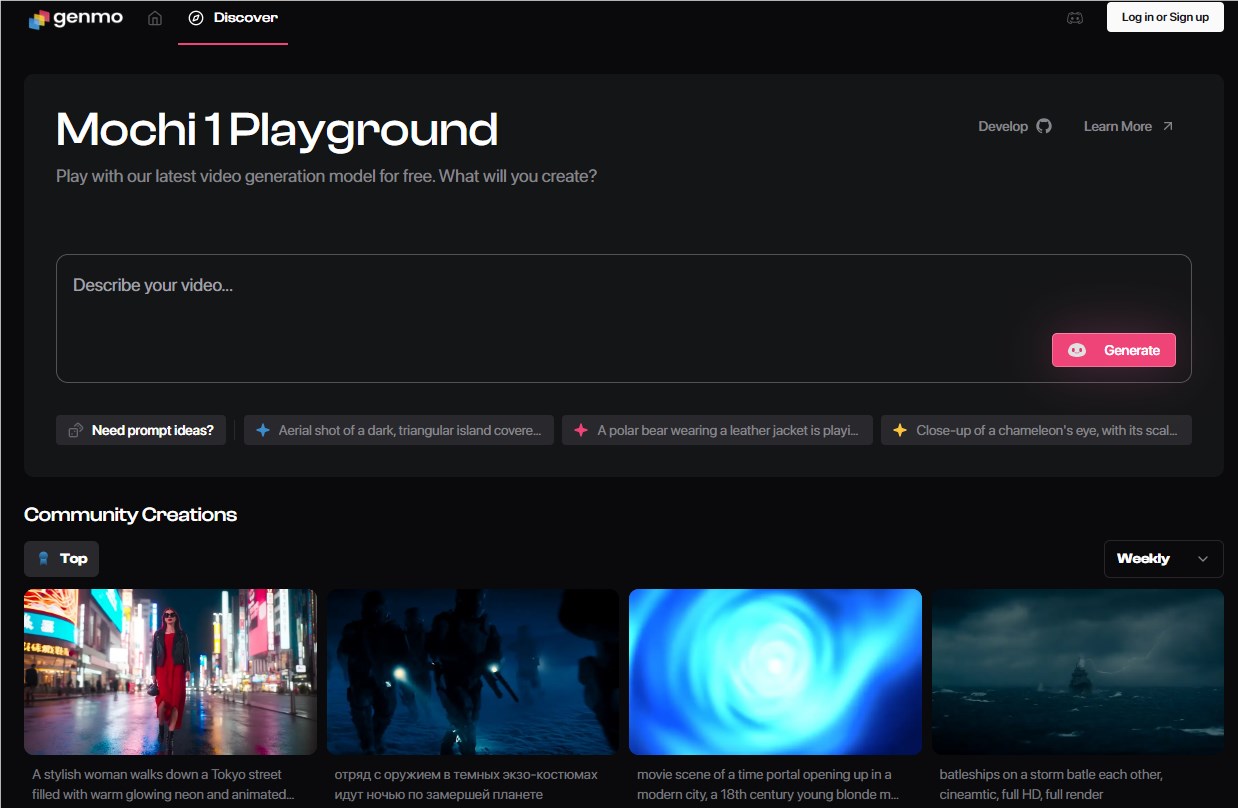

Die Modellgewichte und der Code von Mochi1 können kostenlos auf Hugging Face heruntergeladen werden. Um das Modell jedoch auf einem persönlichen Gerät auszuführen, werden mindestens vier Nvidia H100-GPUs benötigt. Um Nutzern den Zugang zu Mochi1 zu ermöglichen, bietet Genmo eine Online-Testplattform an.

Beispiele für mit Mochi1 generierte Videos:

Laut Genmo ist Mochi1 hervorragend darin, detaillierte Anweisungen zu befolgen und ermöglicht eine präzise Steuerung von Charakteren, Umgebungen und Aktionen in den generierten Videos. Genmo behauptet, dass Mochi1 in internen Tests die meisten anderen KI-Videomodelle, einschließlich der proprietären Konkurrenten Runway und Luna, in Bezug auf Geschwindigkeit und Bewegungsqualität übertroffen hat.

Mochi1 hat im Bereich der Videogenerierung bemerkenswerte Fortschritte erzielt, darunter eine hochgenaue Bewegungsdarstellung und präzise Anweisungsbefolgung. Genmos CEO Paras Jain erklärte, dass es ihr Ziel sei, die Kluft zwischen Open-Source- und proprietären Videogenerierungsmodellen zu verringern. Er betonte, dass Video die wichtigste Kommunikationsform sei und sie diese Technologie daher für mehr Menschen zugänglich machen wollen.

Gleichzeitig gab Genmo den Abschluss einer Series-A-Finanzierungsrunde in Höhe von 28,4 Millionen US-Dollar bekannt, an der NEA und mehrere Risikokapitalgesellschaften beteiligt waren. Jain wies darauf hin, dass die Videogenerierung nicht nur für Unterhaltung oder Content-Erstellung gedacht sei, sondern auch ein wichtiges Werkzeug für zukünftige Roboter und autonome Systeme darstelle.

Die Architektur von Mochi1 basiert auf Genmos eigenem asymmetrischen Diffusions-Transformator (AsymmDiT), dem bisher größten veröffentlichten Open-Source-Modell zur Videogenerierung mit bis zu 10 Milliarden Parametern. Dieses Modell konzentriert sich auf visuelle Schlussfolgerung, wodurch es bei der Verarbeitung von Videodaten besser abschneidet.

Beispiele für mit Mochi1 generierte Videos:

Obwohl Mochi1 bereits beeindruckende Fähigkeiten zeigt, gibt es noch einige Einschränkungen. Derzeit wird eine Auflösung von 480p unterstützt, und bei komplexen Bewegungsszenen können leichte visuelle Verzerrungen auftreten. Genmo plant, noch in diesem Jahr eine Mochi1HD-Version mit 720p-Auflösung zu veröffentlichen, um das Benutzererlebnis zu verbessern.

Testzugang: https://www.genmo.ai/play

Modelldownload: https://huggingface.co/genmo/mochi-1-preview

Wichtigste Punkte:

🌟 Mochi1 ist ein von Genmo entwickeltes Open-Source-Modell zur Videogenerierung, das kostenlos genutzt werden kann und mit mehreren proprietären Produkten vergleichbar ist.

💰 Genmo hat eine Series-A-Finanzierungsrunde in Höhe von 28,4 Millionen US-Dollar abgeschlossen, um die Demokratisierung der KI-Videotechnologie voranzutreiben.

🎥 Eine Mochi1HD-Version wird in Zukunft veröffentlicht, um die derzeitigen Einschränkungen der 480p-Auflösung und komplexer Bewegungsszenen zu beheben.