Große Sprachmodelle (LLMs) wie die GPT-Serie zeigen dank riesiger Datensätze erstaunliche Fähigkeiten in Sprachverständnis, Schlussfolgerung und Planung und erreichen in verschiedenen herausfordernden Aufgaben ein menschenähnliches Niveau. Die meisten Forschungsarbeiten konzentrieren sich darauf, diese Modelle durch Training mit noch größeren Datensätzen weiter zu verbessern, mit dem Ziel, leistungsstärkere Basismodelle zu entwickeln.

Doch während das Training leistungsstärkerer Basismodelle entscheidend ist, sind sich Forscher einig, dass die Fähigkeit von Modellen, sich auch in der Inferenzphase kontinuierlich weiterzuentwickeln – also die AI-Selbstentwicklung – ebenso wichtig für den Fortschritt der KI ist. Im Vergleich zum Training von Modellen mit massiven Datenmengen benötigt die Selbstentwicklung möglicherweise nur begrenzte Daten oder Interaktionen.

Inspiriert von der säulenartigen Struktur der menschlichen Großhirnrinde gehen die Forscher davon aus, dass KI-Modelle durch iterative Interaktion mit ihrer Umgebung emergente kognitive Fähigkeiten entwickeln und interne Repräsentationsmodelle aufbauen können.

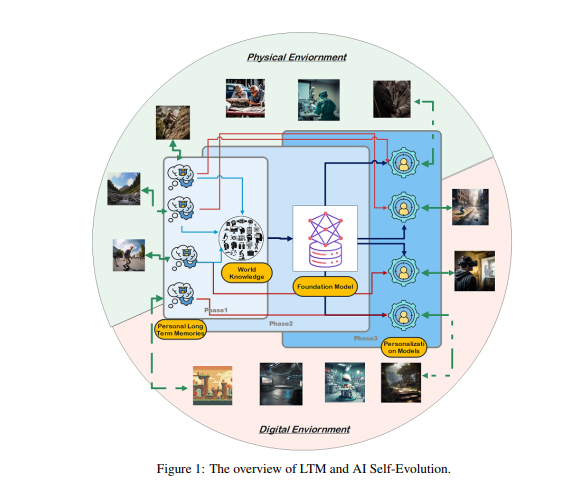

Um dieses Ziel zu erreichen, argumentieren die Forscher, dass Modelle ein Langzeitgedächtnis (LTM) benötigen, um verarbeitete Daten aus der Interaktion mit der realen Welt zu speichern und zu verwalten. Das LTM kann nicht nur langlebige individuelle Daten in statistischen Modellen repräsentieren, sondern auch die Selbstentwicklung fördern, indem es Erfahrungen über verschiedene Umgebungen und Agenten hinweg unterstützt.

LTM ist der Schlüssel zur AI-Selbstentwicklung. Ähnlich wie Menschen durch persönliche Erfahrungen und Interaktionen mit ihrer Umwelt ständig lernen und sich verbessern, basiert die Selbstentwicklung von KI-Modellen auf den im Laufe der Interaktion gesammelten LTM-Daten. Anders als bei der menschlichen Evolution ist die LTM-gesteuerte Modellentwicklung nicht auf Interaktionen mit der realen Welt beschränkt. Modelle können, wie Menschen, mit der physischen Umgebung interagieren und direktes Feedback erhalten, das nach der Verarbeitung ihre Fähigkeiten verbessert. Dies ist ein wichtiger Forschungsbereich der verkörperten KI.

Andererseits können Modelle auch in virtuellen Umgebungen interagieren und LTM-Daten sammeln. Dies ist im Vergleich zur Interaktion mit der realen Welt kostengünstiger und effizienter und verbessert die Fähigkeiten effektiver.

Der Aufbau von LTM erfordert die Raffination und Strukturierung von Rohdaten. Rohdaten sind die Gesamtheit aller unverarbeiteten Daten, die ein Modell durch Interaktion mit der externen Umgebung oder während des Trainings erhält. Diese Daten enthalten verschiedene Beobachtungen und Aufzeichnungen, die möglicherweise wertvolle Muster und eine große Menge an redundanten oder irrelevanten Informationen enthalten.

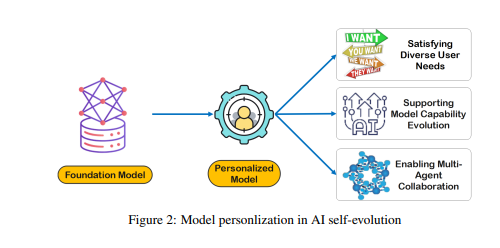

Obwohl Rohdaten die Grundlage für das Gedächtnis und die Kognition des Modells bilden, müssen sie weiterverarbeitet werden, um Aufgaben effektiv und personalisiert auszuführen. Das LTM verfeinert und strukturiert diese Rohdaten, so dass das Modell sie verwenden kann. Dieser Prozess verbessert die Fähigkeit des Modells, personalisierte Antworten und Empfehlungen zu geben.

Der Aufbau von LTM steht vor Herausforderungen wie Datensparsamkeit und Benutzerdiversität. In einem kontinuierlich aktualisierten LTM-System ist Datensparsamkeit ein häufiges Problem, insbesondere bei Benutzern mit begrenzter Interaktionshistorie oder sporadischen Aktivitäten, was das Modelltraining erschwert. Darüber hinaus erhöht die Benutzerdiversität die Komplexität und erfordert, dass das Modell sowohl individuelle Muster berücksichtigt als auch effektiv über verschiedene Benutzergruppen hinweg generalisiert.

Die Forscher haben ein Omne genanntes Multi-Agenten-Zusammenarbeitssystem entwickelt, das auf LTM basiert und die AI-Selbstentwicklung ermöglicht. In diesem Framework verfügt jeder Agent über eine unabhängige Systemstruktur, kann autonom lernen und ein vollständiges Umgebungsmodell speichern und so ein unabhängiges Verständnis der Umgebung aufbauen. Durch diese auf LTM basierende Zusammenarbeit kann das KI-System sich in Echtzeit an Veränderungen des individuellen Verhaltens anpassen, die Aufgabenplanung und -ausführung optimieren und die personalisierte und effiziente AI-Selbstentwicklung weiter fördern.

Das Omne-Framework erreichte den ersten Platz im GAIA-Benchmark und beweist das enorme Potenzial von LTM für die AI-Selbstentwicklung und die Lösung realer Probleme. Die Forscher sind überzeugt, dass die Weiterentwicklung der LTM-Forschung für die kontinuierliche Entwicklung und praktische Anwendung von KI-Technologien, insbesondere im Bereich der Selbstentwicklung, unerlässlich ist.

Zusammenfassend lässt sich sagen, dass das Langzeitgedächtnis der Schlüssel zur AI-Selbstentwicklung ist und es KI-Modellen ermöglicht, wie Menschen aus Erfahrung zu lernen und sich zu verbessern. Der Aufbau und die Nutzung von LTM erfordern die Bewältigung von Herausforderungen wie Datensparsamkeit und Benutzerdiversität. Das Omne-Framework bietet eine praktikable Lösung für die auf LTM basierende AI-Selbstentwicklung, und sein Erfolg im GAIA-Benchmark zeigt das enorme Potenzial dieses Bereichs.

Paper: https://arxiv.org/pdf/2410.15665