Das Alibaba-Tochterunternehmen Qwen hat kürzlich das neueste Mitglied seiner Open-Source-Familie großer Sprachmodelle (LLM) vorgestellt – QwQ-32B. Dieses Sprachmodell mit 32 Milliarden Parametern zielt darauf ab, die Leistung bei komplexen Problemlösungsaufgaben durch Reinforcement Learning (RL) zu verbessern.

QwQ-32B wurde auf Hugging Face und ModelScope unter der Apache2.0-Lizenz veröffentlicht. Dies bedeutet, dass das Modell für kommerzielle und Forschungszwecke verwendet werden kann. Unternehmen können es direkt in Produkte und Anwendungen integrieren, auch in kostenpflichtige Dienste. Private Nutzer können über Qwen Chat auf das Modell zugreifen.

QwQ, die Abkürzung für Qwen-with-Questions, ist ein Open-Source-Inferenzmodell, das Alibaba im November 2024 erstmals vorstellte und mit OpenAIs o1-preview konkurrieren soll. Das ursprüngliche QwQ verbesserte seine logischen Schlussfolgerungen und Planungsfähigkeiten, insbesondere bei mathematischen und Codierungsaufgaben, indem es seine Antworten während des Inferenzprozesses überprüfte und verbesserte.

Das frühere QwQ verfügte über 32 Milliarden Parameter und eine Kontextlänge von 32.000 Tokens und übertraf o1-preview in mathematischen Benchmarks wie AIME und MATH sowie in wissenschaftlichen Inferenzaufgaben wie GPQA. Allerdings war die frühere Version von QwQ in Programmier-Benchmarks wie LiveCodeBench relativ schwach und hatte mit Herausforderungen wie Sprachmischung und gelegentlichen Zirkelschlüssen zu kämpfen.

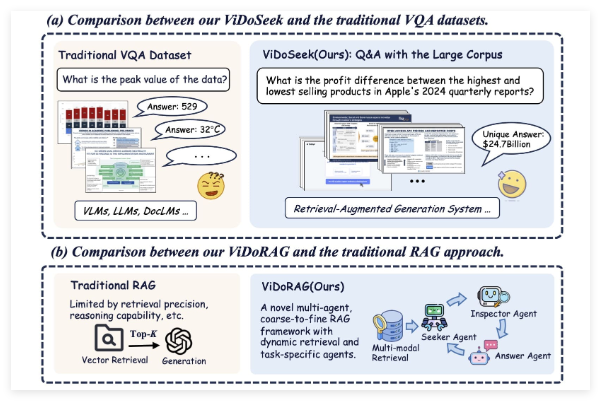

Trotzdem hat Alibaba sich für die Veröffentlichung des Modells unter der Apache2.0-Lizenz entschieden, um es von proprietären Alternativen wie OpenAIs o1 zu unterscheiden und Entwicklern und Unternehmen die freie Anpassung und Kommerzialisierung zu ermöglichen. Mit der Entwicklung des KI-Bereichs zeigen sich zunehmend die Grenzen traditioneller LLMs, und die Leistungssteigerung durch massive Skalierung verlangsamt sich. Dies hat das Interesse an großen Inferenzmodellen (LRM) geweckt. LRMs verbessern die Genauigkeit durch Inferenz während der Inferenz und Selbstreflexion, wie z. B. OpenAIs o3-Serie und DeepSeek-R1.

Das neueste QwQ-32B verbessert die Leistung durch die Integration von Reinforcement Learning und strukturiertem Selbst-Questioning und zielt darauf ab, ein wichtiger Wettbewerber im Bereich der Inferenz-KI zu werden. Die Forschung des QwQ-Teams zeigt, dass Reinforcement Learning die Fähigkeit des Modells zur Lösung komplexer Probleme deutlich verbessern kann. QwQ-32B verwendet eine mehrstufige Reinforcement-Learning-Trainingsmethode, um das mathematische Schlussfolgern, die Codierungsfähigkeit und die allgemeine Problemlösungsfähigkeit zu verbessern.

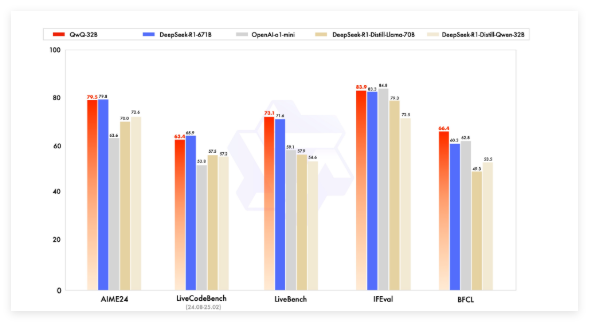

In Benchmark-Tests trat QwQ-32B gegen führende Modelle wie DeepSeek-R1, o1-mini und DeepSeek-R1-Distilled-Qwen-32B an und erzielte bei einer geringeren Parameterzahl als einige Wettbewerber wettbewerbsfähige Ergebnisse. DeepSeek-R1 verfügt beispielsweise über 671 Milliarden Parameter (37 Milliarden aktiviert), während QwQ-32B bei vergleichbarer Leistung einen wesentlich geringeren Speicherbedarf hat: in der Regel 24 GB VRAM auf einer GPU, während der Betrieb des vollständigen DeepSeek R1 über 1500 GB VRAM benötigt.

QwQ-32B verwendet eine kausale Sprachmodellarchitektur und wurde mit verschiedenen Optimierungen versehen, darunter 64 Transformer-Schichten, RoPE, SwiGLU, RMSNorm und Attention QKV Bias. Es verwendet auch verallgemeinerte Query Attention (GQA), hat eine erweiterte Kontextlänge von 131.072 Tokens und wurde in mehreren Phasen trainiert, darunter Pretraining, Supervised Fine-Tuning und Reinforcement Learning.

Der Reinforcement-Learning-Prozess von QwQ-32B ist zweistufig: Zuerst konzentriert er sich auf mathematische und Codierungsfähigkeiten und wird mit Genauigkeitsvalidierern und Code-Ausführungsservern trainiert. In der zweiten Phase wird das Modell durch ein allgemeines Belohnungsmodell und regelbasierte Validierer belohnt, um die Befolgung von Anweisungen, die menschliche Ausrichtung und die Agenten-Inferenz zu verbessern, ohne die mathematischen und Codierungsfähigkeiten zu beeinträchtigen.

QwQ-32B verfügt auch über Agentenfähigkeiten (agentic capabilities) und kann den Inferenzprozess dynamisch an das Feedback der Umgebung anpassen. Das Qwen-Team empfiehlt die Verwendung spezifischer Inferenzeinstellungen für optimale Leistung und unterstützt die Bereitstellung mit vLLM.

Das Qwen-Team betrachtet QwQ-32B als den ersten Schritt zur Verbesserung der Inferenzfähigkeiten durch erweitertes Reinforcement Learning. Zukünftige Pläne umfassen die weitere Erforschung des erweiterten Reinforcement Learning, die Integration von Agenten und Reinforcement Learning für langfristige Inferenz sowie die kontinuierliche Entwicklung von Basismodellen, die für Reinforcement Learning optimiert sind, um letztendlich die allgemeine künstliche Intelligenz (AGI) zu erreichen.

Modell:https://qwenlm.github.io/blog/qwq-32b/

Wichtigste Punkte:

🚀 Alibaba stellt das Open-Source-Inferenz-Großmodell QwQ-32B vor, das Reinforcement Learning verwendet, um die Fähigkeit zur Lösung komplexer Probleme zu verbessern.

💡 QwQ-32B zeigt in mathematischen und Programmier-Benchmarks eine vergleichbare Leistung zu Modellen mit mehr Parametern, hat einen geringeren Speicherbedarf und wird unter der Apache2.0-Lizenz veröffentlicht und kann kostenlos kommerziell genutzt werden.

🧠 Das Modell verfügt über eine erweiterte Kontextlänge (130.000 Tokens) und Agentenfähigkeiten (agentic capabilities). Zukünftig wird die Forschung zum Potenzial von Reinforcement Learning zur Verbesserung der Modellintelligenz fortgesetzt.