Im Bereich der künstlichen Intelligenz hat das Alibaba Tongyi-Labor kürzlich die Open-Source-Veröffentlichung seines neuesten multimodalen Modells – R1-Omni – angekündigt. Dieses Modell kombiniert Reinforcement Learning mit verifizierbaren Belohnungen (RLVR) und zeigt außergewöhnliche Fähigkeiten in der Verarbeitung von Audio- und Videoinformationen. Ein Highlight von R1-Omni ist seine Transparenz, die ein klareres Verständnis der Rolle der einzelnen Modalitäten im Entscheidungsprozess ermöglicht, insbesondere bei Aufgaben wie der Emotionserkennung.

Mit der Einführung von DeepSeek R1 wird das Potenzial von Reinforcement Learning in großen Modellen zunehmend erschlossen. Die RLVR-Methode bietet neue Optimierungsansätze für multimodale Aufgaben und kann komplexe Aufgaben wie geometrische Schlussfolgerungen und visuelle Zählungen effektiv bewältigen. Obwohl sich die bisherigen Forschungsarbeiten hauptsächlich auf die Kombination von Bildern und Text konzentrierten, erweitert die neueste Forschung des Tongyi-Labors dieses Feld, indem es RLVR mit einem vollständigen Videomodell kombiniert und so das breite Anwendungspotenzial der Technologie demonstriert.

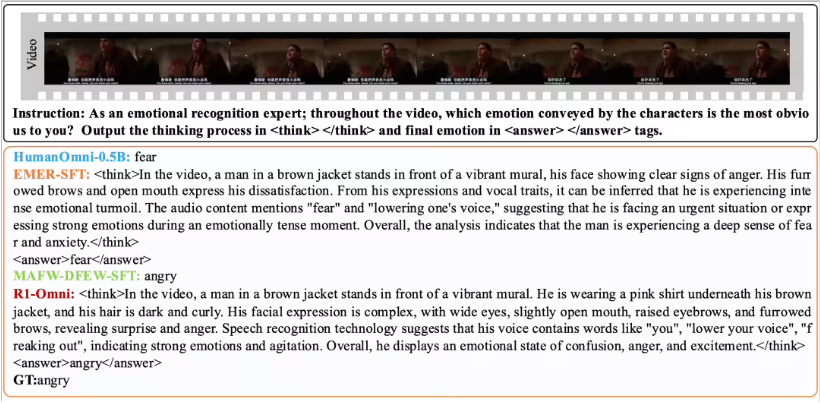

Durch die RLVR-Methode macht R1-Omni den Einfluss von Audio- und Videoinformationen anschaulicher. Bei der Emotionserkennung beispielsweise kann das Modell klar zeigen, welche Audio- und Videosignale für die Emotionsbestimmung entscheidend waren. Diese Transparenz erhöht nicht nur die Zuverlässigkeit des Modells, sondern bietet Forschern und Entwicklern auch bessere Einblicke.

Im Hinblick auf die Leistungsüberprüfung hat das Tongyi-Labor-Team Vergleichstests zwischen R1-Omni und dem ursprünglichen HumanOmni-0.5B-Modell durchgeführt. Die Ergebnisse zeigen eine deutliche Leistungssteigerung von R1-Omni auf den Datensätzen DFEW und MAFW mit einer durchschnittlichen Verbesserung von über 35 %. Darüber hinaus übertrifft R1-Omni das traditionelle Supervised Fine-Tuning (SFT)-Modell im unüberwachten Lernen (UAR) um mehr als 10 %. Auf verschiedenen Testdatensätzen (z. B. RAVDESS) zeigt R1-Omni eine hervorragende Generalisierungsfähigkeit mit einer Verbesserung von WAR und UAR um über 13 %. Diese Ergebnisse belegen nicht nur den Vorteil von RLVR bei der Verbesserung der Inferenzfähigkeit, sondern liefern auch neue Denkansätze und Richtungen für die zukünftige Forschung zu multimodalen Modellen.

Die Open-Source-Veröffentlichung von R1-Omni wird Forschern und Entwicklern mehr Möglichkeiten bieten. Es wird erwartet, dass dieses Modell in zukünftigen Anwendungen zu weiteren Innovationen und Durchbrüchen führen wird.