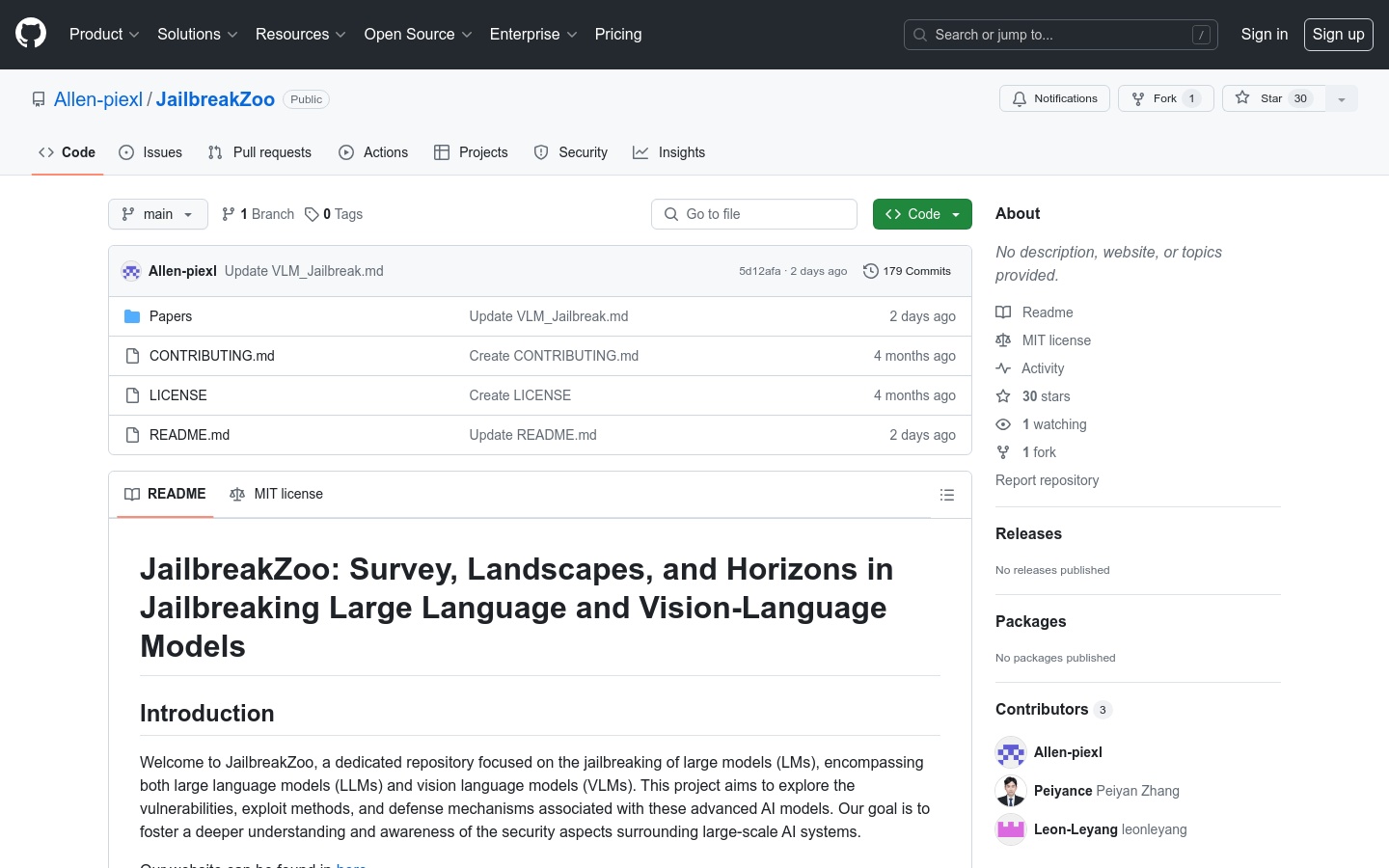

JailbreakZoo

Erforschung von Schwachstellen und Schutzmechanismen großer Sprach- und visueller Sprachmodelle

Normales ProduktProgrammierungKI-SicherheitModell-Aufbrechen

JailbreakZoo ist ein Repository, das sich auf das Aufbrechen großer Modelle (einschließlich großer Sprachmodelle und visueller Sprachmodelle) konzentriert. Das Projekt zielt darauf ab, Schwachstellen, Ausnutzungsmethoden und Abwehrmechanismen dieser hochentwickelten KI-Modelle zu untersuchen, um ein tieferes Verständnis und Wissen über die Sicherheit von großen KI-Systemen zu fördern.

JailbreakZoo Neueste Verkehrssituation

Monatliche Gesamtbesuche

474564576

Absprungrate

36.20%

Durchschnittliche Seiten pro Besuch

6.1

Durchschnittliche Besuchsdauer

00:06:34