Tras el anuncio de Meta sobre el lanzamiento de su potente modelo de código abierto Llama 3.1 ayer, Mistral AI presentó esta madrugada su modelo insignia, Mistral Large 2. Este nuevo producto cuenta con 1230 mil millones de parámetros y una enorme ventana de contexto de 128k, lo que lo hace comparable a Llama 3.1 en este aspecto.

Detalles del modelo Mistral Large 2

Mistral Large 2 tiene una ventana de contexto de 128k, admite docenas de idiomas, incluyendo francés, alemán, español, italiano, portugués, árabe, hindi, ruso, chino, japonés y coreano, así como más de 80 lenguajes de programación como Python, Java, C, C++, JavaScript y Bash.

Mistral Large 2 está diseñado para inferencia en un solo nodo, dirigido principalmente a aplicaciones de contexto largo. Su tamaño de 1230 mil millones de parámetros le permite funcionar con un alto rendimiento en un solo nodo. Mistral Large 2 se publica bajo la licencia de investigación de Mistral, destinada a fines de investigación y no comerciales; para usos comerciales, los usuarios deben contactar para obtener una licencia comercial.

Rendimiento general:

En términos de rendimiento, Mistral Large 2 establece un nuevo estándar en los indicadores de evaluación, logrando una precisión del 84.0% en la prueba de referencia MMLU, mostrando un excelente equilibrio entre rendimiento y costo del servicio.

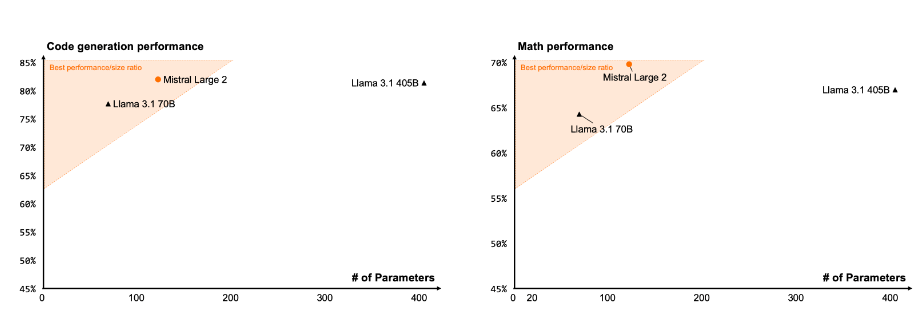

Código e inferencia

Gracias a la experiencia en el entrenamiento de Codestral 22B y Codestral Mamba, Mistral Large 2 muestra un rendimiento excepcional en el procesamiento de código, incluso comparable a modelos de vanguardia como GPT-4o, Claude 3 Opus y Llama 3405B.

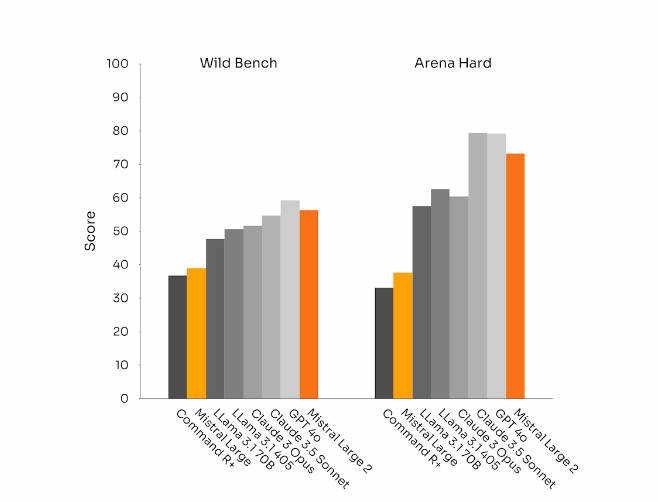

Seguimiento de instrucciones y alineación

Mistral Large 2 también ha logrado un progreso significativo en el seguimiento de instrucciones y la capacidad de conversación, siendo especialmente flexible en el manejo de conversaciones complejas y multiturnos. En algunas pruebas de referencia, la generación de respuestas más largas tiende a mejorar las puntuaciones. Sin embargo, en muchas aplicaciones comerciales, la concisión es crucial: las respuestas más cortas aceleran la interacción y la inferencia resulta más rentable.

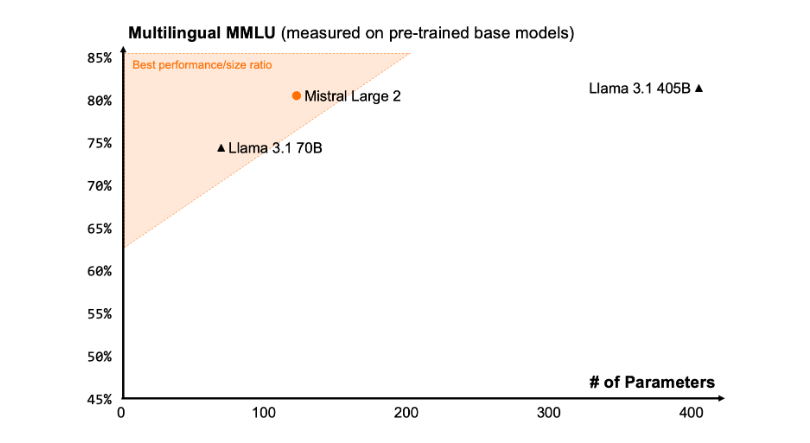

Diversidad lingüística

El nuevo Mistral Large 2 se entrenó con una gran cantidad de datos multilingües, mostrando un rendimiento excepcional en inglés, francés, alemán, español, italiano, portugués, holandés, ruso, chino, japonés, coreano, árabe e hindi. A continuación, se muestran los resultados del rendimiento de Mistral Large 2 en el benchmark MMLU multilingüe, en comparación con los modelos Mistral Large anteriores, Llama 3.1 y Command R+ de Cohere.

Uso de herramientas y llamadas a funciones

Mistral Large 2 está equipado con capacidades mejoradas de llamadas a funciones y recuperación, y se ha entrenado para realizar llamadas a funciones paralelas y secuenciales con destreza, lo que le permite funcionar como un motor para aplicaciones empresariales complejas.

Cómo utilizarlo:

Actualmente, los usuarios pueden utilizar Mistral Large 2 en la Plataforma (https://console.mistral.ai/), con el nombre mistral-large-2407, y probarlo en el Chat. Está disponible en la versión 24.07 (nuestro sistema de control de versiones YY.MM aplicado a todos los modelos) y con el nombre de API mistral-large-2407. Los pesos del modelo instruct están disponibles y también se alojan en HuggingFace (https://huggingface.co/mistralai/Mistral-Large-Instruct-2407).

La Plataforma ofrece los modelos generales Mistral Nemo y Mistral Large, y los modelos especializados Codestral y Embed. Mientras retiramos gradualmente los modelos antiguos de La Plataforma, todos los modelos Apache (Mistral 7B, Mixtral 8x7B y 8x22B, Codestral Mamba, Mathstral) siguen estando disponibles para implementación y ajuste fino mediante el SDK mistral-inference y mistral-finetune.

A partir de hoy, ampliamos las funciones de ajuste fino en La Plataforma: estas funciones ahora están disponibles para Mistral Large, Mistral Nemo y Codestral.

Mistral AI también colabora con varios proveedores líderes de servicios en la nube para que Mistral Large 2 esté disponible en todo el mundo, encontrándose especialmente en Vertex AI de Google Cloud Platform.

Puntos clave:

🌟 Mistral Large 2 cuenta con una ventana de contexto de 128k y admite hasta diez idiomas y más de 80 lenguajes de programación.

📈 Alcanza una precisión del 84.0% en el benchmark MMLU, mostrando un rendimiento y un costo excepcionales.

💻 Los usuarios pueden acceder al nuevo modelo a través de La Plataforma y utilizarlo ampliamente en plataformas de servicios en la nube.