Recientemente, Wenyi Yu y su equipo de la Universidad Nacional de Singapur presentaron una nueva tecnología llamada video-SALMONN, capaz de comprender no solo las secuencias de fotogramas visuales, eventos de audio y música de un video, sino también su contenido de voz. Este avance representa un paso significativo hacia la comprensión del contenido de video por parte de las máquinas.

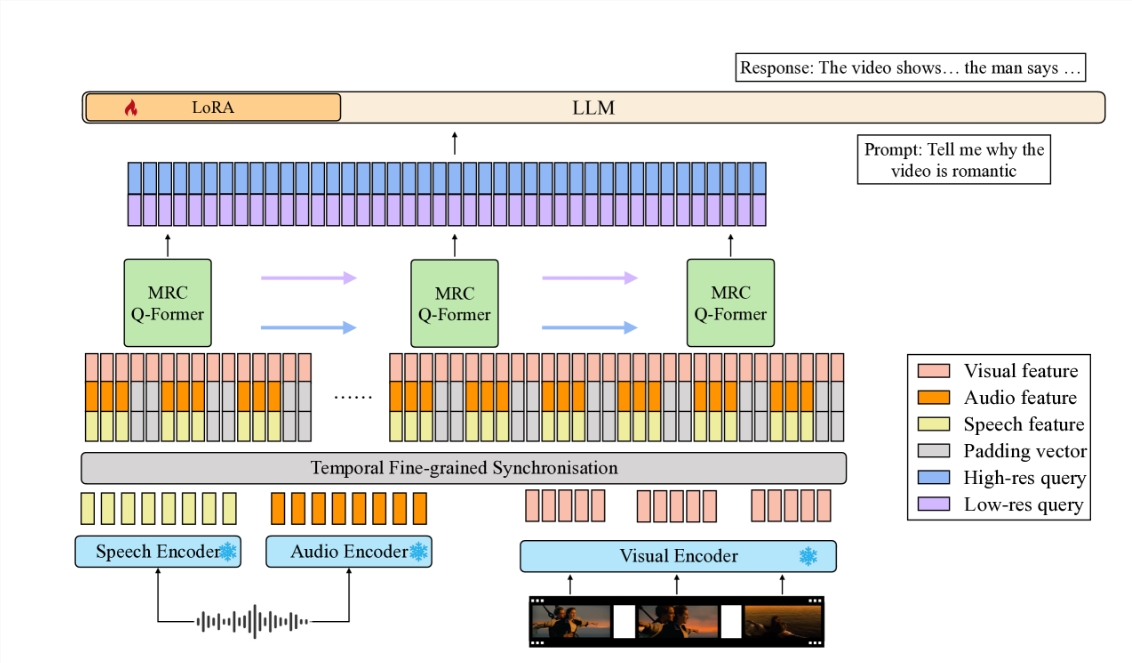

Video-SALMONN es un modelo de lenguaje grande de audio y video de extremo a extremo (av-LLM) que conecta codificadores de audio y video preentrenados con el cuerpo principal de un modelo de lenguaje grande a través de una novedosa arquitectura de Q-Former causal multirresolución (MRC Q-Former). Esta estructura permite capturar información temporal de grano fino necesaria para la comprensión del habla, al tiempo que garantiza un procesamiento eficiente de otros elementos del video.

Para mejorar el equilibrio en el procesamiento de los diferentes elementos del video, el equipo de investigación propuso métodos de entrenamiento específicos, incluyendo una pérdida de diversidad y una estrategia de entrenamiento mixto de audio y video no emparejados, para evitar el dominio de los fotogramas de video o de una modalidad específica.

En el nuevo punto de referencia de evaluación de voz-audio-video (SAVE), video-SALMONN logró una mejora de más del 25% en la precisión absoluta en tareas de preguntas y respuestas sobre video (video-QA), y más del 30% en tareas de preguntas y respuestas de audio y video que involucran voz humana. Además, video-SALMONN demostró una capacidad excepcional de comprensión e inferencia de video en tareas sin precedentes para otros av-LLM.

El núcleo de video-SALMONN es la arquitectura MRC Q-Former, que alinea las características de entrada de audio y video sincronizadas y el espacio de representación de texto en tres escalas de tiempo diferentes, satisfaciendo las necesidades de diferentes tareas con respecto a las dependencias de diferentes elementos del video. Además, para fortalecer la relación causal temporal entre fotogramas de video consecutivos, el MRC Q-Former incluye una estructura de autoatención causal con una máscara causal especial.

La presentación de video-SALMONN no solo proporciona una nueva herramienta de investigación para la comunidad académica, sino que también ofrece amplias posibilidades para aplicaciones prácticas. Facilita una interacción más natural e intuitiva entre la tecnología y los humanos, reduciendo la dificultad de aprendizaje para los usuarios, especialmente niños y adultos mayores. También tiene el potencial de mejorar la accesibilidad de la tecnología para personas con discapacidades motoras.

La presentación de video-SALMONN es un paso importante hacia la Inteligencia Artificial General (AGI). Al integrar la entrada de voz con las entradas de audio y video no verbales existentes, estos modelos obtendrán una comprensión completa de la interacción humana y el entorno, permitiendo su aplicación en un rango más amplio de campos.

El desarrollo de esta tecnología tendrá sin duda un impacto profundo en el análisis de contenido de video, las aplicaciones educativas y la mejora de la calidad de vida. Con el continuo progreso tecnológico, podemos confiar en que la IA del futuro será más inteligente y se adaptará mejor a las necesidades humanas.

Enlace del artículo: https://arxiv.org/html/2406.15704v1