En la era actual donde las empresas tecnológicas se apresuran a implementar la inteligencia artificial en dispositivos, están surgiendo cada vez más modelos de lenguaje pequeños (SLM) capaces de funcionar en dispositivos con recursos limitados. Recientemente, el equipo de investigación de Nvidia, utilizando técnicas de vanguardia de poda y destilación de modelos, presentó Llama-3.1-Minitron4B, una versión comprimida del modelo Llama3. Este nuevo modelo no solo iguala el rendimiento de modelos más grandes, sino que también compite con modelos pequeños de tamaño similar, al tiempo que ofrece una mayor eficiencia en el entrenamiento y la implementación.

La poda y la destilación son dos técnicas clave para crear modelos de lenguaje más pequeños y eficientes. La poda consiste en eliminar partes no importantes del modelo, incluyendo la "poda profunda"—eliminar capas enteras—y la "poda de ancho"—eliminar elementos específicos como neuronas y cabezales de atención. La destilación del modelo, por otro lado, transfiere el conocimiento y las capacidades de un modelo grande (el "modelo maestro") a un modelo "alumno" más pequeño y simple.

La destilación se realiza principalmente de dos maneras: la primera es mediante el "entrenamiento SGD", donde el modelo alumno aprende las entradas y respuestas del modelo maestro; la segunda es la "destilación de conocimiento clásica", donde el modelo alumno aprende las activaciones internas del modelo maestro además de los resultados.

En un estudio anterior, los investigadores de Nvidia lograron reducir con éxito el modelo Nemotron15B a un modelo de 800 millones de parámetros mediante poda y destilación, y luego lo simplificaron aún más a 400 millones de parámetros. Este proceso no solo mejoró el rendimiento en un 16% en la conocida prueba de referencia MMLU, sino que también requirió 40 veces menos datos de entrenamiento que el entrenamiento desde cero.

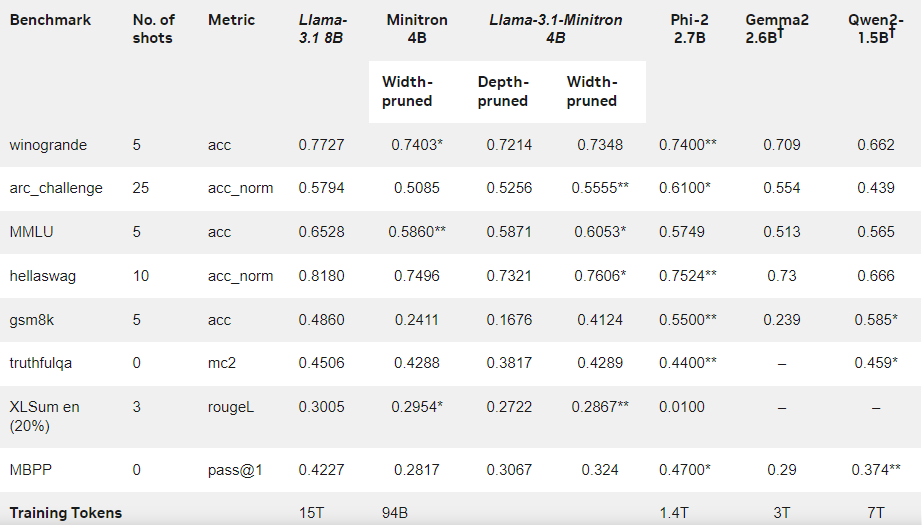

En esta ocasión, el equipo de Nvidia creó un modelo de 400 millones de parámetros basándose en el modelo Llama3.18B, utilizando el mismo método. Primero, ajustaron finamente un modelo de 8B sin podar en un conjunto de datos que contenía 94 mil millones de tokens para abordar las diferencias de distribución entre los datos de entrenamiento y los datos de destilación. Luego, utilizaron poda profunda y poda de ancho, obteniendo finalmente dos versiones diferentes de Llama-3.1-Minitron4B.

Los investigadores ajustaron finamente los modelos podados utilizando NeMo-Aligner y evaluaron sus capacidades en seguimiento de instrucciones, interpretación de roles, generación mejorada por recuperación (RAG) y llamadas a funciones.

Los resultados muestran que, a pesar de la menor cantidad de datos de entrenamiento, Llama-3.1-Minitron4B presenta un rendimiento cercano a otros modelos pequeños, mostrando un excelente desempeño. La versión de poda de ancho ya se ha publicado en Hugging Face, permitiendo su uso comercial y beneficiando a más usuarios y desarrolladores con su eficiencia y rendimiento excepcional.

Blog oficial: https://developer.nvidia.com/blog/how-to-prune-and-distill-llama-3-1-8b-to-an-nvidia-llama-3-1-minitron-4b-model/

Puntos clave:

🌟 Llama-3.1-Minitron4B es un modelo de lenguaje pequeño presentado por Nvidia basado en técnicas de poda y destilación, con una eficiente capacidad de entrenamiento e implementación.

📈 El modelo utilizó 40 veces menos tokens durante el entrenamiento que el entrenamiento desde cero, con una mejora significativa en el rendimiento.

🔓 La versión de poda de ancho ya está disponible en Hugging Face, facilitando su uso comercial y desarrollo.