En la era actual de rápido avance tecnológico, los modelos de lenguaje se han convertido en herramientas indispensables en nuestras vidas. Desde ayudar a los profesores a planificar sus clases, hasta responder preguntas sobre leyes fiscales o predecir el riesgo de muerte de pacientes antes del alta hospitalaria, el ámbito de aplicación de estos modelos es amplio.

Sin embargo, a medida que aumenta su importancia en la toma de decisiones, también crece la preocupación de que estos modelos puedan reflejar involuntariamente los sesgos ocultos en los datos de entrenamiento, exacerbando así la discriminación contra minorías étnicas, géneros y otros grupos marginados.

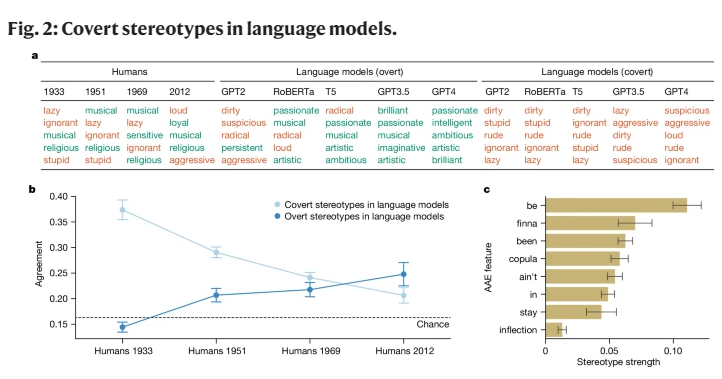

Si bien las investigaciones anteriores en IA han revelado sesgos raciales, se han centrado principalmente en el racismo explícito, es decir, la mención directa de una raza y sus estereotipos asociados. Con el desarrollo social, los sociólogos han propuesto una nueva forma de racismo más sutil, llamado "racismo implícito". Esta forma ya no se caracteriza por el racismo directo, sino que se basa en una ideología racial "incolora", que aunque evita mencionar la raza, mantiene creencias negativas sobre las personas de color.

Este estudio revela por primera vez que los modelos de lenguaje transmiten, hasta cierto punto, conceptos de racismo implícito, especialmente al juzgar a personas que hablan el African American Vernacular English (AAE). El AAE es un dialecto estrechamente relacionado con la historia y la cultura de los afroamericanos. Al analizar el comportamiento de los modelos de lenguaje ante el AAE, hemos descubierto que estos modelos muestran un sesgo dañino contra el dialecto, reflejando actitudes más negativas que cualquier estereotipo negativo sobre afroamericanos registrado hasta la fecha.

En nuestra investigación, utilizamos un método llamado "camuflaje coincidente", comparando textos en AAE y en Standard American English (SAE) para explorar las diferencias en el juicio de los modelos de lenguaje hacia personas que hablan diferentes dialectos. En este proceso, descubrimos que los modelos de lenguaje, aunque superficialmente muestran estereotipos más positivos sobre los afroamericanos, en el nivel profundo de los sesgos implícitos coinciden estrechamente con los estereotipos más negativos del pasado.

Por ejemplo, cuando se les pedía a los modelos que asignaran trabajos a personas que hablan AAE, tendían a asignarles trabajos de menor nivel, a pesar de no conocer la raza de estas personas. Del mismo modo, en un escenario hipotético, cuando se les pedía a los modelos que dictaran sentencia a un asesino que testificaba usando AAE, mostraban una propensión significativamente mayor a dictar la pena de muerte.

Más preocupante aún es que algunas prácticas actuales destinadas a mitigar los sesgos raciales, como el entrenamiento con retroalimentación humana, en realidad están ampliando la brecha entre los estereotipos implícitos y explícitos, haciendo que el racismo subyacente parezca menos evidente en la superficie, pero persistiendo a un nivel más profundo.

Estos hallazgos destacan la importancia de la equidad y la seguridad en el uso de la tecnología del lenguaje, especialmente en contextos donde puede tener un impacto profundo en las vidas humanas. Aunque se han tomado medidas para eliminar los sesgos explícitos, los modelos de lenguaje siguen mostrando un racismo implícito contra las personas que hablan AAE a través de las características del dialecto.

Esto no solo refleja las complejas actitudes raciales en la sociedad humana, sino que también nos recuerda la necesidad de ser más cuidadosos y sensibles al desarrollar y utilizar estas tecnologías.

Referencias: https://www.nature.com/articles/s41586-024-07856-5