En el campo del procesamiento del lenguaje natural, los grandes modelos de lenguaje (LLM) se están desarrollando rápidamente y han logrado avances significativos en múltiples áreas. Sin embargo, a medida que aumenta la complejidad de los modelos, se vuelve crucial evaluar con precisión sus resultados. Tradicionalmente, hemos dependido de la evaluación humana, pero este método es lento y difícil de escalar, incapaz de seguir el ritmo del rápido desarrollo de los modelos.

Para cambiar esta situación, el equipo de investigación de Salesforce AI ha presentado SFR-Judge, una familia de evaluación compuesta por tres grandes modelos de lenguaje. Estos modelos tienen 8 mil millones, 12 mil millones y 700 mil millones de parámetros, respectivamente, y se basan en Meta Llama3 y Mistral NeMO. SFR-Judge puede realizar múltiples tareas de evaluación, incluyendo comparaciones por pares, puntuaciones individuales y evaluación de clasificación binaria, con el objetivo de ayudar a los equipos de investigación a evaluar de forma rápida y eficiente el rendimiento de los nuevos modelos.

Los modelos de evaluación de LLM tradicionales a menudo presentan algunos problemas de sesgo, como el sesgo de posición y el sesgo de longitud, que pueden afectar sus juicios. Para superar estos problemas, SFR-Judge utiliza un método de entrenamiento de optimización de preferencias directas (DPO), que permite al modelo aprender de ejemplos positivos y negativos, mejorando así su capacidad de comprensión de las tareas de evaluación, reduciendo el sesgo y asegurando la coherencia de los juicios.

En las pruebas, SFR-Judge obtuvo excelentes resultados en 13 pruebas de referencia, superando a muchos modelos de evaluación existentes, incluidos algunos modelos privados. En particular, en la clasificación RewardBench, SFR-Judge alcanzó una precisión del 92,7%, siendo la primera y segunda vez que un modelo de evaluación generativa supera el umbral del 90%, lo que demuestra su excelente rendimiento en la evaluación de modelos.

El método de entrenamiento de SFR-Judge abarca tres formatos de datos diferentes. El primero es la "crítica de cadena de pensamiento", que ayuda al modelo a generar un análisis estructurado de las respuestas de evaluación. El segundo es la "evaluación estándar", que simplifica el proceso de evaluación, proporcionando directamente información sobre si la respuesta cumple con los estándares. Finalmente, la "inferencia de respuesta" ayuda al modelo a comprender las características de las respuestas de alta calidad, reforzando su capacidad de juicio. La combinación de estos tres formatos de datos ha mejorado enormemente la capacidad de evaluación de SFR-Judge.

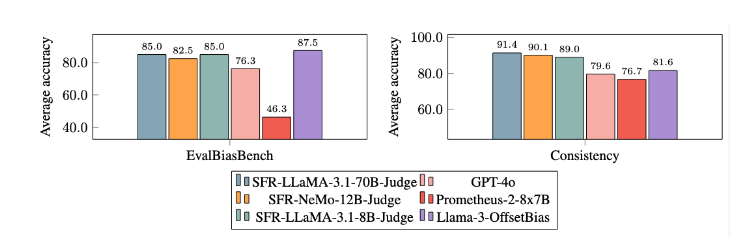

Tras numerosos experimentos, los modelos SFR-Judge han demostrado ser significativamente superiores a otros modelos en la reducción de sesgos. En la prueba de referencia EvalBiasBench, mostraron una alta consistencia en el orden de pares, lo que indica que el juicio del modelo permanece estable incluso si cambia el orden de las respuestas. Esto convierte a SFR-Judge en una solución de evaluación automatizada fiable, que reduce la dependencia de las anotaciones manuales y ofrece una opción más escalable para la evaluación de modelos.

Enlace al artículo: https://arxiv.org/abs/2409.14664

Puntos clave:

📊 Alta precisión: SFR-Judge obtuvo los mejores resultados en 10 de las 13 pruebas de referencia, alcanzando una precisión del 92,7% en RewardBench.

🛡️ Mitigación de sesgos: El modelo muestra un sesgo menor que otros modelos de evaluación, especialmente en términos de longitud y posición.

🔧 Aplicación multifuncional: SFR-Judge admite comparaciones por pares, puntuaciones individuales y evaluación de clasificación binaria, adaptándose a diversas situaciones de evaluación.