Los grandes modelos de lenguaje (LLM), como la serie GPT, con sus enormes conjuntos de datos, muestran una capacidad asombrosa en la comprensión del lenguaje, el razonamiento y la planificación, alcanzando niveles comparables a los humanos en diversas tareas desafiantes. La mayoría de las investigaciones se centran en mejorar aún más estos modelos entrenándolos con conjuntos de datos más grandes, con el objetivo de desarrollar modelos base más potentes.

Sin embargo, aunque entrenar modelos base más potentes es crucial, los investigadores consideran que dotar a los modelos de la capacidad de evolucionar continuamente también durante la fase de razonamiento, es decir, la autoevolución de la IA, es igualmente importante para el desarrollo de la IA. En comparación con el entrenamiento de modelos con datos a gran escala, la autoevolución podría requerir solo datos o interacciones limitadas.

Inspirados en la estructura columnar de la corteza cerebral humana, los investigadores plantean la hipótesis de que los modelos de IA pueden desarrollar capacidades cognitivas emergentes y construir modelos de representación interna a través de la interacción iterativa con su entorno.

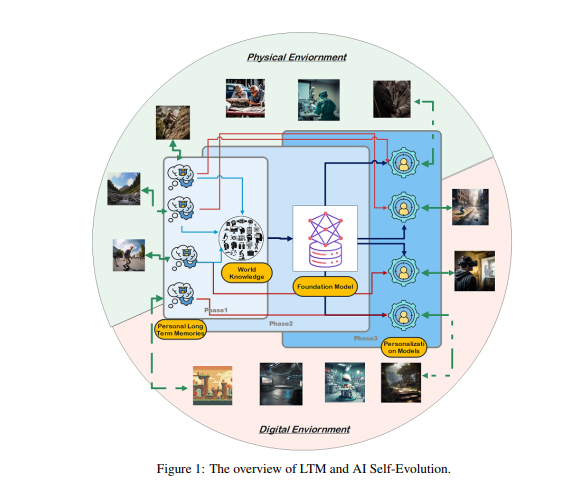

Para lograr este objetivo, los investigadores proponen que los modelos deben poseer una memoria a largo plazo (LTM, por sus siglas en inglés), utilizada para almacenar y gestionar los datos de interacción con el mundo real procesados. La LTM no solo puede representar datos individuales de cola larga en modelos estadísticos, sino que también puede promover la autoevolución al admitir experiencias diversas a través de diferentes entornos y agentes.

La LTM es clave para la autoevolución de la IA. Similar a cómo los humanos aprenden y mejoran continuamente a través de experiencias personales e interacciones con el entorno, la autoevolución de los modelos de IA también depende de los datos de LTM acumulados durante las interacciones. A diferencia de la evolución humana, la evolución de los modelos impulsada por la LTM no se limita a las interacciones del mundo real. Los modelos pueden interactuar con el entorno físico y recibir retroalimentación directa, al igual que los humanos; esta retroalimentación, una vez procesada, mejorará sus capacidades, un área clave de investigación en la IA encarnada.

Por otro lado, los modelos también pueden interactuar en entornos virtuales y acumular datos de LTM; esto, en comparación con la interacción con el mundo real, tiene un costo menor y una mayor eficiencia, lo que permite mejorar las capacidades de manera más efectiva.

La construcción de la LTM requiere refinar y estructurar los datos brutos. Los datos brutos se refieren al conjunto de todos los datos sin procesar que el modelo recibe a través de la interacción con el entorno externo o durante el entrenamiento. Estos datos contienen diversas observaciones y registros, que pueden incluir patrones valiosos y una gran cantidad de información redundante o irrelevante.

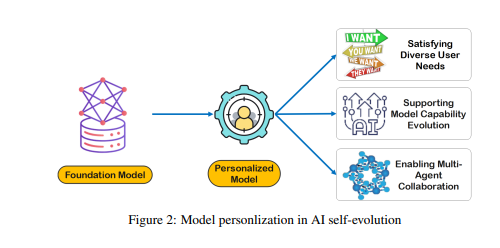

Aunque los datos brutos constituyen la base de la memoria y la cognición del modelo, es necesario procesarlos aún más para utilizarlos eficazmente para la personalización o la ejecución eficiente de tareas. La LTM refina y estructura estos datos brutos para que el modelo pueda utilizarlos. Este proceso mejora la capacidad del modelo para proporcionar respuestas y sugerencias personalizadas.

La construcción de la LTM se enfrenta a desafíos como la escasez de datos y la diversidad de usuarios. En los sistemas LTM de actualización continua, la escasez de datos es un problema común, especialmente para usuarios con un historial de interacción limitado o actividades dispersas, lo que dificulta el entrenamiento del modelo. Además, la diversidad de usuarios aumenta la complejidad, requiriendo que el modelo se adapte a los patrones individuales y, al mismo tiempo, generalice eficazmente entre diferentes grupos de usuarios.

Los investigadores han desarrollado un marco de colaboración multiagente llamado Omne, que implementa la autoevolución de la IA basada en LTM. En este marco, cada agente tiene una estructura de sistema independiente, capaz de aprender y almacenar de forma autónoma un modelo ambiental completo, construyendo así una comprensión independiente del entorno. A través de este desarrollo colaborativo basado en LTM, el sistema de IA puede adaptarse en tiempo real a los cambios en el comportamiento individual, optimizar la planificación y ejecución de tareas, y promover aún más la autoevolución de la IA personalizada y eficiente.

El marco Omne obtuvo el primer lugar en el benchmark GAIA, demostrando el enorme potencial de la autoevolución de la IA utilizando LTM para resolver problemas del mundo real. Los investigadores creen que el avance de la investigación en LTM es crucial para el desarrollo continuo y las aplicaciones prácticas de la tecnología de IA, especialmente en el ámbito de la autoevolución.

En resumen, la memoria a largo plazo es clave para la autoevolución de la IA, permitiendo que los modelos de IA aprendan y mejoren a partir de la experiencia, al igual que los humanos. La construcción y utilización de la LTM requiere superar desafíos como la escasez de datos y la diversidad de usuarios. El marco Omne ofrece una solución viable para la autoevolución de la IA basada en LTM, y su éxito en el benchmark GAIA demuestra el enorme potencial de este campo.

Artículo: https://arxiv.org/pdf/2410.15665