Recientemente, OpenAI lanzó un nuevo benchmark llamado SimpleQA, diseñado para evaluar la precisión fáctica de las respuestas generadas por los modelos de lenguaje.

Con el rápido desarrollo de los grandes modelos de lenguaje, asegurar la precisión del contenido generado presenta numerosos desafíos, especialmente las llamadas "alucinaciones", donde el modelo genera información que suena convincente pero que es incorrecta o inverificable. Esto es particularmente importante en un contexto donde cada vez más personas dependen de la IA para obtener información.

SimpleQA se caracteriza por su enfoque en preguntas cortas y precisas, que suelen tener una respuesta inequívoca, facilitando así la evaluación de la corrección de la respuesta del modelo. A diferencia de otros benchmarks, las preguntas de SimpleQA están cuidadosamente diseñadas para desafiar incluso a los modelos más avanzados como GPT-4. Este benchmark incluye 4326 preguntas que abarcan diversos campos como historia, ciencia, tecnología, arte y entretenimiento, prestando especial atención a la evaluación de la precisión y la calibración del modelo.

El diseño de SimpleQA sigue algunos principios clave. En primer lugar, cada pregunta tiene una respuesta de referencia determinada por dos entrenadores de IA independientes, garantizando la exactitud de la respuesta.

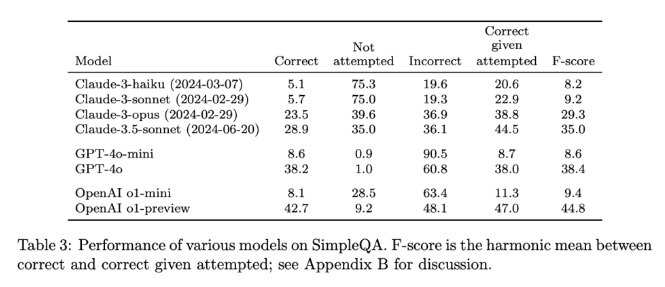

En segundo lugar, el planteamiento de las preguntas evita la ambigüedad; cada pregunta puede responderse con una respuesta simple y clara, lo que facilita la puntuación. Además, SimpleQA utiliza un clasificador ChatGPT para la puntuación, etiquetando claramente las respuestas como "correctas", "incorrectas" o "no intentadas".

Otra ventaja de SimpleQA es su cobertura de preguntas diversas, evitando la sobreespecialización del modelo y asegurando una evaluación completa. Este conjunto de datos es fácil de usar, ya que las preguntas y respuestas son breves, lo que permite que las pruebas se ejecuten rápidamente y con poca variación en los resultados. Además, SimpleQA considera la relevancia a largo plazo de la información, evitando así los efectos de los cambios en la información, convirtiéndolo en un benchmark "perenne".

El lanzamiento de SimpleQA es un paso importante para impulsar la fiabilidad de la información generada por la IA. No solo proporciona un benchmark fácil de usar, sino que también establece un alto estándar para investigadores y desarrolladores, animándoles a crear modelos que no solo generen lenguaje, sino que también sean precisos y veraces. Al ser de código abierto, SimpleQA proporciona a la comunidad de IA una herramienta valiosa para mejorar la precisión fáctica de los modelos de lenguaje, asegurando que los sistemas de IA del futuro proporcionen información fiable y digna de confianza.

Acceso al proyecto: https://github.com/openai/simple-evals

Página de detalles: https://openai.com/index/introducing-simpleqa/

Puntos clave:

📊 SimpleQA es un nuevo benchmark de OpenAI que se centra en evaluar la precisión fáctica de los modelos de lenguaje.

🧠 Este benchmark consta de 4326 preguntas cortas y precisas que abarcan múltiples campos, asegurando una evaluación completa.

🔍 SimpleQA ayuda a los investigadores a identificar y mejorar la capacidad de los modelos de lenguaje para generar contenido preciso.