Recientemente, los grandes modelos de lenguaje (LLM) de IA han demostrado un rendimiento excepcional en diversas tareas, como escribir poemas, código y mantener conversaciones; ¡parecen ser capaces de todo! Sin embargo, ¿puede creerlo? ¡Estas IA "geniales" resultan ser "patatas" en matemáticas! A menudo cometen errores al resolver problemas aritméticos simples, lo que resulta sorprendente.

Un estudio reciente ha desvelado el "extraño" secreto detrás de la capacidad de razonamiento aritmético de los LLM: ¡no dependen de algoritmos potentes ni únicamente de la memoria, sino que emplean una estrategia denominada "mezcolanza heurística"! Es como un estudiante que, en lugar de estudiar a fondo las fórmulas y teoremas matemáticos, se basa en "astucias" y "reglas empíricas" para adivinar las respuestas.

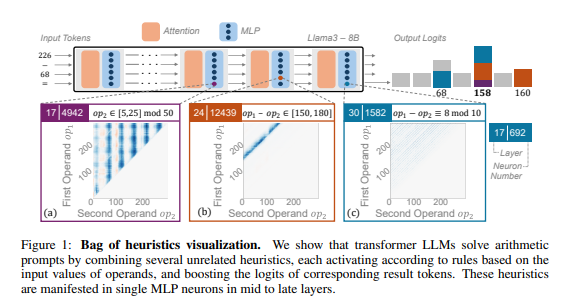

Los investigadores analizaron en profundidad varios LLM, como Llama3, Pythia y GPT-J, utilizando el razonamiento aritmético como tarea representativa. Descubrieron que la parte de los modelos LLM responsable del cálculo aritmético (denominada "circuito") está compuesta por muchas neuronas individuales, cada una de las cuales actúa como una "mini calculadora", encargada de identificar patrones numéricos específicos y generar la respuesta correspondiente. Por ejemplo, una neurona podría estar especializada en identificar "números cuya cifra de las unidades es 8", mientras que otra se encargaría de identificar "operaciones de resta cuyo resultado se encuentra entre 150 y 180".

Estas "mini calculadoras" son como un conjunto de herramientas desordenadas. Los LLM no las utilizan siguiendo un algoritmo específico, sino que combinan estas "herramientas" aleatoriamente según el patrón numérico de entrada para calcular la respuesta. Es como un chef que, sin una receta fija, combina ingredientes al azar para crear un plato "experimental".

Más sorprendente aún es que esta estrategia de "mezcolanza heurística" aparece en las primeras etapas del entrenamiento de los LLM y se refina a medida que avanza el entrenamiento. Esto significa que los LLM dependen desde el principio de este método de razonamiento "ensamblado", y no lo desarrollan posteriormente.

Entonces, ¿qué problemas causa este método de razonamiento aritmético "extraño"? Los investigadores descubrieron que la estrategia de "mezcolanza heurística" tiene una capacidad de generalización limitada y es propensa a errores. Esto se debe a que la cantidad de "astucias" que dominan los LLM es limitada, y estas "astucias" pueden tener defectos, lo que impide que proporcionen respuestas correctas cuando se enfrentan a nuevos patrones numéricos. Es como un chef que solo sabe hacer "tortilla francesa" y de repente tiene que preparar un "paella", seguramente se sentirá perdido y desorientado.

Esta investigación revela las limitaciones de la capacidad de razonamiento aritmético de los LLM y señala el camino para mejorar sus habilidades matemáticas en el futuro. Los investigadores consideran que los métodos y arquitecturas de modelos actuales podrían ser insuficientes para mejorar la capacidad de razonamiento aritmético de los LLM, y que es necesario explorar nuevos métodos para ayudar a los LLM a aprender algoritmos más potentes y generalizables, para que se conviertan realmente en "expertos en matemáticas".

Dirección del artículo: https://arxiv.org/pdf/2410.21272