Un hito importante en el campo de la inteligencia artificial, ARC-AGI, o "Corpus de Razonamiento y Abstracción de Inteligencia Artificial General", está a punto de lograr un avance significativo. Sin embargo, el creador de la prueba, François Chollet, advierte que, a pesar de las mejoras en los resultados, esto no significa que estemos cerca de lograr la Inteligencia Artificial General (AGI). Señala que la prueba en sí tiene defectos de diseño y que no revela verdaderos avances en la investigación.

Desde que Chollet lanzó ARC-AGI en 2019, los sistemas de IA han tenido un rendimiento deficiente en la prueba. Hasta la fecha, el sistema con mejor rendimiento solo ha podido resolver menos de un tercio de las tareas. Chollet afirma que esto se debe principalmente a la dependencia excesiva de la investigación actual de IA en los grandes modelos lingüísticos (LLM). Señala que, aunque los LLM pueden realizar el reconocimiento de patrones al procesar datos a gran escala, dependen de la memoria en lugar del razonamiento, por lo que tienen dificultades para manejar situaciones nuevas o realizar un verdadero "razonamiento".

"Los modelos LLM dependen de la extracción de patrones de los datos de entrenamiento, en lugar de realizar un razonamiento independiente. Simplemente 'memorizan' los patrones en lugar de generar nuevos razonamientos", explicó Chollet en una serie de publicaciones en la plataforma X.

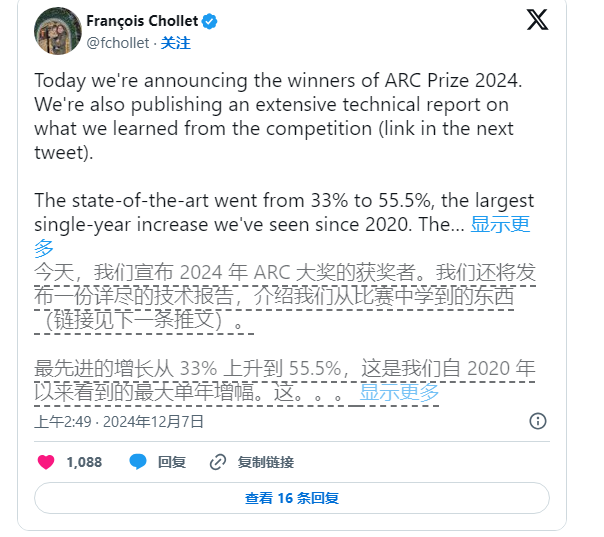

A pesar de ello, Chollet no ha dejado de impulsar la investigación en IA. Junto con Mike Knoop, fundador de Zapier, lanzaron en junio de este año un concurso de 1 millón de dólares para alentar a la IA de código abierto a desafiar el estándar ARC-AGI. Aunque el mejor sistema de IA entre las 17.789 participaciones solo obtuvo una puntuación del 55,5%, inferior al 85% necesario para alcanzar el "nivel humano", Chollet y Knoop consideran que es un paso importante.

Knoop señala en una entrada de blog que este resultado no significa que estemos más cerca de lograr la AGI, sino que pone de manifiesto que algunas tareas de ARC-AGI dependen demasiado de soluciones de "fuerza bruta", que no necesariamente proporcionan una señal válida para la verdadera inteligencia general. ARC-AGI está diseñado para probar la capacidad de generalización de la IA proporcionando tareas complejas e inéditas; sin embargo, sigue existiendo la duda de si estas tareas pueden evaluar eficazmente la AGI.

Nota de la fuente: La imagen fue generada por IA, con licencia de Midjourney.

Las tareas del estándar ARC-AGI incluyen problemas como rompecabezas, que requieren que la IA deduzca respuestas desconocidas a partir de información conocida. Aunque estas tareas parecen impulsar la adaptación de la IA a nuevas situaciones, los resultados muestran que los modelos actuales parecen encontrar soluciones mediante un gran volumen de cálculos, y no necesariamente demuestran una verdadera capacidad de adaptación inteligente.

Además, los creadores de ARC-AGI también se enfrentan a críticas de sus colegas, especialmente en cuanto a la ambigüedad de la definición de AGI. Un empleado de OpenAI afirmó recientemente que, si se define la AGI como una inteligencia artificial que "supera en rendimiento a la mayoría de los humanos en la mayoría de las tareas", entonces la AGI ya se ha logrado. Sin embargo, Chollet y Knoop opinan que el diseño actual del estándar ARC-AGI aún no ha alcanzado este objetivo.

De cara al futuro, Chollet y Knoop planean lanzar una segunda generación del estándar ARC-AGI y celebrarán un nuevo concurso en 2025 para abordar las deficiencias de la prueba actual. Afirman que el nuevo estándar se centrará más en impulsar la investigación de IA en direcciones más importantes para acelerar el proceso de logro de la AGI.

Sin embargo, corregir el estándar existente no es tarea fácil. Los esfuerzos de Chollet y Knoop demuestran que definir la inteligencia artificial, especialmente en el ámbito de la inteligencia general, sigue siendo una tarea ardua y compleja.