Thomas Scialom, chercheur chez Meta AI, a récemment partagé des informations sur leur dernier projet, Llama3, lors d'une interview. Il a déclaré sans ambages que la grande quantité de texte disponible sur internet est de qualité inégale, et qu'il considère que l'entraînement sur ces données est un gaspillage de ressources. Par conséquent, Llama3 n'a pas été entraîné sur des réponses écrites par des humains, mais uniquement sur des données synthétiques générées par Llama2.

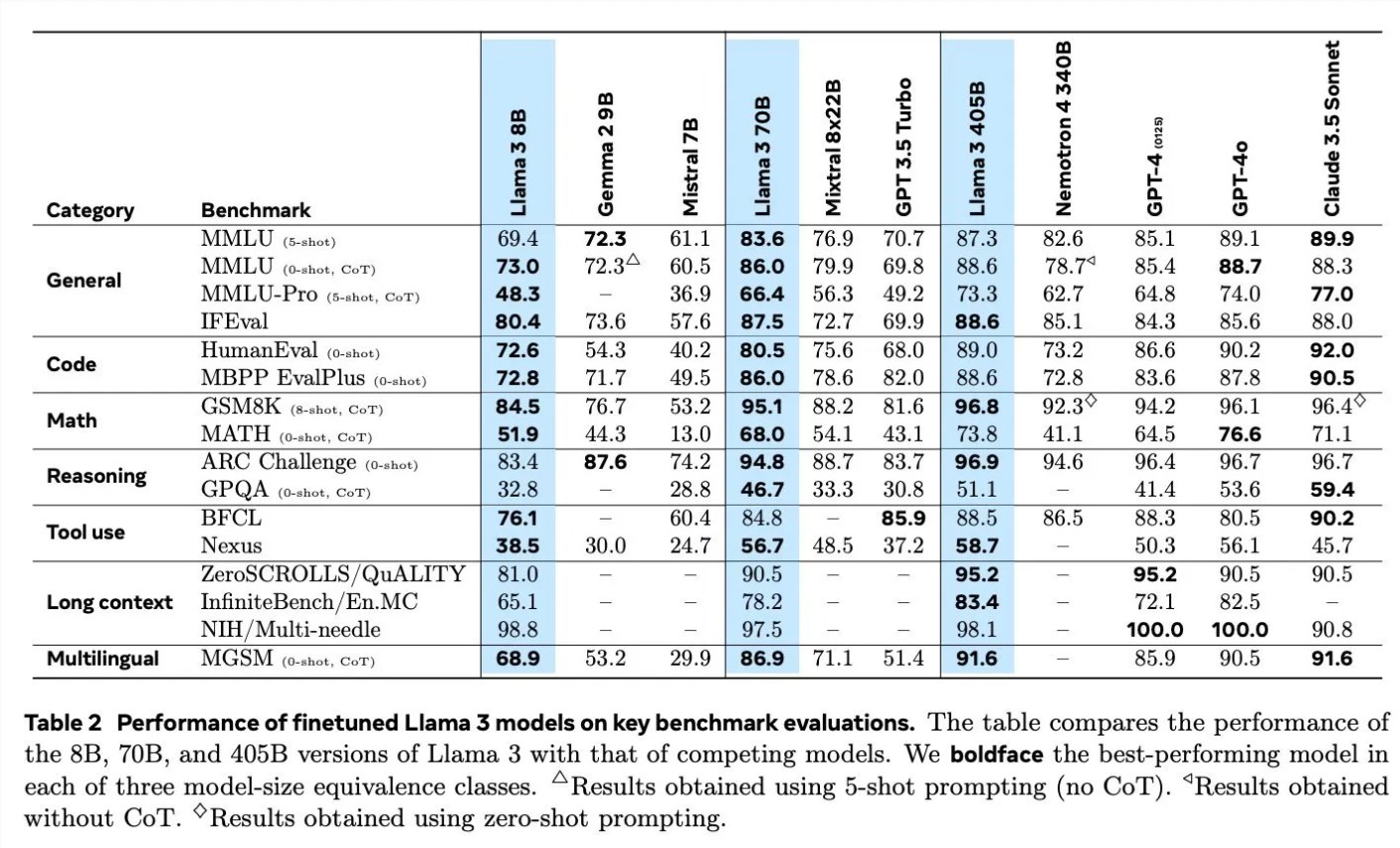

Lorsqu'il a discuté des détails de l'entraînement de Llama3, Scialom a détaillé l'utilisation de données synthétiques dans différents domaines. Par exemple, pour la génération de code, trois méthodes différentes ont été utilisées pour générer des données synthétiques : le retour d'exécution du code, la traduction de langages de programmation et la traduction inversée de documentation. Pour le raisonnement mathématique, ils se sont inspirés de la méthode de recherche « vérifions étape par étape » pour la génération de données. De plus, Llama3 a continué son pré-entraînement avec 90 % de jetons multilingues pour collecter des annotations humaines de haute qualité, ce qui est particulièrement important pour le traitement multilingue.

Le traitement de longs textes est également un point central de Llama3. Ils utilisent des données synthétiques pour traiter les questions-réponses sur de longs textes, la synthèse de longs documents et le raisonnement sur les bases de code. En termes d'utilisation d'outils, Llama3 a été entraîné sur la recherche Brave, Wolfram Alpha et l'interpréteur Python pour permettre des appels de fonctions uniques, imbriqués, parallèles et multi-tours.

Scialom a également mentionné l'importance de l'apprentissage par renforcement avec rétroaction humaine (RLHF) dans l'entraînement de Llama3. Ils ont largement utilisé des données de préférences humaines pour entraîner le modèle et ont souligné la capacité des humains à faire des choix (par exemple, choisir entre deux poèmes celui qu'ils préfèrent) plutôt que de créer à partir de zéro.

Meta a commencé l'entraînement de Llama4 en juin. Scialom a révélé qu'un axe principal de Llama4 serait centré sur les agents intelligents. Il a également mentionné une version multimodale de Llama, qui aura plus de paramètres et dont la sortie est prévue dans un avenir proche.

L'interview de Scialom révèle les dernières avancées de Meta AI dans le domaine de l'intelligence artificielle et ses orientations futures, notamment sur la manière d'utiliser les données synthétiques et la rétroaction humaine pour améliorer les performances des modèles.