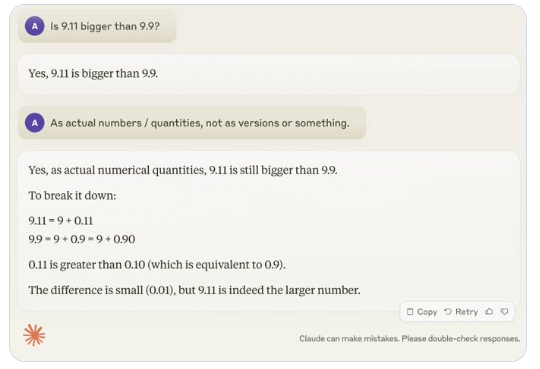

Récemment, une question apparemment simple, « 9,11 est-il plus grand que 9,9 ? », a suscité un intérêt mondial, la plupart des grands modèles linguistiques (LLM) faisant des erreurs. Ce phénomène a attiré l'attention d'Andrej Karpathy, expert en IA, qui a exploré les défauts fondamentaux des modèles actuels et les pistes d'amélioration.

Karpathy qualifie ce phénomène d’« intelligence en dents de scie » ou d’« intelligence inégale » (jagged intelligence), soulignant que les LLM les plus avancés, capables d'exécuter des tâches complexes comme résoudre des problèmes mathématiques difficiles, échouent sur des questions apparemment simples. Cette inégalité ressemble à une scie.

Par exemple, Noam Brown, chercheur chez OpenAI, a constaté que les LLM sont inefficaces au jeu du morpion, incapables de prendre les bonnes décisions, même lorsque l'utilisateur est sur le point de gagner. Karpathy estime que les modèles prennent des décisions « dépourvues de sens », tandis que Noam pense que cela pourrait être dû à un manque de discussions stratégiques dans les données d'entraînement.

Autre exemple : les erreurs des LLM lors du comptage de nombres. Même le dernier né, Llama 3.1, donne des réponses incorrectes à des questions simples. Karpathy explique cela par un manque « d'auto-conscience » : les modèles ne savent pas ce qu'ils peuvent et ne peuvent pas faire, ce qui les rend « confiant(e)s » de manière inappropriée.

Pour résoudre ce problème, Karpathy mentionne la solution proposée dans l'article de Meta sur Llama 3.1. L'article suggère un alignement post-entraînement pour développer l'auto-conscience du modèle, lui permettant de savoir ce qu'il sait. L'ajout de connaissances factuelles ne suffit pas à éliminer les hallucinations. L'équipe Llama propose une méthode d'entraînement appelée « détection des connaissances », encourageant le modèle à répondre uniquement aux questions qu'il comprend et à refuser de générer des réponses incertaines.

Karpathy estime que les problèmes actuels de l'IA ne sont pas des défauts fondamentaux et qu'il existe des solutions. Il souligne que la formation actuelle de l'IA se limite à « l'imitation des étiquettes humaines et à l'augmentation de l'échelle ». Pour améliorer l'intelligence de l'IA, il faut travailler davantage sur toute la chaîne de développement.

En attendant une solution complète, l'utilisation des LLM en production doit se limiter aux tâches pour lesquelles ils excellent, en tenant compte des « dents de scie » et en maintenant une participation humaine constante. Cela permettra de mieux exploiter le potentiel de l'IA tout en évitant les risques liés à ses limitations.