De nos jours, le domaine du traitement automatique du langage naturel (TALN) connaît un développement rapide. Les grands modèles de langage (LLM) sont capables d'exécuter des tâches linguistiques complexes avec une grande précision, ouvrant de nouvelles perspectives pour l'interaction homme-machine. Cependant, le TALN présente un problème majeur : l'évaluation des modèles repose fortement sur les annotations humaines.

Les données générées par l'homme sont essentielles à l'entraînement et à la validation des modèles, mais leur collecte est coûteuse et prend du temps. De plus, à mesure que les modèles s'améliorent, les annotations collectées précédemment peuvent nécessiter une mise à jour, leur utilité diminuant lors de l'évaluation de nouveaux modèles. Ceci entraîne un besoin constant de nouvelles données, ce qui pose des défis à la mise à l'échelle et à la durabilité d'une évaluation efficace des modèles.

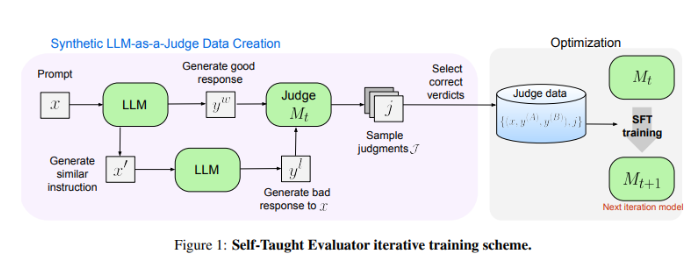

Les chercheurs de Meta FAIR proposent une solution novatrice : le « Self-Taught Evaluator » (évaluateur autodidacte). Cette méthode ne nécessite pas d'annotations humaines, mais utilise des données synthétiques générées pour l'entraînement. Elle commence par générer des paires de préférences synthétiques contrastées à l'aide d'un modèle initial. Le modèle évalue ensuite ces paires et s'améliore itérativement, utilisant son propre jugement pour améliorer ses performances lors des itérations suivantes, réduisant ainsi considérablement la dépendance aux annotations humaines.

Les chercheurs ont testé les performances du « Self-Taught Evaluator » à l'aide du modèle Llama-3-70B-Instruct. Cette méthode a permis d'améliorer la précision du modèle sur le benchmark RewardBench de 75,4 % à 88,7 %, atteignant voire surpassant les performances des modèles entraînés avec des annotations humaines. Après plusieurs itérations, le modèle final a atteint une précision de 88,3 % en inférence unique et de 88,7 % en vote majoritaire, démontrant ainsi sa robustesse et sa fiabilité.

Le « Self-Taught Evaluator » offre une solution évolutive et efficace pour l'évaluation des modèles TALN. En utilisant des données synthétiques et une amélioration itérative par auto-apprentissage, il répond aux défis liés à la dépendance aux annotations humaines et contribue au développement des modèles linguistiques.

Adresse de l'article : https://arxiv.org/abs/2408.02666

Points clés :

- 😃L'évaluation des modèles TALN dépend des annotations humaines, ce qui pose des problèmes de coût élevé, de temps de collecte important et de diminution de l'utilité des données.

- 🤖Meta FAIR lance le « Self-Taught Evaluator », qui utilise des données synthétiques pour l'entraînement et réduit ainsi la dépendance aux annotations humaines.

- 💪Le « Self-Taught Evaluator » offre des performances exceptionnelles, améliorant considérablement la précision des modèles lors des tests, avec une stabilité et une fiabilité remarquables.