Récemment, Andrej Karpathy, chercheur de renom dans le domaine de l'IA, a émis un point de vue assez controversé : il estime que l'apprentissage par renforcement basé sur les retours humains (RLHF), actuellement très populaire, n'est peut-être pas la voie royale vers de véritables capacités de résolution de problèmes au niveau humain. Cette déclaration a sans aucun doute fait l'effet d'une bombe dans le domaine de la recherche sur l'IA.

Le RLHF était considéré comme un facteur clé du succès de ChatGPT et d'autres grands modèles linguistiques (LLM), une « arme secrète » qui confère à l'IA compréhension, obéissance et capacité d'interaction naturelle. Dans le processus d'entraînement traditionnel de l'IA, le RLHF est généralement la dernière étape après la pré-formation et l'ajustement fin supervisé (SFT). Cependant, Karpathy compare le RLHF à un « goulot d'étranglement » et à un « expédient », estimant qu'il est loin d'être la solution ultime à l'évolution de l'IA.

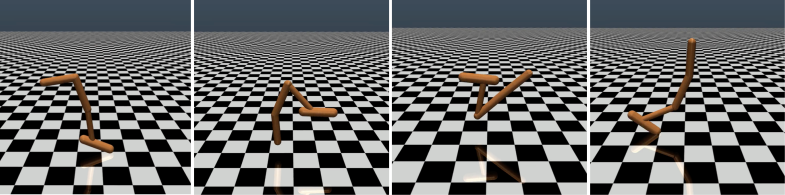

Karpathy a habilement comparé le RLHF à AlphaGo de DeepMind. AlphaGo utilise ce qu'il appelle le « vrai RL » (apprentissage par renforcement), en jouant constamment contre lui-même et en maximisant ses chances de gagner, surpassant ainsi les meilleurs joueurs humains sans intervention humaine. Cette méthode, qui optimise le réseau neuronal en apprenant directement des résultats du jeu, a permis d'atteindre un niveau de performance supérieur à celui des humains.

En revanche, Karpathy estime que le RLHF ressemble davantage à une imitation des préférences humaines qu'à une véritable résolution de problèmes. Il imagine que si AlphaGo utilisait la méthode RLHF, les évaluateurs humains devraient comparer un grand nombre d'états de jeu et choisir leurs préférences, un processus qui pourrait nécessiter jusqu'à 100 000 comparaisons pour entraîner un « modèle de récompense » imitant le « contrôle de l'ambiance » humain. Cependant, ce jugement basé sur « l'ambiance » peut donner des résultats trompeurs dans un jeu aussi rigoureux que le go.

De même, le modèle de récompense des LLM actuels fonctionne de manière similaire : il a tendance à classer plus haut les réponses qui semblent statistiquement préférées par les évaluateurs humains. Cela ressemble davantage à une adaptation aux préférences superficielles des humains qu'à une véritable capacité de résolution de problèmes. Plus inquiétant encore, le modèle pourrait rapidement apprendre à exploiter cette fonction de récompense au lieu d'améliorer ses propres capacités.

Karpathy souligne que si l'apprentissage par renforcement excelle dans des environnements fermés comme le jeu de go, le véritable apprentissage par renforcement reste difficile à mettre en œuvre pour les tâches linguistiques ouvertes. Cela est principalement dû à la difficulté de définir des objectifs et des mécanismes de récompense clairs dans les tâches ouvertes. « Comment attribuer une récompense objective à des tâches telles que la rédaction d'un résumé d'article, la réponse à des questions floues sur l'installation de pip, la narration d'une blague ou la réécriture de code Java en Python ? » demande Karpathy avec perspicacité. « Progresser dans cette direction n'est pas impossible en principe, mais ce n'est certainement pas une mince affaire, cela nécessite une réflexion créative. »

Néanmoins, Karpathy estime que si ce problème pouvait être résolu, les modèles linguistiques pourraient réellement égaler, voire surpasser, les capacités de résolution de problèmes des humains. Ce point de vue rejoint une récente publication de Google DeepMind qui souligne que l'ouverture est à la base de l'intelligence artificielle générale (IAG).

Parmi les hauts responsables de l'IA qui ont quitté OpenAI cette année, Karpathy travaille actuellement à la création de sa propre start-up dans le domaine de l'éducation à l'IA. Ses déclarations ont sans aucun doute apporté une nouvelle dimension à la réflexion dans le domaine de la recherche sur l'IA et fourni de précieuses perspectives sur l'avenir du développement de l'IA.

Le point de vue de Karpathy a suscité de nombreux débats au sein du secteur. Les partisans estiment qu'il a mis en lumière un problème crucial de la recherche actuelle sur l'IA, à savoir comment donner à l'IA une véritable capacité à résoudre des problèmes complexes, et non pas seulement à imiter les comportements humains. Les opposants craignent qu'abandonner trop tôt le RLHF puisse entraîner un écart dans la direction du développement de l'IA.

Adresse de l'article : https://arxiv.org/pdf/1706.03741