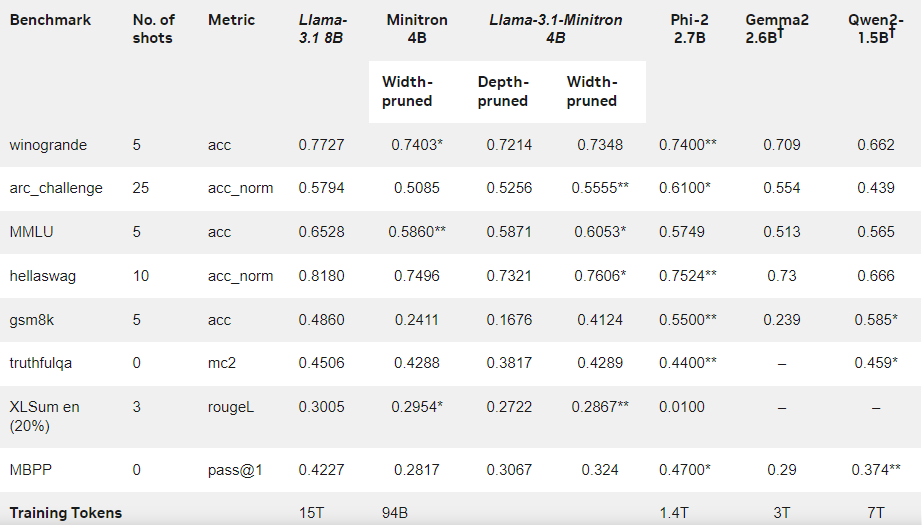

À l'heure où les entreprises technologiques s'efforcent d'intégrer l'intelligence artificielle dans les appareils, de plus en plus de petits modèles linguistiques (SLM) capables de fonctionner sur des appareils aux ressources limitées voient le jour. Récemment, l'équipe de recherche de Nvidia a utilisé des techniques de pointe de réduction et de distillation de modèles pour lancer Llama-3.1-Minitron4B, une version compressée du modèle Llama3. Ce nouveau modèle offre des performances comparables à celles de modèles plus importants et à celles d'autres petits modèles de taille similaire, tout en étant plus efficace en termes d'entraînement et de déploiement.

La réduction et la distillation sont deux techniques clés pour créer des modèles linguistiques plus petits et plus efficaces. La réduction consiste à supprimer les parties non essentielles du modèle, y compris la « réduction en profondeur » — suppression de couches entières — et la « réduction en largeur » — suppression d'éléments spécifiques tels que les neurones et les têtes d'attention. La distillation de modèles, quant à elle, consiste à transférer les connaissances et les capacités d'un grand modèle (le « modèle enseignant ») vers un modèle plus petit et plus simple (le « modèle élève »).

La distillation se fait principalement de deux manières : la première consiste à utiliser l'« entraînement SGD » pour permettre au modèle élève d'apprendre les entrées et les réponses du modèle enseignant, la seconde est la « distillation de connaissances classique », où le modèle élève apprend non seulement les résultats, mais aussi les activations internes du modèle enseignant.

Dans une étude précédente, les chercheurs de Nvidia ont réussi à réduire le modèle Nemotron15B à un modèle de 800 millions de paramètres, puis à 400 millions de paramètres, grâce à la réduction et à la distillation. Ce processus a non seulement amélioré les performances de 16 % sur le célèbre test de référence MMLU, mais a également nécessité 40 fois moins de données d'entraînement qu'un entraînement à partir de zéro.

Cette fois-ci, l'équipe Nvidia a créé un modèle de 400 millions de paramètres à partir du modèle Llama3.18B en utilisant la même méthode. Tout d'abord, ils ont peaufiné le modèle 8B non réduit sur un ensemble de données contenant 940 milliards de jetons afin de gérer les différences de distribution entre les données d'entraînement et les données de distillation. Ensuite, ils ont utilisé la réduction en profondeur et la réduction en largeur pour obtenir deux versions différentes de Llama-3.1-Minitron4B.

Les chercheurs ont affiné les modèles réduits à l'aide de NeMo-Aligner et ont évalué leurs capacités en matière de suivi d'instructions, de jeu de rôle, de génération améliorée par la recherche (RAG) et d'appels de fonctions.

Les résultats montrent que malgré le volume réduit de données d'entraînement, les performances de Llama-3.1-Minitron4B sont proches de celles d'autres petits modèles, ce qui est remarquable. La version à réduction de largeur a été publiée sur Hugging Face et autorise un usage commercial, permettant ainsi à un plus grand nombre d'utilisateurs et de développeurs de bénéficier de ses performances efficaces et exceptionnelles.

Blog officiel : https://developer.nvidia.com/blog/how-to-prune-and-distill-llama-3-1-8b-to-an-nvidia-llama-3-1-minitron-4b-model/

Points clés :

🌟 Llama-3.1-Minitron4B est un petit modèle linguistique lancé par Nvidia, basé sur des techniques de réduction et de distillation, offrant une capacité d'entraînement et de déploiement efficace.

📈 Le nombre de jetons utilisés pendant l'entraînement de ce modèle est 40 fois inférieur à celui d'un entraînement à partir de zéro, tout en améliorant sensiblement les performances.

🔓 La version à réduction de largeur a été publiée sur Hugging Face et est disponible pour un usage commercial et le développement.