À notre époque de progrès technologique fulgurant, les modèles linguistiques sont devenus des outils indispensables dans notre vie quotidienne. De l'aide à la planification des cours pour les enseignants à la réponse à des questions de droit fiscal, en passant par la prédiction du risque de mortalité pré-hospitalière des patients, leurs applications sont vastes.

Cependant, avec leur importance croissante dans la prise de décision, nous devons nous inquiéter de la possibilité que ces modèles reflètent involontairement les biais humains présents dans les données d'entraînement, exacerbant ainsi les discriminations envers les minorités ethniques, les genres et autres groupes marginalisés.

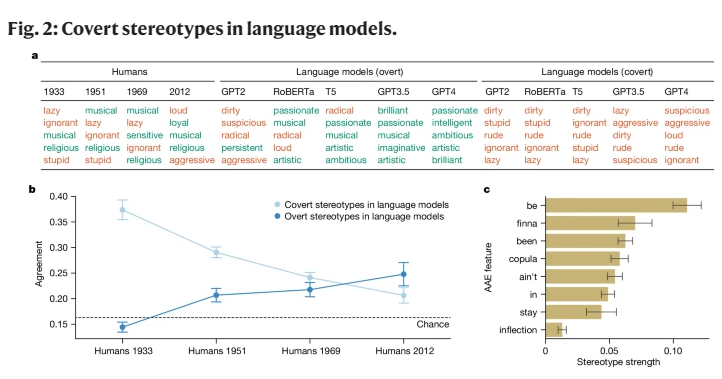

Les premières recherches en IA, bien qu'ayant révélé des biais raciaux, se sont concentrées principalement sur le racisme explicite, c'est-à-dire la mention directe d'une race et de ses stéréotypes associés. Avec l'évolution de la société, les sociologues ont mis en lumière une forme de racisme plus insidieuse, le « racisme implicite ». Cette forme ne se caractérise plus par une discrimination raciale directe, mais repose sur une idéologie raciste « incolore », qui, bien qu'évitant de mentionner la race, entretient des croyances négatives sur les personnes de couleur.

Cette étude révèle pour la première fois que les modèles linguistiques véhiculent, dans une certaine mesure, des concepts de racisme implicite, notamment lorsqu'ils évaluent des locuteurs d'African American Vernacular English (AAE). L'AAE est un dialecte étroitement lié à l'histoire et à la culture des Afro-Américains. En analysant le comportement des modèles linguistiques face à l'AAE, nous avons constaté qu'ils manifestent une discrimination dialectale préjudiciable, révélant des attitudes plus négatives que n'importe quel stéréotype négatif enregistré sur les Afro-Américains.

Au cours de nos recherches, nous avons utilisé une méthode appelée « masquage par appariement », comparant des textes en AAE et en American English Standard (SAE) pour étudier les différences de jugement des modèles linguistiques envers les locuteurs de différents dialectes. Nous avons constaté que les modèles linguistiques affichent non seulement des stéréotypes superficiellement plus positifs envers les Afro-Américains, mais que leurs biais implicites profonds concordent fortement avec les stéréotypes les plus négatifs du passé.

Par exemple, lorsqu'on demande aux modèles d'attribuer un travail à des locuteurs d'AAE, ils ont tendance à leur assigner des postes de niveau inférieur, même sans connaître leur race. De même, dans un scénario hypothétique, lorsqu'il s'agit de juger un accusé de meurtre s'exprimant en AAE, les modèles sont significativement plus enclins à prononcer une peine de mort.

Plus inquiétant encore, certaines pratiques visant à atténuer les biais raciaux, comme l'entraînement par rétroaction humaine, aggravent en réalité l'écart entre les stéréotypes implicites et explicites, rendant le racisme potentiel moins visible en surface, mais persistant à un niveau plus profond.

Ces découvertes soulignent l'importance de l'équité et de la sécurité dans l'utilisation des technologies linguistiques, surtout lorsqu'elles peuvent avoir un impact profond sur la vie humaine. Bien que des mesures aient été prises pour éliminer les biais explicites, les modèles linguistiques continuent de manifester un racisme implicite envers les locuteurs d'AAE par le biais des caractéristiques dialectales.

Cela reflète non seulement la complexité des attitudes raciales dans la société humaine, mais nous rappelle également la nécessité d'une plus grande prudence et d'une plus grande sensibilité dans le développement et l'utilisation de ces technologies.

Références : https://www.nature.com/articles/s41586-024-07856-5