Récemment, Google a annoncé le lancement de « gemma-2-2b-jpn-it », le dernier né de sa série de modèles linguistiques Gemma. Ce modèle, optimisé spécifiquement pour la langue japonaise, témoigne de la détermination de Google à investir continuellement dans les grands modèles linguistiques (LLM).

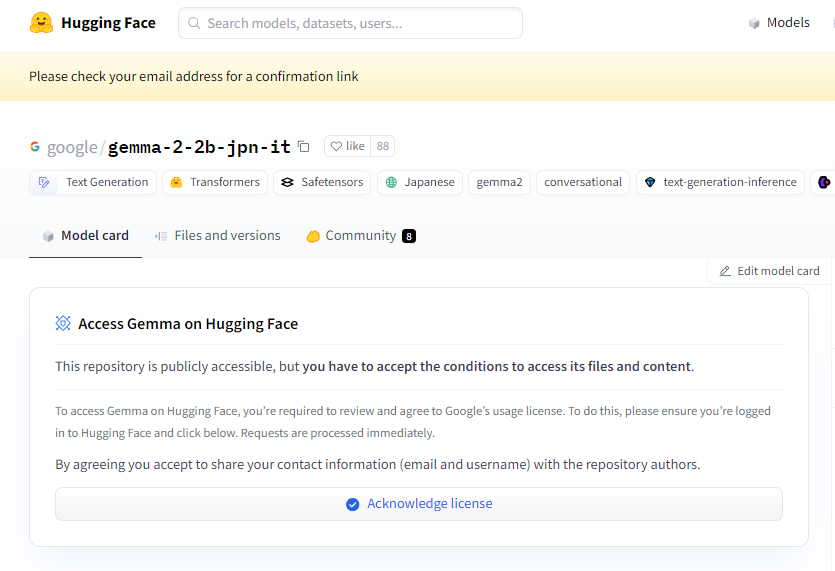

Accès au projet : https://huggingface.co/google/gemma-2-2b-jpn-it

gemma-2-2b-jpn-it est un grand modèle linguistique de type décodeur texte-texte, avec des poids ouverts, ce qui signifie qu'il est accessible au public et peut être finement ajusté pour différentes tâches de génération de texte, telles que les questions-réponses, la synthèse et le raisonnement.

Ce nouveau modèle possède 2,61 milliards de paramètres et utilise le type de tenseur BF16. Conçu sur l'architecture de la série de modèles Gemini de Google, il est doté d'une documentation technique et de ressources très avancées, permettant aux développeurs d'intégrer facilement l'inférence dans diverses applications. Il est important de noter que ce modèle est compatible avec le dernier matériel TPU de Google, en particulier le TPUv5p. Ce matériel offre une puissance de calcul exceptionnelle, permettant un entraînement plus rapide et de meilleures performances du modèle, surpassant largement les infrastructures CPU traditionnelles.

Sur le plan logiciel, gemma-2-2b-jpn-it est entraîné à l'aide des frameworks JAX et ML Pathways. JAX est spécialement optimisé pour les applications d'apprentissage automatique hautes performances, tandis que ML Pathways fournit une plateforme flexible pour organiser l'ensemble du processus d'entraînement. Cette combinaison permet à Google de mettre en œuvre un processus d'entraînement efficace.

Avec la sortie de gemma-2-2b-jpn-it, son potentiel d'application dans de nombreux domaines a suscité un intérêt considérable. Ce modèle peut exceller dans la création de contenu et la communication, par exemple en générant des poèmes, des scripts, du code, des textes marketing, voire des réponses de chatbot. Ses capacités de génération de texte conviennent également aux tâches de résumé, permettant de condenser de longs textes en résumés concis, idéal pour la recherche, l'éducation et l'exploration des connaissances.

Cependant, gemma-2-2b-jpn-it présente certaines limitations que les utilisateurs doivent connaître. Les performances du modèle dépendent de la diversité et de la qualité de ses données d'entraînement. Des biais ou des lacunes dans les données peuvent affecter les réponses du modèle. De plus, les grands modèles linguistiques n'ayant pas de base de connaissances intégrée, ils peuvent générer des affirmations factuelles inexactes ou obsolètes lors du traitement de requêtes complexes.

Lors du développement, Google a accordé une grande importance aux considérations éthiques, en effectuant une évaluation rigoureuse de gemma-2-2b-jpn-it pour faire face aux problèmes liés à la sécurité du contenu, aux préjudices liés à la représentation et à la mémorisation des données d'entraînement. Google a également mis en œuvre des techniques de filtrage pour exclure les contenus nuisibles et a établi un cadre de transparence et de responsabilité, encourageant les développeurs à surveiller en permanence et à adopter des techniques de protection de la vie privée pour garantir le respect des réglementations en matière de protection des données.

Points clés :

🌟 Le modèle gemma-2-2b-jpn-it, lancé par Google, est optimisé pour la langue japonaise, avec 2,61 milliards de paramètres et une architecture technique avancée.

💡 Ce modèle présente un large potentiel d'application dans la création de contenu et le traitement du langage naturel, prenant en charge diverses tâches de génération de texte.

🔒 Google accorde une importance primordiale aux considérations éthiques lors du développement du modèle, en mettant en œuvre des filtres de sécurité du contenu et des mesures de protection de la vie privée afin de réduire les risques.