Récemment, OpenAI a publié un nouveau benchmark nommé SimpleQA, conçu pour évaluer la précision factuelle des réponses générées par les modèles linguistiques.

Avec le développement rapide des grands modèles linguistiques, garantir l'exactitude du contenu généré pose de nombreux défis, notamment les phénomènes dits « d'hallucinations », où le modèle génère des informations qui semblent sûres mais qui sont en réalité erronées ou invérifiables. Cette situation est d'autant plus importante que de plus en plus de personnes dépendent de l'IA pour obtenir des informations.

SimpleQA se caractérise par sa focalisation sur des questions courtes et précises, qui ont généralement une réponse définitive, ce qui permet d'évaluer plus facilement la justesse des réponses du modèle. Contrairement à d'autres benchmarks, les questions de SimpleQA sont soigneusement conçues pour mettre au défi même les modèles les plus avancés comme GPT-4. Ce benchmark comprend 4326 questions couvrant plusieurs domaines : histoire, sciences, technologie, art et divertissement, en mettant l'accent sur l'évaluation de la précision et de la capacité d'étalonnage du modèle.

La conception de SimpleQA repose sur plusieurs principes clés. Premièrement, chaque question possède une réponse de référence déterminée par deux formateurs IA indépendants, garantissant ainsi l'exactitude de la réponse.

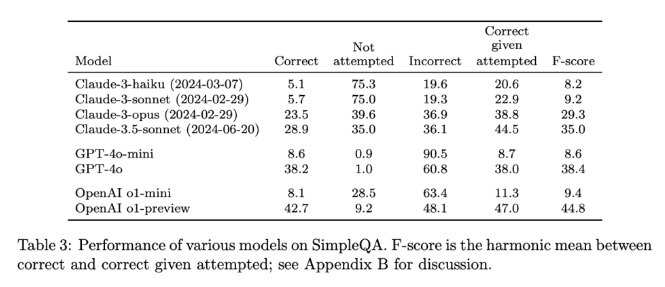

Deuxièmement, la formulation des questions évite toute ambiguïté ; chaque question peut être répondue par une réponse simple et claire, ce qui simplifie la notation. De plus, SimpleQA utilise un classificateur ChatGPT pour la notation, marquant clairement les réponses comme « correctes », « incorrectes » ou « non tentées ».

Un autre avantage de SimpleQA est sa couverture de questions diversifiées, évitant une spécialisation excessive du modèle et assurant une évaluation complète. L'utilisation de cet ensemble de données est simple, car les questions et les réponses sont courtes, ce qui permet des tests rapides et des variations de résultats minimes. De plus, SimpleQA prend en compte la pertinence à long terme des informations, évitant ainsi les biais liés à l'évolution des informations, ce qui en fait un benchmark « pérenne ».

La publication de SimpleQA représente une étape importante pour améliorer la fiabilité des informations générées par l'IA. Il fournit non seulement un benchmark facile à utiliser, mais il établit également une norme élevée pour les chercheurs et les développeurs, les encourageant à créer des modèles capables non seulement de générer du langage, mais aussi de le faire avec exactitude et véracité. En étant open source, SimpleQA offre à la communauté IA un outil précieux pour améliorer la précision factuelle des modèles linguistiques, afin de garantir que les futurs systèmes d'IA soient à la fois informatifs et fiables.

Accès au projet : https://github.com/openai/simple-evals

Page de détails : https://openai.com/index/introducing-simpleqa/

Points clés :

📊 SimpleQA est un nouveau benchmark d'OpenAI, axé sur l'évaluation de la précision factuelle des modèles linguistiques.

🧠 Ce benchmark est composé de 4326 questions courtes et précises, couvrant plusieurs domaines, pour une évaluation complète.

🔍 SimpleQA aide les chercheurs à identifier et à améliorer les capacités des modèles linguistiques à générer un contenu précis.