Vous avez entendu parler de ChatGPT, Wenxin Yiyan et autres IA sophistiquées ? La technologie sous-jacente à ces outils est le « modèle linguistique de grande taille » (LLM). Cela semble complexe et difficile à comprendre ? Ne vous inquiétez pas, même avec un niveau de mathématiques de CE2, vous pourrez comprendre le fonctionnement d’un LLM après avoir lu cet article !

Réseaux neuronaux : la magie des nombres

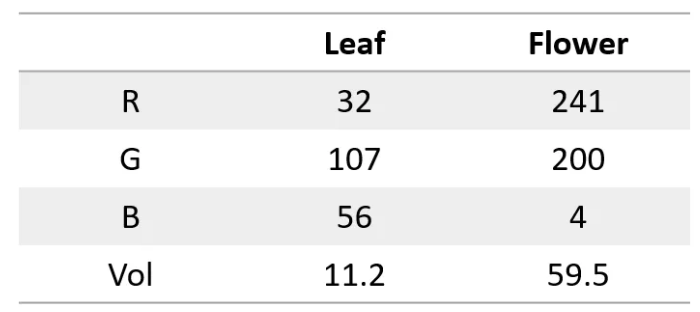

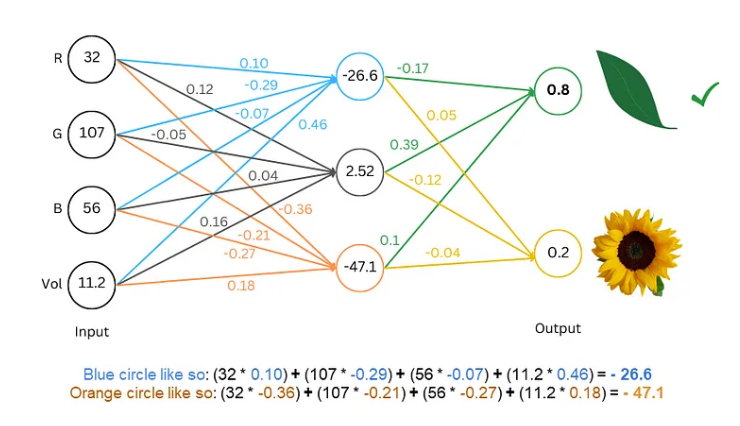

Tout d’abord, il faut savoir qu’un réseau neuronal est comme une super-calculatrice qui ne traite que des nombres. Les entrées et les sorties doivent être numériques. Mais comment lui faire comprendre le texte ?

Le secret est de convertir le texte en nombres ! Par exemple, on peut représenter chaque lettre par un nombre : a=1, b=2, et ainsi de suite. De cette façon, le réseau neuronal peut « lire » le texte.

Entraînement du modèle : apprendre le langage au réseau

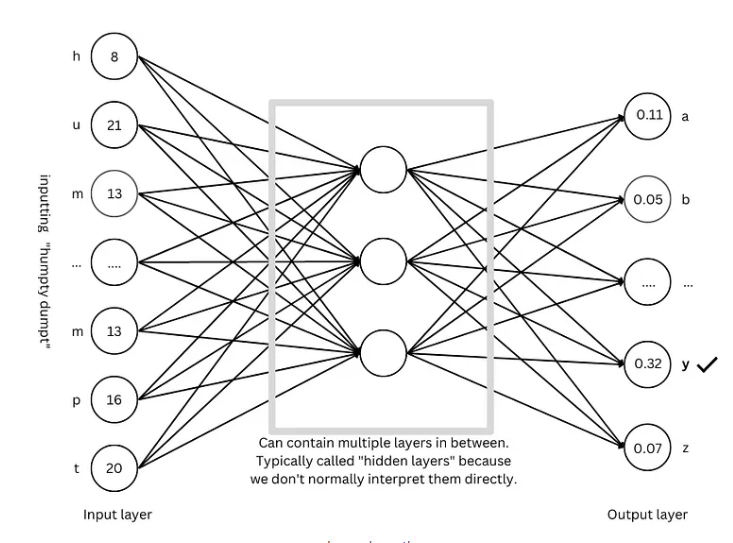

Une fois le texte numérisé, il faut entraîner le modèle pour que le réseau neuronal « apprenne » les règles du langage.

L’entraînement est comme un jeu de devinettes. On montre au réseau du texte, par exemple « Humpty Dumpty », puis on lui demande de deviner la lettre suivante. S’il devine correctement, on le récompense ; s’il se trompe, on le pénalise. Grâce à ces devinettes et ajustements répétés, le réseau peut prédire de plus en plus précisément la lettre suivante et finalement générer des phrases complètes, comme « Humpty Dumpty sat on a wall ».

Techniques avancées : rendre le modèle plus « intelligent »

Pour rendre le modèle plus « intelligent », les chercheurs ont développé de nombreuses techniques avancées, telles que :

Incorporations de mots : Au lieu de représenter les lettres par de simples nombres, on utilise un ensemble de nombres (vecteur) pour représenter chaque mot, ce qui permet de décrire plus précisément le sens des mots.

Sous-mot : Découper les mots en unités plus petites (sous-mots), par exemple « cats » en « cat » et « s », ce qui réduit le vocabulaire et améliore l’efficacité.

Mécanisme d’auto-attention : Lors de la prédiction du mot suivant, le modèle ajuste les poids de prédiction en fonction de tous les mots du contexte, comme lorsque nous lisons et comprenons le sens des mots en fonction du contexte.

Connexions résiduelles : Pour éviter les difficultés d’entraînement dues au nombre excessif de couches du réseau, les chercheurs ont inventé les connexions résiduelles, ce qui facilite l’apprentissage du réseau.

Mécanisme d’attention multi-têtes : En exécutant plusieurs mécanismes d’attention en parallèle, le modèle peut comprendre le contexte sous différents angles, améliorant ainsi la précision des prédictions.

Encodage de position : Pour que le modèle comprenne l’ordre des mots, les chercheurs ajoutent des informations de position aux incorporations de mots, comme lorsque nous lisons et prêtons attention à l’ordre des mots.

Architecture GPT : le « plan » des modèles linguistiques de grande taille

L’architecture GPT est l’une des architectures les plus populaires de modèles linguistiques de grande taille. C’est comme un « plan » qui guide la conception et l’entraînement du modèle. L’architecture GPT combine intelligemment les différentes techniques avancées mentionnées ci-dessus, permettant au modèle d’apprendre et de générer du langage efficacement.

Architecture Transformer : la « révolution » des modèles linguistiques

L’architecture Transformer est une avancée majeure dans le domaine des modèles linguistiques ces dernières années. Elle a non seulement amélioré la précision des prédictions, mais a également réduit la difficulté de l’entraînement, jetant les bases du développement des modèles linguistiques de grande taille. L’architecture GPT est également issue de l’évolution de l’architecture Transformer.

Références : https://towardsdatascience.com/understanding-llms-from-scratch-using-middle-school-math-e602d27ec876