Dans la course au développement des grands modèles linguistiques (LLM), les entreprises d'intelligence artificielle sont confrontées à des défis croissants, ce qui pousse de plus en plus de regards vers des architectures alternatives au « Transformer ». L'architecture Transformer, proposée par des chercheurs de Google en 2017, est devenue la pierre angulaire de l'IA générative actuelle. Pour relever ce défi, Liquid AI, une startup issue du MIT, a lancé un cadre innovant appelé STAR (Synthesis of Tailored Architectures).

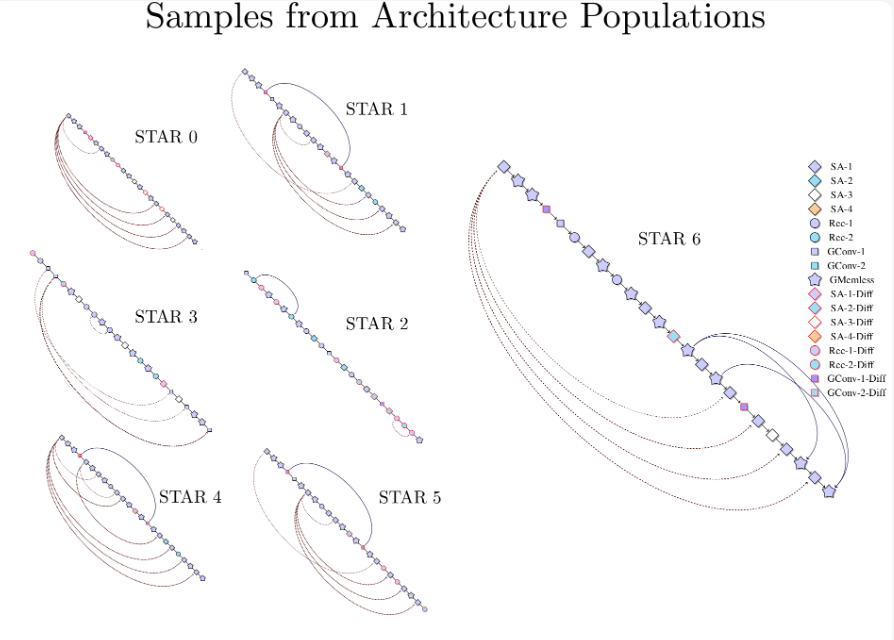

Le cadre STAR utilise des algorithmes évolutionnaires et un système de codage numérique pour automatiser la génération et l'optimisation des architectures de modèles d'IA. L'équipe de recherche de Liquid AI souligne que la méthode de conception de STAR diffère des conceptions d'architectures traditionnelles. Elle utilise une technique de codage hiérarchique, appelée « génome STAR », pour explorer un vaste espace de conception d'architectures potentielles. Grâce à la combinaison et à la mutation des génomes, STAR peut synthétiser et optimiser des architectures répondant à des exigences spécifiques de performance et de matériel.

Lors de tests sur la modélisation linguistique autorégressive, STAR a démontré une capacité supérieure aux Transformer++ optimisés traditionnels et aux modèles hybrides. En termes de qualité d'optimisation et de taille du cache, les architectures évoluées par STAR ont réduit la taille du cache jusqu'à 37 % par rapport aux modèles hybrides et jusqu'à 90 % par rapport aux Transformer traditionnels. Cette efficacité n'a pas compromis les performances prédictives du modèle ; elle les a même surpassées dans certains cas.

L'étude montre également que l'architecture STAR est hautement évolutive. Un modèle STAR évolué, passant de 125 millions à 1 milliard de paramètres, a obtenu des performances comparables ou supérieures aux Transformer++ et aux modèles hybrides existants lors de tests de référence standard, tout en réduisant considérablement les besoins en cache d'inférence.

Liquid AI indique que la conception de STAR intègre les principes des systèmes dynamiques, du traitement du signal et de l'algèbre linéaire numérique, créant ainsi un espace de recherche d'unités de calcul flexible. Une des caractéristiques principales de STAR est sa conception modulaire, lui permettant de coder et d'optimiser les architectures à plusieurs niveaux, offrant ainsi aux chercheurs la possibilité d'analyser les combinaisons efficaces de composants d'architecture.

Liquid AI estime que la capacité de synthèse d'architectures efficaces de STAR trouvera des applications dans divers domaines, en particulier dans les scénarios où il est nécessaire de trouver un équilibre entre qualité et efficacité de calcul. Bien que Liquid AI n'ait pas encore annoncé de déploiement commercial ou de tarification spécifiques, ses résultats de recherche marquent une avancée majeure dans le domaine de la conception automatisée d'architectures. Avec l'évolution constante du domaine de l'IA, des cadres comme STAR pourraient jouer un rôle important dans la conception des systèmes intelligents de prochaine génération.

Blog officiel : https://www.liquid.ai/research/automated-architecture-synthesis-via-targeted-evolution

Points clés :

🌟 Liquid AI lance le cadre STAR qui utilise des algorithmes évolutionnaires pour générer et optimiser automatiquement les architectures de modèles d'IA.

📉 Les modèles STAR réduisent la taille du cache jusqu'à 90 % et surpassent les performances des Transformer traditionnels.

🔍 La conception modulaire de STAR peut être appliquée à de nombreux domaines, favorisant le développement de l'optimisation des systèmes d'IA.