Une avancée majeure est attendue pour ARC-AGI, un benchmark important dans le domaine de l'intelligence artificielle, acronyme de « Abstract and Reasoning Corpus for General Artificial Intelligence ». Cependant, François Chollet, le créateur du test, met en garde : malgré l'amélioration des résultats, cela ne signifie pas que nous sommes proches de l'intelligence artificielle générale (AGI). Il souligne les failles de conception du test lui-même et le fait qu'il ne reflète pas nécessairement de véritables percées scientifiques.

Depuis son lancement en 2019 par Chollet, les systèmes d'IA ont constamment obtenu de mauvais résultats à l'ARC-AGI. À ce jour, le meilleur système n'a résolu qu'un peu moins d'un tiers des tâches. Chollet attribue cela principalement à la dépendance excessive de la recherche actuelle en IA aux grands modèles de langage (LLM). Il explique que bien que les LLM soient capables d'identifier des schémas dans des ensembles de données massifs, ils reposent sur la mémorisation plutôt que sur le raisonnement, ce qui les rend inefficaces face à des situations nouvelles ou à la véritable « raisonnement ».

« Les modèles LLM s'appuient sur l'extraction de schémas à partir des données d'entraînement, et non sur un raisonnement indépendant. Ils se contentent de « mémoriser » les schémas au lieu de générer de nouveaux raisonnements », explique Chollet dans une série de publications sur la plateforme X.

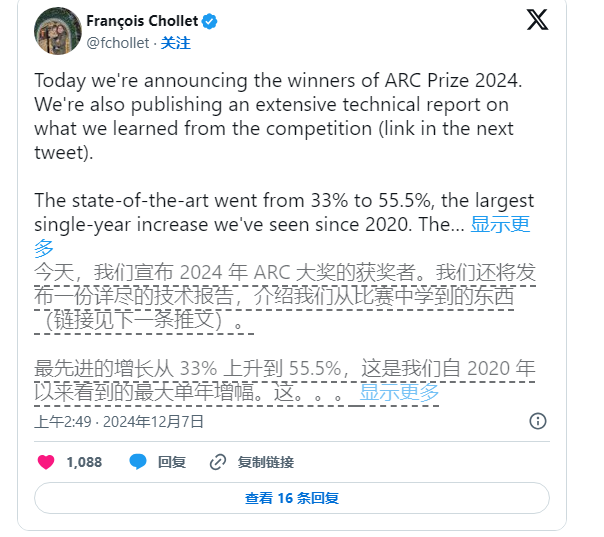

Néanmoins, Chollet ne cesse de promouvoir la recherche en IA. En juin dernier, avec Mike Knoop, le fondateur de Zapier, il a lancé un concours d'un million de dollars pour encourager les défis open source à l'ARC-AGI. Bien que le meilleur système d'IA parmi les 17 789 participants n'ait obtenu que 55,5 %, loin des 85 % nécessaires pour atteindre le niveau humain, Chollet et Knoop considèrent cela comme un pas important.

Dans un article de blog, Knoop souligne que ce résultat ne signifie pas que nous sommes plus proches de l'AGI, mais plutôt que certaines tâches de l'ARC-AGI reposent trop sur des solutions de « force brute », ne fournissant pas nécessairement des indicateurs fiables pour une intelligence générale véritable. L'ARC-AGI vise à tester les capacités de généralisation de l'IA en proposant des tâches complexes et inédites, mais l'efficacité de ces tâches pour évaluer l'AGI reste discutable.

Légende : Image générée par IA, Midjourney.

Les tâches de l'ARC-AGI, telles que des puzzles, exigent que l'IA infère des réponses inconnues à partir d'informations connues. Bien que ces tâches semblent favoriser l'adaptation de l'IA à de nouvelles situations, les résultats montrent que les modèles actuels semblent trouver des solutions par le calcul intensif, sans nécessairement démontrer une véritable capacité d'adaptation intelligente.

De plus, les créateurs de l'ARC-AGI font face à des critiques de la part de leurs pairs, notamment sur le flou de la définition de l'AGI. Un employé d'OpenAI a récemment déclaré que si l'AGI est définie comme une IA « surperformant la plupart des humains sur la plupart des tâches », alors l'AGI serait déjà une réalité. Cependant, Chollet et Knoop estiment que la conception actuelle de l'ARC-AGI n'a pas encore pleinement atteint cet objectif.

À l'avenir, Chollet et Knoop prévoient de publier une deuxième génération d'ARC-AGI et organiseront un nouveau concours en 2025 pour pallier les lacunes du test actuel. Ils affirment que le nouveau benchmark sera davantage axé sur l'orientation de la recherche en IA vers des directions plus prometteuses, accélérant ainsi le processus de réalisation de l'AGI.

Cependant, la correction du benchmark existant n'est pas une tâche facile. Les efforts de Chollet et Knoop montrent que la définition de l'intelligence artificielle, en particulier dans le domaine de l'intelligence générale, reste une tâche ardue et complexe.