Em uma pesquisa recente, o Google, em colaboração com a Universidade Carnegie Mellon e a equipe MultiOn, investigou os efeitos dos dados sintéticos no treinamento de modelos de linguagem de grande porte. Eles descobriram que os dados sintéticos podem melhorar significativamente o desempenho desses modelos em raciocínio lógico, especialmente na resolução de problemas matemáticos, com uma melhoria impressionante de oito vezes. Essa descoberta é extremamente relevante no contexto da crescente escassez de dados de treinamento.

Atualmente, existem cerca de 300 trilhões de exemplos de dados de treinamento de texto de alta qualidade disponíveis globalmente. No entanto, com a crescente popularização de modelos como o ChatGPT, a demanda por dados de treinamento está aumentando drasticamente, e espera-se que a oferta seja insuficiente até 2026. Nesse contexto, os dados sintéticos se tornam uma alternativa crucial.

A equipe de pesquisa explorou principalmente dois tipos de dados sintéticos: dados positivos e dados negativos. Os dados positivos são soluções corretas para problemas geradas por modelos de alto desempenho, como GPT-4 e Gemini 1.5 Pro, fornecendo exemplos para outros modelos. No entanto, treinar modelos apenas com dados positivos apresenta algumas desvantagens. Por exemplo, o modelo pode aprender por meio de correspondência de padrões, sem realmente compreender o processo de resolução do problema, levando a uma redução na capacidade de generalização.

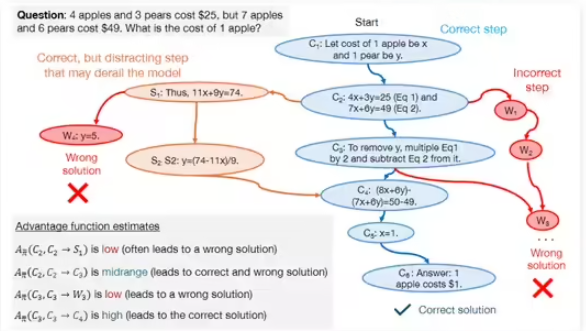

Para superar essas limitações, a equipe introduziu dados negativos, que são passos incorretos na resolução de problemas. Esses dados ajudam o modelo a identificar erros comuns, melhorando sua capacidade de raciocínio lógico. Embora o uso de dados negativos apresente alguns desafios, pois os passos incorretos podem conter informações enganosas, os pesquisadores utilizaram a otimização de preferência direta (DPO) para permitir que o modelo aprenda efetivamente com os erros, esclarecendo a importância de cada passo no processo de resolução do problema.

Durante a pesquisa, a equipe utilizou modelos como DeepSeek-Math-7B e LLaMa2-7B, realizando diversos testes nos conjuntos de dados GSM8K e MATH. Os resultados mostraram que os modelos de linguagem de grande porte pré-treinados com dados sintéticos positivos e negativos apresentaram uma melhoria de oito vezes no desempenho em tarefas de raciocínio matemático. Essa descoberta não apenas demonstra o enorme potencial dos dados sintéticos em melhorar a capacidade de raciocínio lógico de modelos de linguagem de grande porte, mas também oferece novas perspectivas para o treinamento de modelos futuros.