2025-02-18 16:55:26.AIbase.

OpenAI lance SWE-Lancer : une nouvelle référence pour évaluer les performances des modèles sur les tâches réelles de freelancing en ingénierie logicielle

2024-12-25 09:22:05.AIbase.

Record battu ! Le nouveau modèle o3 d'OpenAI fait sensation sur le benchmark ARC-AGI

2024-12-20 16:10:44.AIbase.

LongBench v2 : un nouveau benchmark pour l'évaluation des modèles de langage de grande taille (LLM) sur les longs textes, développé par l'Institut d'Intelligence Artificielle de Pékin (BAAI) et Tencent

2024-12-15 10:23:35.AIbase.

Alibaba lance PROCESSBENCH, un nouveau benchmark IA pour évaluer la capacité de détection d'erreurs dans le raisonnement mathématique

2024-12-10 11:31:07.AIbase.

Le benchmark ARC-AGI sur le point d'être dépassé, mais son créateur met en garde contre des failles de conception

2024-08-16 14:03:40.AIbase.

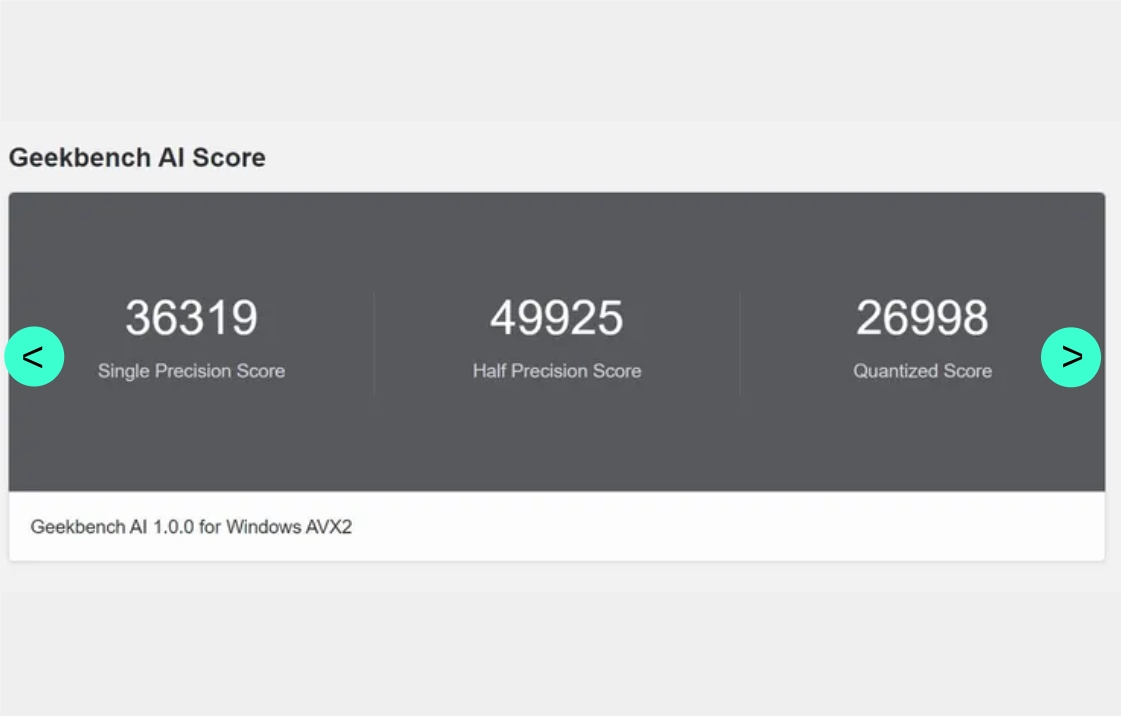

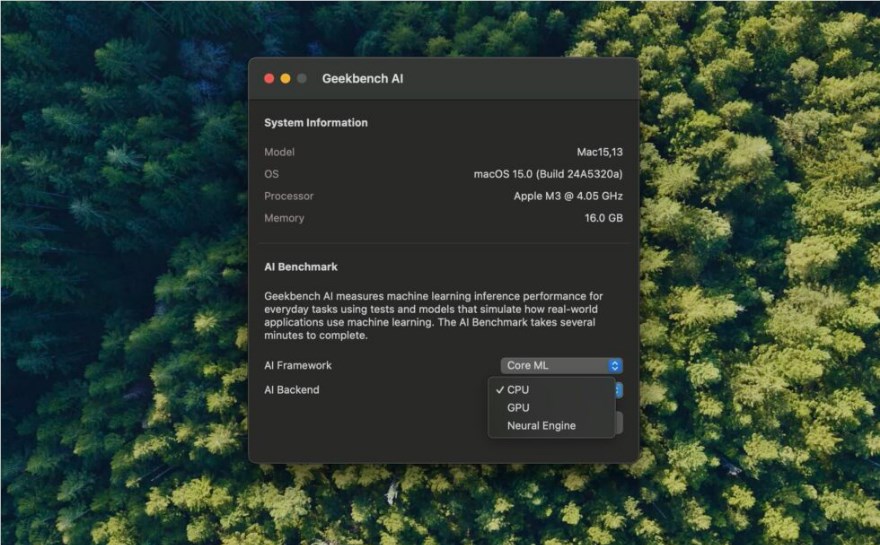

Geekbench lance un nouveau benchmark IA pour évaluer les performances des appareils sur les tâches d'IA

2024-08-16 09:49:46.AIbase.

Le nouveau benchmark Geekbench AI teste les performances du CPU, du GPU et du NPU

2024-08-07 16:35:17.AIbase.

L'Institut de recherche en technologie de communication de l'Université de Pékin publie LooGLE, un benchmark extrêmement difficile pour tester la compréhension de longs textes ; les grands modèles linguistiques sont mis en échec !

2024-07-02 09:07:20.AIbase.

Anthropic lance un programme de financement pour le développement de benchmarks d'évaluation de l'IA

2024-06-17 14:58:57.AIbase.

LVBench : Lancement d'un benchmark collaboratif de compréhension de vidéos longues par Tsinghua et Pékin

2023-12-25 14:12:47.AIbase.

L'Institut de Recherche sur l'Intelligence Artificielle (AIR) publie TACO, un ensemble de données d'entraînement pour la génération de code

2023-12-12 16:20:29.AIbase.

智谱 AI 发布中文 LLM 对齐评测基准 AlignBench

2023-11-02 15:21:41.AIbase.

Ant Group publie un benchmark de modèles de langage volumineux pour le domaine DevOps

2023-08-09 14:07:10.AIbase.