कृत्रिम बुद्धिमत्ता के क्षेत्र में, बड़े भाषा मॉडल (LLMs) जैसे GPT-3 और Llama-2 ने मानव भाषा को सटीकता से समझने और उत्पन्न करने में महत्वपूर्ण प्रगति की है। हालाँकि, इन मॉडलों की विशाल पैरामीटर संख्या उन्हें प्रशिक्षण और तैनाती के दौरान बहुत सारे कंप्यूटिंग संसाधनों की आवश्यकता बनाती है, जो संसाधनों की कमी वाले वातावरण के लिए एक चुनौती बन जाती है।

पेपर का लिंक: https://arxiv.org/html/2406.10260v1

पारंपरिक रूप से, विभिन्न कंप्यूटिंग संसाधन सीमाओं के तहत दक्षता और सटीकता के संतुलन को प्राप्त करने के लिए, शोधकर्ताओं को विभिन्न संस्करणों के कई मॉडलों को प्रशिक्षित करने की आवश्यकता होती है। उदाहरण के लिए, Llama-2 मॉडल श्रृंखला में 70 अरब, 13 अरब और 7 अरब पैरामीटर के विभिन्न रूपांतर शामिल हैं। हालाँकि, इस दृष्टिकोण में बहुत सारे डेटा और कंप्यूटिंग संसाधनों की आवश्यकता होती है, जो प्रभावी नहीं है।

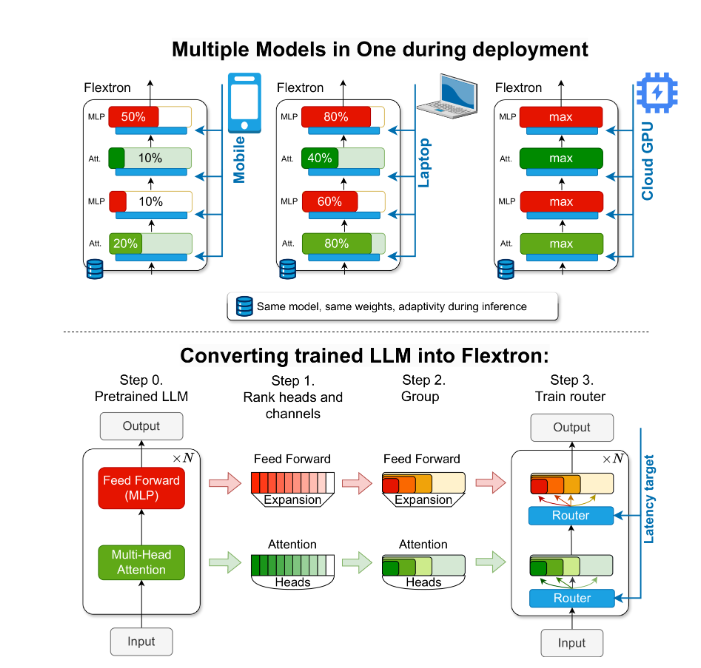

इस समस्या को हल करने के लिए, NVIDIA और टेक्सास विश्वविद्यालय, ऑस्टिन के शोधकर्ताओं ने Flextron ढांचे को पेश किया। Flextron एक नवोन्मेषी लचीला मॉडल आर्किटेक्चर और बाद के प्रशिक्षण अनुकूलन ढांचा है, जो बिना किसी अतिरिक्त ट्यूनिंग के मॉडल को अनुकूल रूप से तैनात करने का समर्थन करता है, इस प्रकार पारंपरिक तरीकों की अक्षमता की समस्या को हल करता है।

Flextron नमूना कुशल प्रशिक्षण विधियों और उन्नत राउटिंग एल्गोरिदम के माध्यम से पूर्व-प्रशिक्षित LLM को लचीले मॉडल में बदलता है। यह संरचना नस्टेड लचीलापन डिज़ाइन को अपनाती है, जो विशिष्ट विलंबता और सटीकता लक्ष्यों को पूरा करने के लिए इनफेरेंस के दौरान गतिशील रूप से समायोजन की अनुमति देती है। यह अनुकूलता विभिन्न तैनाती परिदृश्यों में एकल पूर्व-प्रशिक्षित मॉडल के उपयोग को संभव बनाती है, जिससे कई मॉडल रूपांतरों की आवश्यकता में महत्वपूर्ण कमी आती है।

Flextron के प्रदर्शन मूल्यांकन से पता चलता है कि यह कई एंड-टू-एंड प्रशिक्षित मॉडलों और अन्य अत्याधुनिक लचीले नेटवर्क की तुलना में दक्षता और सटीकता में उत्कृष्ट प्रदर्शन करता है। उदाहरण के लिए, Flextron ने ARC-easy, LAMBADA, PIQA, WinoGrande, MMLU और HellaSwag जैसे कई बेंचमार्क परीक्षणों में उत्कृष्टता दिखाई, केवल 7.63% प्रशिक्षण मार्क्स का उपयोग करके, जिससे बहुत सारे कंप्यूटिंग संसाधनों और समय की बचत हुई।

Flextron ढांचे में लचीले मल्टी-लेयर परसेप्ट्रॉन (MLP) और लचीले मल्टी-हेड ध्यान (MHA) परतें भी शामिल हैं, जो इसकी अनुकूलता को और बढ़ाती हैं। लचीले MHA परत इनपुट डेटा के आधार पर ध्यान सिर के उपसमुच्चय का चयन करके उपलब्ध मेमोरी और प्रसंस्करण क्षमता का कुशलता से उपयोग करती है, जो विशेष रूप से सीमित कंप्यूटिंग संसाधनों वाले परिदृश्यों के लिए उपयुक्त है।

मुख्य बिंदु:

🌐 Flextron ढांचा लचीले AI मॉडल तैनाती का समर्थन करता है, बिना किसी अतिरिक्त ट्यूनिंग के।

🚀 नमूना कुशल प्रशिक्षण और उन्नत राउटिंग एल्गोरिदम के माध्यम से मॉडल की दक्षता और सटीकता में सुधार करता है।

💡 लचीला मल्टी-हेड ध्यान परत संसाधनों के उपयोग को अनुकूलित करता है, विशेष रूप से सीमित कंप्यूटिंग संसाधनों वाले वातावरण के लिए।

यह रिपोर्ट आशा करती है कि यह हाई स्कूल के छात्रों के पाठकों के लिए Flextron ढांचे के महत्व और नवोन्मेष को सरलता से समझा सके।