अगर एआई को अपने द्वारा उत्पन्न छवियों के साथ फिर से प्रशिक्षित किया जाए, तो परिणाम क्या होगा? हाल ही में, स्टैनफोर्ड विश्वविद्यालय और कैलिफ़ोर्निया विश्वविद्यालय बर्कले के शोधकर्ताओं ने ऐसा एक प्रयोग किया, जिसका परिणाम आश्चर्यजनक था।

शोधकर्ताओं ने पाया कि जब एआई छवि उत्पन्न करने वाले मॉडल को फिर से प्रशिक्षित किया गया, और इसे अपनी खुद की उत्पन्न छवियों का उपयोग किया गया, तो ये मॉडल अत्यधिक विकृत छवियाँ उत्पन्न करते हैं। इससे भी बुरा यह है कि यह विकृति केवल पुनः प्रशिक्षण के लिए उपयोग किए गए पाठ संकेतों तक सीमित नहीं है; एक बार जब मॉडल "प्रदूषित" हो जाता है, तो वास्तविक छवियों का उपयोग करके पुनः प्रशिक्षण करने पर भी, मॉडल को पूरी तरह से ठीक करना मुश्किल होता है।

इस प्रयोग की शुरुआत एक ओपन-सोर्स मॉडल नामक Stable Diffusion (SD) से हुई। शोधकर्ताओं ने पहले FFHQ चेहरे के डेटासेट से 70,000 उच्च गुणवत्ता वाली चेहरे की छवियों का चयन किया और उन्हें स्वचालित रूप से वर्गीकृत किया। फिर, उन्होंने इन वास्तविक छवियों का उपयोग करके, Stable Diffusion मॉडल के माध्यम से 900 छवियाँ उत्पन्न कीं जो विशेष जनसंख्या की विशेषताओं के अनुरूप थीं।

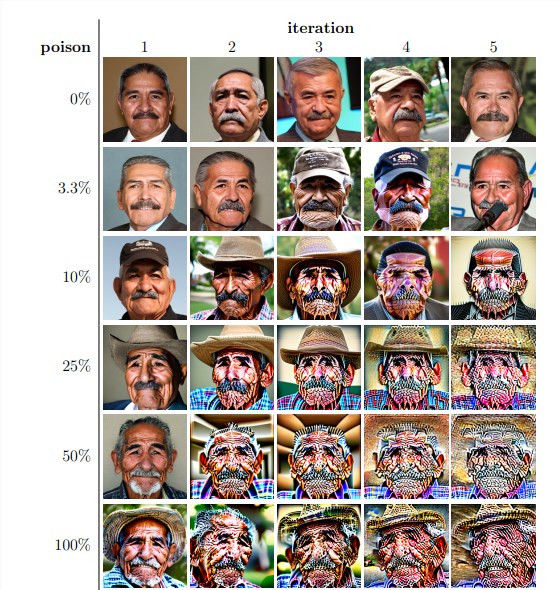

इसके बाद, शोधकर्ताओं ने इन उत्पन्न छवियों का उपयोग मॉडल के पुनरावृत्ति प्रशिक्षण के लिए किया। उन्होंने पाया कि पुनः प्रशिक्षण डेटा सेट में आत्म-उत्पन्न छवियों के अनुपात की परवाह किए बिना, मॉडल अंततः दुर्घटनाग्रस्त हो जाता है, और उत्पन्न छवियों की गुणवत्ता में तेजी से गिरावट आती है। यहां तक कि जब पुनः प्रशिक्षण डेटा में केवल 3% आत्म-उत्पन्न छवियाँ होती हैं, तब भी मॉडल के दुर्घटनाग्रस्त होने की घटना बनी रहती है।

प्रयोग के परिणामों से पता चलता है कि Stable Diffusion मॉडल का मूल संस्करण उत्पन्न की गई छवियाँ पाठ संकेतों के अनुरूप हैं, और दृश्य गुणवत्ता उच्च है। लेकिन जब मॉडल को पुनरावृत्ति प्रशिक्षण के माध्यम से प्रशिक्षित किया गया, तो उत्पन्न छवियों में अर्थ की असंगति और दृश्य विकृति शुरू हो गई। शोधकर्ताओं ने यह भी पाया कि मॉडल का दुर्घटनाग्रस्त होना केवल छवि गुणवत्ता को प्रभावित नहीं करता, बल्कि उत्पन्न छवियों में विविधता की कमी भी लाता है।

इसकी पुष्टि के लिए, शोधकर्ताओं ने नियंत्रण प्रयोग भी किए, जिसमें उत्पन्न छवियों के रंग के हिस्टोग्राम को समायोजित करने और निम्न गुणवत्ता की छवियों को हटाने का प्रयास किया गया, ताकि मॉडल के दुर्घटनाग्रस्त होने के प्रभाव को कम किया जा सके। लेकिन परिणाम बताते हैं कि ये उपाय मॉडल के दुर्घटनाग्रस्त होने को प्रभावी ढंग से रोक नहीं सकते।

शोधकर्ताओं ने यह भी चर्चा की कि क्या मॉडल को "प्रदूषित" होने के बाद पुनः प्रशिक्षण के माध्यम से ठीक किया जा सकता है। उन्होंने पाया कि हालाँकि कुछ मामलों में, कई पुनरावृत्तियों के बाद उत्पन्न छवियों की गुणवत्ता में कुछ सुधार होता है, लेकिन मॉडल के दुर्घटनाग्रस्त होने के संकेत अभी भी मौजूद रहते हैं। यह दर्शाता है कि एक बार जब मॉडल "प्रदूषित" हो जाता है, तो इसका प्रभाव दीर्घकालिक हो सकता है, यहां तक कि अपरिवर्तनीय भी।

यह अध्ययन एक महत्वपूर्ण समस्या को उजागर करता है: वर्तमान में लोकप्रिय विस्थापन आधारित पाठ से छवि उत्पन्न करने वाले एआई सिस्टम डेटा "प्रदूषण" के प्रति अत्यधिक संवेदनशील हैं। यह "प्रदूषण" अनजाने में हो सकता है, जैसे कि ऑनलाइन संसाधनों से छवियों को बिना चयन के खींचना। या यह लक्षित हमले के रूप में हो सकता है, जैसे कि जानबूझकर वेबसाइट पर "प्रदूषित" डेटा डालना।

इन चुनौतियों का सामना करते हुए, शोधकर्ताओं ने कुछ संभावित समाधान प्रस्तुत किए, जैसे एआई द्वारा उत्पन्न छवियों को बाहर करने के लिए छवि वास्तविकता का पता लगाने वाले उपकरणों का उपयोग करना, या उत्पन्न छवियों में वॉटरमार्क जोड़ना। ये विधियाँ भले ही संपूर्ण न हों, लेकिन मिलकर डेटा "प्रदूषण" के जोखिम को काफी कम कर सकती हैं।

यह अध्ययन हमें याद दिलाता है कि एआई तकनीक का विकास बिना जोखिम के नहीं है। हमें एआई द्वारा उत्पन्न सामग्री को अधिक सावधानी से संभालने की आवश्यकता है, यह सुनिश्चित करते हुए कि वे हमारे मॉडल और डेटासेट पर दीर्घकालिक नकारात्मक प्रभाव न डालें। भविष्य के अनुसंधान को यह अन्वेषण करने की आवश्यकता है कि एआई सिस्टम को इस प्रकार के डेटा "प्रदूषण" के प्रति अधिक लचीला कैसे बनाया जाए, या ऐसी तकनीकों का विकास किया जाए जो मॉडल के "चिकित्सा" को तेज कर सकें।

पेपर का पता: https://arxiv.org/pdf/2311.12202