क्या आपने कभी सोचा है कि आपका शोध पत्र संभवतः AI को प्रशिक्षित करने के लिए उपयोग किया गया हो सकता है? हां, कई शैक्षणिक प्रकाशक अपने परिणामों को AI मॉडल विकसित करने वाली तकनीकी कंपनियों को "पैक और बेच" रहे हैं, और निश्चित रूप से, यह कदम शोध समुदाय में काफी हलचल पैदा कर रहा है, विशेष रूप से जब लेखकों को इसके बारे में कुछ भी नहीं पता होता है। विशेषज्ञों का कहना है कि यदि आपका शोध किसी बड़े भाषा मॉडल (LLM) द्वारा उपयोग नहीं किया गया है, तो यह संभावना है कि इसे निकट भविष्य में "उपयोग" किया जाएगा।

हाल ही में, ब्रिटेन के शैक्षणिक प्रकाशक टेलर और फ्रांसिस (Taylor & Francis) ने माइक्रोसॉफ्ट के साथ 10 मिलियन डॉलर का एक समझौता किया है, जो इस तकनीकी दिग्गज को उनके शोध डेटा का उपयोग करने की अनुमति देता है ताकि AI प्रणाली की क्षमताओं को बढ़ाया जा सके। इससे पहले जून में, अमेरिकी प्रकाशक विली (Wiley) ने एक कंपनी के साथ एक सौदा किया, जिससे उन्हें 23 मिलियन डॉलर की आय हुई, क्योंकि उनके सामग्री का उपयोग जनरेटिव AI मॉडल को प्रशिक्षित करने के लिए किया गया।

यदि कोई शोध पत्र ऑनलाइन उपलब्ध है, चाहे वह ओपन एक्सेस हो या भुगतान दीवार के पीछे, तो यह संभावना है कि इसे किसी बड़े भाषा मॉडल में फीड किया गया है। वॉशिंगटन विश्वविद्यालय की AI शोधकर्ता लूसी लू वांग ने कहा: "एक बार जब एक शोध पत्र मॉडल को प्रशिक्षित करने के लिए उपयोग किया जाता है, तो इसे मॉडल के प्रशिक्षण के बाद हटाना संभव नहीं है।"

बड़े भाषा मॉडल को प्रशिक्षित करने के लिए बहुत सारे डेटा की आवश्यकता होती है, जो आमतौर पर इंटरनेट से इकट्ठा किया जाता है। अरबों भाषा के टुकड़ों का विश्लेषण करके, ये मॉडल प्रवाहपूर्ण पाठ को सीखने और उत्पन्न करने में सक्षम होते हैं। शैक्षणिक पत्र, अपनी जानकारी की घनत्व और लंबाई के कारण, LLM डेवलपर्स के लिए बहुत मूल्यवान "खजाना" बन गए हैं। ऐसा डेटा AI को विज्ञान के क्षेत्र में बेहतर तर्क करने में मदद करता है।

हाल ही में, उच्च गुणवत्ता वाले डेटा सेट खरीदने की प्रवृत्ति बढ़ रही है, और कई प्रसिद्ध मीडिया और प्लेटफार्मों ने AI डेवलपर्स के साथ सहयोग करना शुरू कर दिया है, अपने सामग्री को बेचने के लिए। यदि कोई समझौता नहीं होता है, तो कई कार्य बिना किसी सूचना के इकट्ठा किए जा सकते हैं, भविष्य में यह सहयोग केवल बढ़ता जाएगा।

हालांकि, कुछ AI डेवलपर्स, जैसे कि बड़े पैमाने पर आर्टिफिशियल इंटेलिजेंस नेटवर्क (Large-scale Artificial Intelligence Network), अपने डेटा सेट को ओपन रखने का विकल्प चुनते हैं, लेकिन कई जनरेटिव AI विकसित करने वाली कंपनियाँ प्रशिक्षण डेटा के बारे में रहस्य रखती हैं, "हमें उनके प्रशिक्षण डेटा के बारे में कुछ नहीं पता।" विशेषज्ञों का मानना है कि arXiv जैसे ओपन-सोर्स प्लेटफार्मों और PubMed जैसे डेटाबेस निश्चित रूप से AI कंपनियों के लिए इकट्ठा करने के लोकप्रिय लक्ष्य हैं।

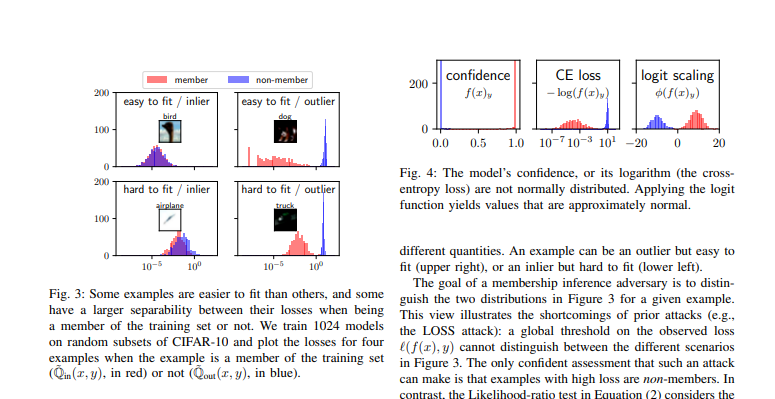

यह साबित करना कि कोई शोध पत्र किसी LLM के प्रशिक्षण सेट में मौजूद है, सरल नहीं है। शोधकर्ता पत्र में असामान्य वाक्यों का उपयोग करके मॉडल के आउटपुट का परीक्षण कर सकते हैं कि क्या यह मूल पाठ के साथ मेल खाता है, लेकिन यह पूरी तरह से साबित नहीं करता कि उस पत्र का उपयोग नहीं किया गया है, क्योंकि डेवलपर्स मॉडल को इस तरह से समायोजित कर सकते हैं कि प्रशिक्षण डेटा का सीधे आउटपुट से बचा जा सके।

यहां तक कि यदि यह साबित हो जाता है कि किसी LLM ने विशिष्ट पाठ का उपयोग किया है, तो उसके बाद क्या होगा? प्रकाशक दावा करते हैं कि बिना अनुमति के कॉपीराइट की गई सामग्री का उपयोग करना उल्लंघन है, लेकिन कुछ का कहना है कि LLM पाठ को कॉपी नहीं कर रहे हैं, बल्कि सूचना सामग्री का विश्लेषण करके नए पाठ उत्पन्न कर रहे हैं।

वर्तमान में अमेरिका में, एक कॉपीराइट से संबंधित मुकदमा चल रहा है, जो एक मील का पत्थर साबित हो सकता है। न्यूयॉर्क टाइम्स माइक्रोसॉफ्ट और ChatGPT के डेवलपर OpenAI के खिलाफ मुकदमा कर रहा है, उन पर बिना अनुमति के उनके समाचार सामग्री का उपयोग कर मॉडल को प्रशिक्षित करने का आरोप लगा रहा है।

कई शोधकर्ता अपने कार्यों को LLM के प्रशिक्षण डेटा में शामिल करने के लिए स्वागत करते हैं, विशेष रूप से जब ये मॉडल शोध की सटीकता को बढ़ाते हैं। हालांकि, यह हर पेशेवर शोधकर्ता के लिए सहज नहीं है, कई लोग अपनी कार्यों को खतरे में महसूस करते हैं।

कुल मिलाकर, वर्तमान में व्यक्तिगत शोध लेखकों के पास प्रकाशकों द्वारा बिक्री के निर्णय लेने पर लगभग कोई आवाज नहीं है, और पहले से प्रकाशित लेखों के लिए, श्रेय कैसे बांटा जाए और क्या उनका उपयोग किया गया है, इस पर स्पष्ट तंत्र की कमी है। कुछ शोधकर्ता इस पर निराशा व्यक्त करते हैं: "हम AI मॉडल की मदद लेना चाहते हैं, लेकिन हम एक निष्पक्ष तंत्र भी चाहते हैं, और हम अभी तक ऐसा समाधान नहीं ढूंढ पाए हैं।"

संदर्भ सामग्री:

https://www.nature.com/articles/d41586-024-02599-9

https://arxiv.org/pdf/2112.03570