क्या आपने ChatGPT, वेनशिन यियान जैसे उन्नत AI के बारे में सुना है? इनके पीछे की मुख्य तकनीक है "बड़े भाषा मॉडल" (LLM)। क्या आपको लगता है कि यह बहुत जटिल और समझने में कठिन है? चिंता न करें, भले ही आपकी गणित की पढ़ाई केवल दूसरी कक्षा तक हो, इस लेख को पढ़ने के बाद आप LLM के काम करने के सिद्धांत को आसानी से समझ सकते हैं!

न्यूरल नेटवर्क: संख्याओं का जादू

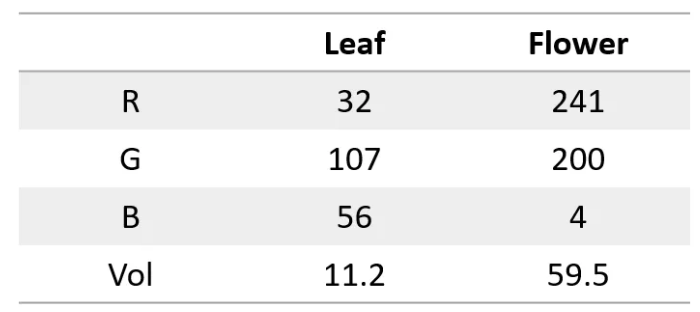

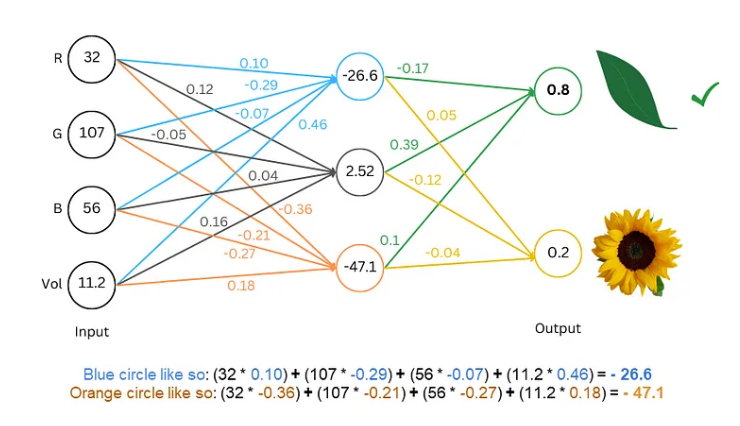

पहले, हमें यह जानना होगा कि न्यूरल नेटवर्क एक सुपर कैलकुलेटर की तरह होता है, जो केवल संख्याओं को प्रोसेस कर सकता है। इनपुट या आउटपुट, दोनों ही संख्याएं होनी चाहिए। तो हम इसे文字 समझने के लिए कैसे तैयार करें?

राज़ यह है कि文字 को संख्याओं में बदलना! उदाहरण के लिए, हम हर अक्षर को एक संख्या द्वारा दर्शा सकते हैं, जैसे a=1, b=2, इसी तरह। इस तरह, न्यूरल नेटवर्क文字 को "समझ" सकता है।

मॉडल को प्रशिक्षित करना: नेटवर्क को "भाषा" सीखाना

संख्यात्मक文字 के साथ, अगला कदम है मॉडल को प्रशिक्षित करना, ताकि न्यूरल नेटवर्क "भाषा" के नियमों को सीख सके।

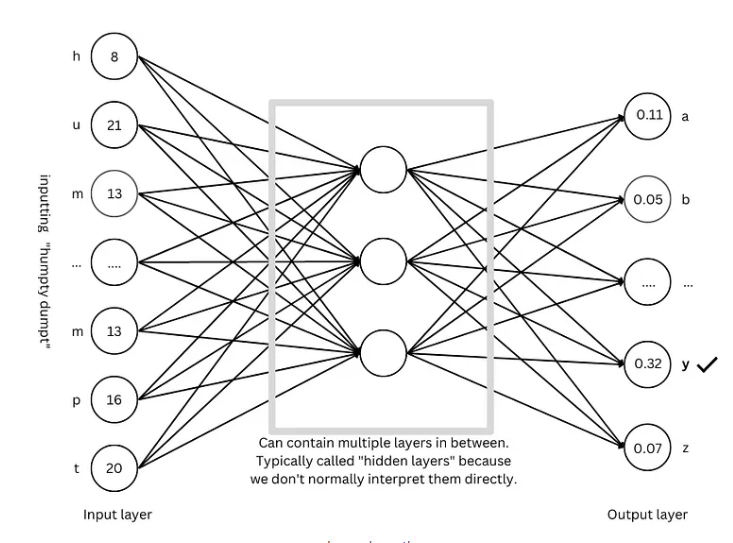

प्रशिक्षण की प्रक्रिया एक पहेली खेलने के समान होती है। हम नेटवर्क को कुछ文字 दिखाते हैं, जैसे "Humpty Dumpty", और फिर इसे अगला अक्षर क्या होगा, यह अनुमान लगाने के लिए कहते हैं। यदि यह सही अनुमान लगाता है, तो हम इसे पुरस्कार देते हैं; यदि गलत होता है, तो हम इसे दंड देते हैं। लगातार अनुमान लगाने और समायोजन के माध्यम से, नेटवर्क अगले अक्षर की भविष्यवाणी करने में अधिक सटीक हो जाता है, अंततः पूर्ण वाक्य जैसे "Humpty Dumpty sat on a wall" उत्पन्न करता है।

उन्नत तकनीक: मॉडल को अधिक "बुद्धिमान" बनाना

मॉडल को अधिक "बुद्धिमान" बनाने के लिए, शोधकर्ताओं ने कई उन्नत तकनीकें विकसित की हैं, जैसे:

शब्द एम्बेडिंग: हम अब अक्षरों को दर्शाने के लिए साधारण संख्याओं का उपयोग नहीं करते, बल्कि हर शब्द को दर्शाने के लिए एक संख्या के समूह (वेक्टर) का उपयोग करते हैं, जिससे शब्दों के अर्थ का अधिक व्यापक वर्णन किया जा सके।

सबवर्ड टोकनाइज़र: शब्दों को छोटे इकाइयों (सबवर्ड) में विभाजित करना, जैसे "cats" को "cat" और "s" में विभाजित करना, जिससे शब्दावली की मात्रा कम होती है और दक्षता बढ़ती है।

स्व-ध्यान तंत्र: जब मॉडल अगले शब्द की भविष्यवाणी करता है, तो यह संदर्भ में सभी शब्दों के आधार पर भविष्यवाणी के वजन को समायोजित करता है, जैसे हम पढ़ते समय संदर्भ के आधार पर शब्दों के अर्थ को समझते हैं।

अवशिष्ट संबंध: नेटवर्क की परतों की अधिकता के कारण प्रशिक्षण में कठिनाई से बचने के लिए, शोधकर्ताओं ने अवशिष्ट संबंध विकसित किया है, जिससे नेटवर्क को सीखना आसान हो जाता है।

मल्टी-हेड ध्यान तंत्र: कई ध्यान तंत्रों को समानांतर में चलाकर, मॉडल विभिन्न दृष्टिकोणों से संदर्भ को समझ सकता है, जिससे भविष्यवाणी की सटीकता बढ़ती है।

स्थान कोडिंग: मॉडल को शब्दों के क्रम को समझाने के लिए, शोधकर्ता शब्द एम्बेडिंग में स्थान संबंधी जानकारी जोड़ते हैं, जैसे हम पढ़ते समय शब्दों के क्रम पर ध्यान देते हैं।

GPT आर्किटेक्चर: बड़े भाषा मॉडल का "नीला प्रिंट"

GPT आर्किटेक्चर वर्तमान में सबसे लोकप्रिय बड़े भाषा मॉडल आर्किटेक्चर में से एक है, यह एक "नीला प्रिंट" की तरह है, जो मॉडल के डिज़ाइन और प्रशिक्षण का मार्गदर्शन करता है। GPT आर्किटेक्चर ने उपरोक्त विभिन्न उन्नत तकनीकों को कुशलता से संयोजित किया है, जिससे मॉडल को भाषा सीखने और उत्पन्न करने में सक्षम बनाता है।

Transformer आर्किटेक्चर: भाषा मॉडल की "क्रांति"

Transformer आर्किटेक्चर हाल के वर्षों में भाषा मॉडल क्षेत्र में एक महत्वपूर्ण突破 है, इसने न केवल भविष्यवाणी की सटीकता को बढ़ाया है, बल्कि प्रशिक्षण की कठिनाई को भी कम किया है, बड़े भाषा मॉडल के विकास की नींव रखी है। GPT आर्किटेक्चर भी Transformer आर्किटेक्चर के विकास पर आधारित है।

संदर्भ सामग्री: https://towardsdatascience.com/understanding-llms-from-scratch-using-middle-school-math-e602d27ec876