Meta और वाटरलू विश्वविद्यालय की शोध टीम ने मिलकर MoCha नामक एक कृत्रिम बुद्धिमत्ता प्रणाली विकसित की है, जो समकालीन आवाज और प्राकृतिक हरकतों सहित पूर्ण पात्र एनिमेशन उत्पन्न कर सकती है। यह नवाचार पिछले केवल चेहरे पर केंद्रित एनिमेशन निर्माण मॉडल से अलग है, MoCha पूरे शरीर की गति को कई कैमरा कोणों से रेंडर कर सकता है, जिसमें होंठों का मिलान, हावभाव और कई पात्रों के बीच बातचीत शामिल है।

मुखर मिलान सटीकता में सुधार

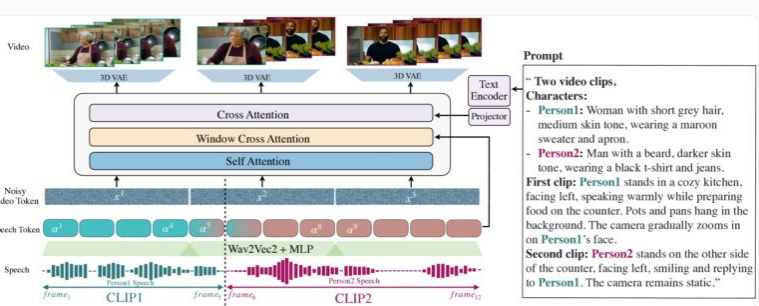

MoCha के प्रदर्शन ने क्लोज़-अप और हाफ़-क्लोज़-अप शॉट्स में ऊपरी शरीर की गति और इशारों के समकालीन निर्माण को मुख्य रूप से दिखाया है। इस प्रणाली की विशिष्टता इसके द्वारा प्रस्तुत "वॉयस-वीडियो विंडो ध्यान" तंत्र में है, इस तंत्र ने लंबे समय से AI वीडियो निर्माण को प्रभावित करने वाली दो मुख्य चुनौतियों को सफलतापूर्वक हल किया है: पहला, ऑडियो के पूर्ण रिज़ॉल्यूशन को बनाए रखते हुए वीडियो संपीड़न कैसे करें, और दूसरा, वीडियो को समानांतर में उत्पन्न करते समय होंठों की गति और ऑडियो के बीच बेमेल से कैसे बचें।

MoCha का नवाचार इस बात में है कि यह प्रत्येक फ्रेम के लिए विशिष्ट ऑडियो डेटा विंडो तक पहुँच को सीमित करके, मानव उच्चारण की नकल करता है - होंठों की गति और तत्काल ध्वनि निकटता से संबंधित हैं, जबकि शरीर की भाषा व्यापक पाठ पैटर्न के अनुसार प्रदर्शित होती है। प्रत्येक फ्रेम ऑडियो के आगे और पीछे मार्कर जोड़कर, MoCha अधिक सुचारू संक्रमण और अधिक सटीक होंठ मिलान को प्रभावी ढंग से प्राप्त कर सकता है।

MoCha पाठ विवरण के अनुसार चेहरे, इशारों और होंठों की गति के साथ यथार्थवादी वीडियो उत्पन्न करता है।

इस प्रणाली के निर्माण के लिए, शोध टीम ने 300 घंटे की सावधानीपूर्वक चयनित वीडियो सामग्री का उपयोग किया, और अभिव्यक्ति और बातचीत की संभावनाओं का विस्तार करने के लिए पाठ-आधारित वीडियो अनुक्रमों को जोड़ा। विशेष रूप से बहु-पात्र दृश्यों में, MoCha ने अपनी शक्तिशाली क्षमता दिखाई है, उपयोगकर्ताओं को केवल एक बार पात्रों को परिभाषित करने की आवश्यकता है, और उन्हें विभिन्न दृश्यों में लेबल (जैसे "पात्र 1" या "पात्र 2") के माध्यम से आसानी से बुलाया जा सकता है, बार-बार विवरण की आवश्यकता नहीं है।

कई पात्रों का प्रबंधन

150 विभिन्न दृश्यों के परीक्षण में, MoCha ने मुखर मिलान और प्राकृतिक गति की गुणवत्ता में समान प्रणालियों को पार कर लिया। स्वतंत्र मूल्यांकनकर्ताओं ने सर्वसम्मति से माना कि इस प्रणाली द्वारा उत्पन्न वीडियो अत्यधिक यथार्थवादी है, और अभूतपूर्व सटीकता और प्राकृतिकता प्रदर्शित करता है।

शोधकर्ताओं ने एक प्रॉम्प्ट टेम्पलेट विकसित किया है जिससे उपयोगकर्ता बिना बार-बार विवरण दिए विशिष्ट वर्णों का उल्लेख कर सकते हैं।

MoCha के विकास ने इसे कई अनुप्रयोग क्षेत्रों में विशाल क्षमता दिखाई है, विशेष रूप से डिजिटल सहायकों, आभासी अवतारों, विज्ञापनों और शैक्षिक सामग्री में। हालाँकि Meta ने यह नहीं बताया है कि क्या यह प्रणाली ओपन सोर्स होगी, या अभी भी शोध प्रोटोटाइप चरण में है, लेकिन इस तकनीक की शुरुआत ने निस्संदेह AI-संचालित वीडियो निर्माण के लिए एक नया अध्याय खोला है।

कृत्रिम बुद्धिमत्ता वीडियो तकनीक की प्रतिस्पर्धा के तेजी से बढ़ते माहौल में, MoCha का प्रकाशन विशेष रूप से ध्यान आकर्षित करता है। Meta ने हाल ही में MovieGen प्रणाली भी शुरू की है, जबकि TikTok की मूल कंपनी ByteDance अपने कृत्रिम बुद्धिमत्ता एनिमेशन उपकरणों, जिसमें INFP, OmniHuman-1 और Goku शामिल हैं, के अनुसंधान और विकास में लगी हुई है, जो इस क्षेत्र में सोशल मीडिया कंपनियों के सक्रिय लेआउट को दर्शाता है।