Meta और वाटरलू विश्वविद्यालय के शोधकर्ताओं ने हाल ही में मिलकर MoCha नामक एक नया AI सिस्टम जारी किया है, जो साधारण पाठ विवरण से सिंक्रनाइज़्ड वॉयस और प्राकृतिक हरकतों वाले पूरे एनिमेटेड कैरेक्टर बना सकता है। यह नई तकनीक सामग्री निर्माण की दक्षता और अभिव्यक्ति क्षमता को बहुत बढ़ा सकती है, और कई क्षेत्रों में इसकी विशाल उपयोगिता संभावनाएँ हैं।

परंपरागत तरीकों को तोड़ते हुए, संपूर्ण शरीर का एनिमेशन और सटीक होंठों का समकालीनता

केवल चेहरे के भावों पर ध्यान केंद्रित करने वाले पिछले AI मॉडल के विपरीत, MoCha की खासियत यह है कि यह पूरे शरीर की प्राकृतिक गति को रेंडर कर सकता है। चाहे वह नज़दीकी हो या अर्ध-नज़दीकी शूटिंग, सिस्टम पाठ सामग्री के अनुसार होंठों का समकालीनता, हावभाव और कई पात्रों के बीच परस्पर क्रिया जैसी बारीक हरकतें बना सकता है। शुरुआती प्रदर्शन मुख्य रूप से ऊपरी शरीर पर केंद्रित थे, जिसमें दिखाया गया था कि कैसे सिस्टम पात्र के होंठों को बातचीत की सामग्री से सटीक रूप से मिलान कर सकता है, और शरीर की भाषा भी पाठ के अर्थ के साथ स्वाभाविक रूप से मेल खाती है।

अधिक सटीक होंठों के समकालीनता को प्राप्त करने के लिए, शोध दल ने नवीन रूप से "वॉयस-वीडियो विंडो अटेंशन" तंत्र को शामिल किया। इस तंत्र ने AI वीडियो निर्माण में लंबे समय से चली आ रही दो प्रमुख चुनौतियों को प्रभावी ढंग से हल किया है: ऑडियो को पूर्ण रिज़ॉल्यूशन बनाए रखते हुए वीडियो प्रसंस्करण प्रक्रिया में सूचना का संपीड़न, और समानांतर वीडियो निर्माण में आसानी से होने वाली होंठों की गलत स्थिति की समस्या। इसका मूल सिद्धांत प्रत्येक फ्रेम की छवि को केवल ऑडियो डेटा की एक विशिष्ट विंडो सीमा तक पहुँच की अनुमति देना है। यह विधि मानव वाणी के काम करने के तरीके की नकल करती है - मुंह की गति तत्काल ध्वनि पर निर्भर करती है, जबकि शरीर की भाषा व्यापक पाठ पैटर्न का पालन करती है। प्रत्येक फ्रेम के ऑडियो के आगे और पीछे मार्कर जोड़कर, MoCha अधिक सहज संक्रमण और अधिक सटीक होंठों के समकालीनता प्रभाव उत्पन्न कर सकता है।

कई पात्रों का आसानी से प्रबंधन, सरल और कुशल संकेत प्रणाली

कई पात्रों वाले दृश्यों को संभालते समय, MoCha टीम ने एक सरल और कुशल संकेत प्रणाली विकसित की है। उपयोगकर्ताओं को केवल एक बार पात्र की जानकारी परिभाषित करने की आवश्यकता है, और वे साधारण लेबल (जैसे 'Person1', 'Person2') के माध्यम से विभिन्न दृश्यों में इन पात्रों का उल्लेख कर सकते हैं। यह विधि पात्रों के बार-बार विवरण की जटिल प्रक्रिया से बचती है, जिससे कई पात्रों के एनिमेशन का निर्माण अधिक सुविधाजनक हो जाता है।

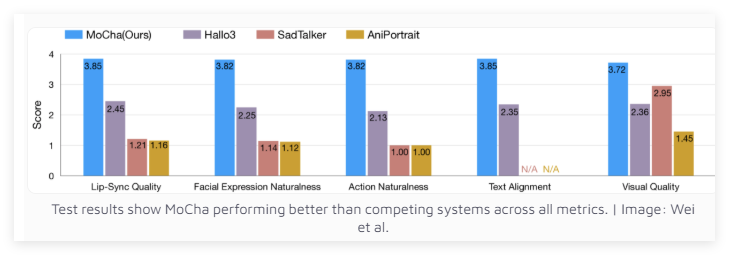

उत्कृष्ट प्रदर्शन, समान प्रणालियों से बेहतर

150 विभिन्न परिदृश्यों में परीक्षण के बाद, MoCha होंठों के समकालीनता और प्राकृतिक गति की गुणवत्ता के मामले में समान प्रणालियों से बेहतर है। स्वतंत्र मूल्यांकनकर्ताओं ने MoCha द्वारा उत्पन्न वीडियो की यथार्थता की बहुत प्रशंसा की है। परीक्षण के परिणामों से पता चलता है कि MoCha सभी संकेतकों में प्रतिस्पर्धियों से बेहतर प्रदर्शन करता है।

Meta की शोध टीम का मानना है कि MoCha डिजिटल सहायक, आभासी अवतार, विज्ञापन और शैक्षिक सामग्री जैसे क्षेत्रों में विशाल उपयोगिता संभावनाएँ दिखाता है। हालाँकि, Meta ने यह नहीं बताया है कि क्या यह सिस्टम ओपन सोर्स होगा, या यह अभी भी एक शोध प्रोटोटाइप के रूप में रहेगा। ध्यान देने योग्य बात यह है कि MoCha का विकास ऐसे महत्वपूर्ण समय में हो रहा है जब प्रमुख सोशल मीडिया कंपनियाँ AI-संचालित वीडियो तकनीक के विकास में प्रतिस्पर्धा कर रही हैं।

इससे पहले, Meta ने MovieGen लॉन्च किया था, और TikTok की मूल कंपनी ByteDance भी अपने स्वयं के AI एनिमेशन सिस्टम, जिसमें INFP, OmniHuman-1 और Goku शामिल हैं, के विकास में सक्रिय रूप से लगी हुई है। इस AI वीडियो तकनीक की दौड़ निस्संदेह संबंधित तकनीक की प्रगति और व्यापक उपयोग को तेज करेगी।

प्रोजेक्ट प्रवेश द्वार: https://top.aibase.com/tool/mocha