フランスの非営利AI研究ラボKyutaiが、革新的なリアルタイムネイティブマルチモーダル基盤モデルである音声アシスタント「Moshi」を発表しました。この画期的なモデルは、5月にOpenAIが発表したGPT-4oが示したいくつかの機能を模倣し、一部の機能ではそれを凌駕しています。

製品入口:https://top.aibase.com/tool/moshi-chat

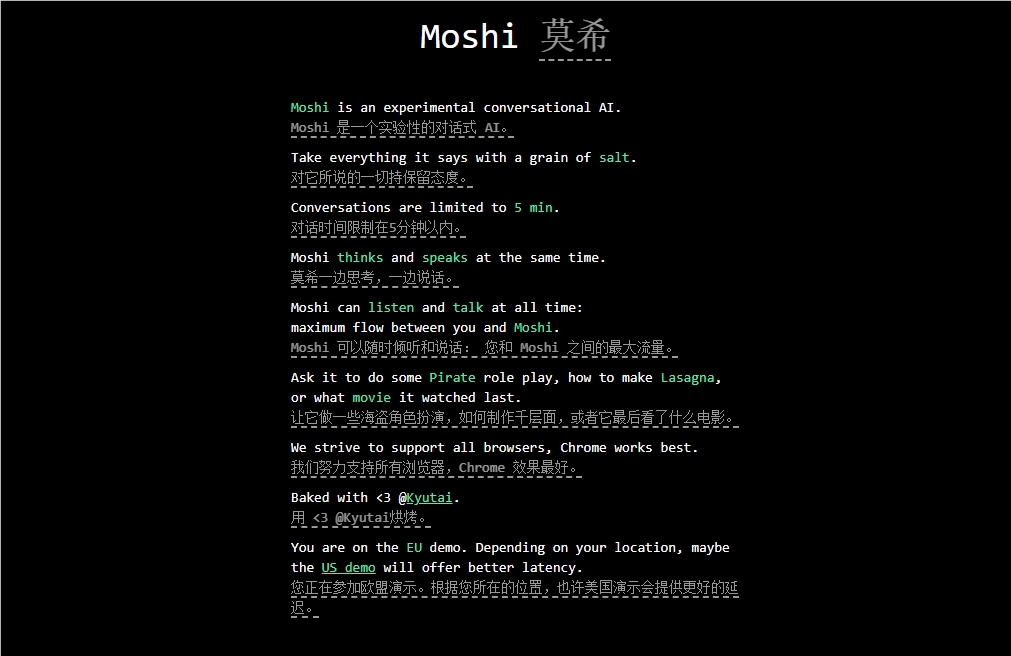

Moshiは感情を理解し表現することを目指しており、フランス語を含む様々なアクセントで会話する能力を備えています。音声と音声を同時に聞き、生成し、テキスト思考をスムーズに伝えることができます。Moshiは人間らしい感情を複数持ち、70種類の感情とスタイルで話すことができるということです。

Moshiの大きな特徴の一つは、2つのオーディオストリームを同時に処理できることで、同時に聞き話すことができます。このリアルタイムインタラクションは、混合テキストとオーディオの共同事前学習に基づいて実現されており、Kyutaiが開発した70億パラメーターの言語モデルHeliumの合成テキストデータを利用しています。

Moshiの微調整プロセスには、10万件の「口語スタイル」の合成対話をテキスト読み上げ(TTS)技術で変換することが含まれていました。このモデルの音声は、別のTTSモデルによって生成された合成データでトレーニングされており、驚くべき200ミリ秒のエンドツーエンドの遅延を実現しています。

注目すべきは、KyutaiはMacBookや消費者向けGPUでも動作するMoshiの小型版も開発しており、より幅広いユーザーが利用できるようになっています。

要点: 🔍 Kyutaiは、リアルタイムネイティブマルチモーダル基盤AIモデルであるMoshiを発表しました。

🔍 Moshiは感情を理解し表現する機能を備えており、複数のアクセントに対応しています。

🔍 このモデルは厳格な微調整とトレーニングを経ており、高い性能と多様な応用可能性を示しています。