最近、Redditユーザーの@zefmanさんが興味深い実験を行いました。様々な大規模言語モデル(LLM)をチェスで対戦させ、楽しく簡単にモデルの性能を評価するプラットフォームを構築したのです。

これらのモデルはチェスが得意ではないことは周知の事実ですが、それでもこの実験から注目すべき点がいくつか見つかったとのことです。

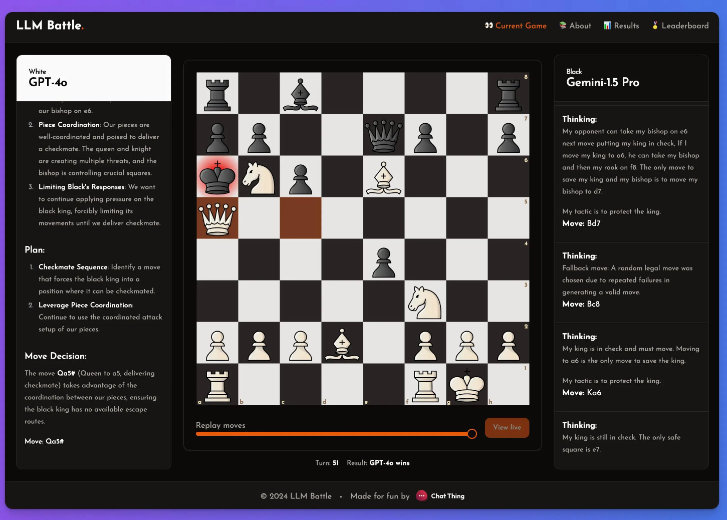

この実験では、@zefmanさんは最新のいくつかのモデルに注目し、その中でもGPT-4oが最も優れた性能を示し、最強のプレイヤーとなったことは間違いありません。同時に、Claude、Geminiなどの他のモデルと比較し、パフォーマンスの違いを観察しました。各モデルの思考や推論プロセスは非常に興味深いものでした。このプラットフォームを通して、各手番の決定の裏にある、モデルによる棋譜の分析を見ることができます。

@zefmanさんが設計したチェスの表示方法は非常にシンプルです。各モデルは同じ盤面の状態に対して同じプロンプトを与えられ、現在の盤面の状態、FEN(棋譜表記法)、そしてそれ以前の2手の動きが含まれます。この方法により、各モデルの決定は同じ情報に基づいて行われ、より公平な比較が可能になります。

各モデルは全く同じプロンプトを使用します。このプロンプトは、ASCI、FENでの盤面の状態、そしてそれ以前の2回の移動と思考と共に更新されます。以下に例を示します。

さらに、@zefmanさんは、特に性能の低いモデルでは、誤った手を何度も選択することがあることに気づきました。この問題を解決するために、これらのモデルには5回の再選択の機会が与えられ、それでも有効な手を選択できない場合は、ランダムに有効な手を選択することでゲームを継続できるようにしました。

彼の結論は、GPT-4oが依然として最強であり、チェスでGemini1.5proを破ったということです。

要点:

🌟 GPT-4oが優れた性能を示し、実験で最強の言語モデルとなりました。

♟️ この実験では、異なるモデルがリアルタイムで対戦し、その思考プロセスを分析しました。

🔄 性能の低いモデルは誤った手を選択することがあり、興味深いインタラクティブな体験を提供しました。