データとアルゴリズムが中心となるデジタル世界において、人工知能の発展にはチェックポイントという重要な要素が欠かせません。まるで人の心を理解し、自然な会話をする大型言語モデルを訓練している場面を想像してみてください。このモデルは非常に賢い反面、「大食い」で、膨大な計算資源を必要とします。訓練中に突然停電したりハードウェアに不具合が発生したりすると、莫大な損失を被ることになります。そこでチェックポイントは「タイムマシン」のような役割を果たし、以前の安全な状態に戻って、中断した作業を再開できるようにします。

しかし、この「タイムマシン」自体も綿密な設計が必要です。バイトダンスと香港大学の科学者たちは、論文「ByteCheckpoint: A Unified Checkpointing System for LLM Development」において、全く新しいチェックポイントシステムであるByteCheckpointを発表しました。これは単なるバックアップツールではなく、大型言語モデルの訓練効率を大幅に向上させる画期的なシステムです。

まず、大型言語モデル(LLM)が直面する課題を理解する必要があります。これらのモデルが「巨大」なのは、膨大な情報を処理・記憶する必要があるためです。そのため、訓練コストが高く、資源消費が大きく、耐障害性が低いという問題があります。不具合が発生すると、長時間の訓練が無駄になる可能性があります。

チェックポイントシステムはモデルの「スナップショット」のようなもので、訓練中に定期的に状態を保存します。そのため、問題が発生しても、直近の状態に迅速に復元でき、損失を最小限に抑えることができます。しかし、既存のチェックポイントシステムは、大型モデルを処理する際に、I/O(入出力)ボトルネックにより効率が低下することが多々あります。

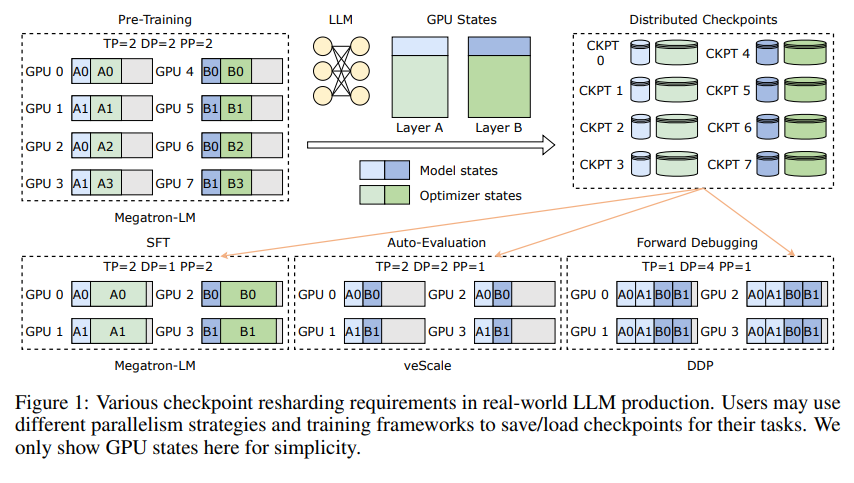

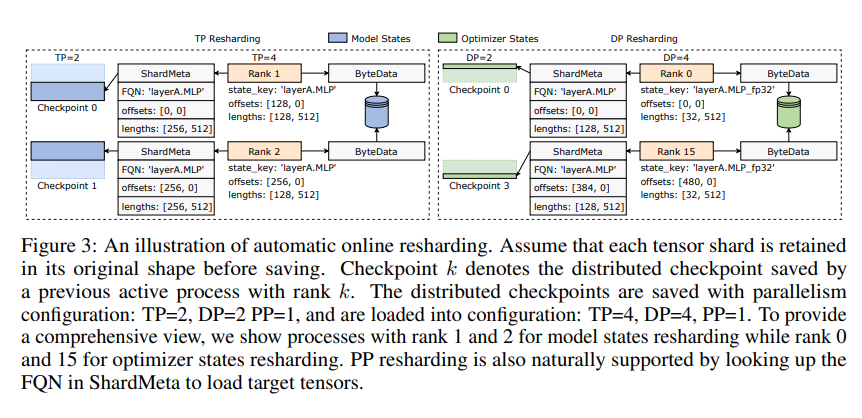

ByteCheckpointの革新的な点は、データとメタデータを分離する新しいストレージアーキテクチャを採用し、異なる並列構成や訓練フレームワーク下でのチェックポイントをより柔軟に処理できることです。さらに素晴らしいことに、訓練を中断することなく、チェックポイントを動的に調整して異なるハードウェア環境に適応できる、オンラインチェックポイントの自動再分割をサポートしています。

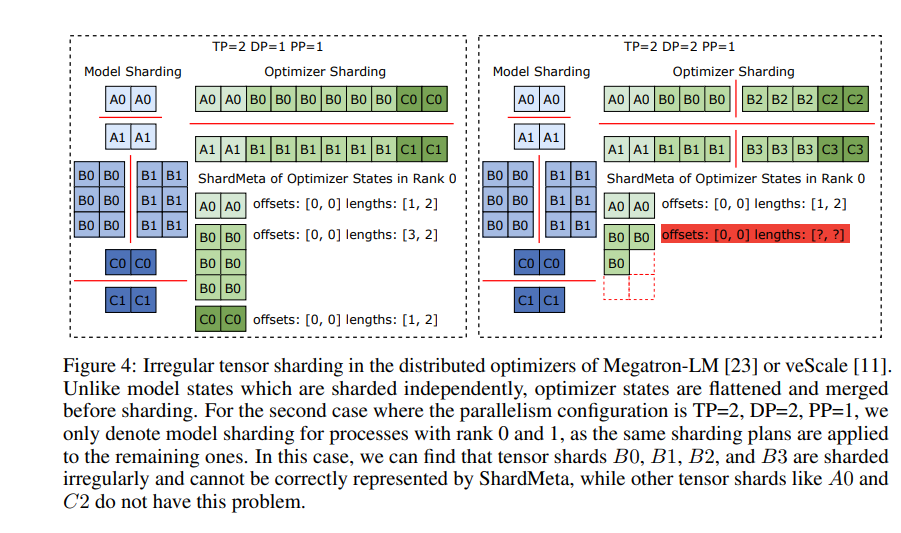

ByteCheckpointは、非同期テンソルマージという重要な技術も導入しています。これにより、異なるGPUに不均一に分散されたテンソルを効率的に処理し、チェックポイントの再分割時にモデルの整合性と一貫性を維持することができます。

チェックポイントの保存と読み込み速度を向上させるため、ByteCheckpointは、精緻な保存/読み込みパイプライン、Ping-Pongメモリプール、ワークロードバランス保存、ゼロ冗長読み込みなどのI/Oパフォーマンス最適化策を統合し、訓練中の待ち時間を大幅に削減しています。

実験により、従来の方法と比較して、ByteCheckpointはチェックポイントの保存と読み込み速度を数十倍から数百倍向上させ、大型言語モデルの訓練効率を大幅に向上させることが実証されました。

ByteCheckpointは単なるチェックポイントシステムではなく、大型言語モデル訓練における強力な支援ツールであり、より効率的で安定したAI訓練への道を切り開く重要な存在です。