人工知能の急速な発展の裏で、深刻な問題が水面上に浮上しつつあります。それは、データ取得の困難さが増しているという問題です。MITなどの機関による最新の研究によると、かつては容易に取得できたウェブデータが、現在ではアクセスが困難になりつつあり、AIの学習と研究に大きな課題を突きつけています。

研究者たちは、C4、RefineWeb、Dolmaなど、複数のオープンソースデータセットが収集したウェブサイトが、その利用許諾契約を急速に厳格化していることを発見しました。これは、商業用AIモデルの学習に影響を与えるだけでなく、学術機関や非営利団体による研究にも障害をもたらしています。

この研究は、MITメディアラボ、ウェルズリー大学、AIスタートアップ企業Raiveなどの機関から4人のチームリーダーが共同で行いました。彼らは、データの制限が急増しており、許諾の非対称性と不整合の問題がますます顕著になっていると指摘しています。

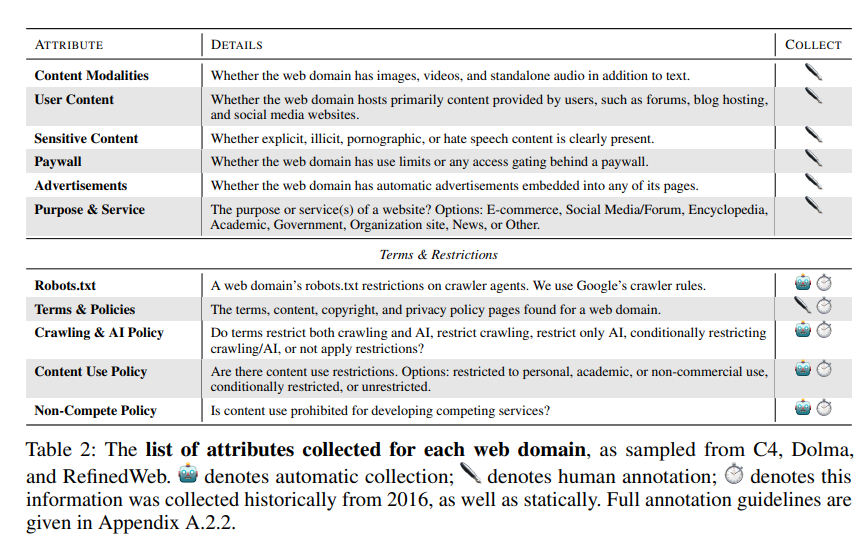

研究チームは、robots.txt(ロボット排除プロトコル、REP)とウェブサイトの利用規約(Terms of Service、ToS)を研究方法として使用しました。彼らは、OpenAIのような大規模なAI企業のクローラーでさえ、ますます厳格な制限に直面していることを発見しました。

SARIMAモデルによる予測では、robots.txtであろうとToSであろうと、ウェブサイトによるデータへの制限は今後も増加し続けるとされています。これは、オープンなウェブデータの取得がさらに困難になることを示唆しています。

研究では、ウェブから収集されたデータとAIモデルの学習用途が一致していないことも判明しており、モデルの整合性、データ収集の実践、著作権に影響を与える可能性があります。

研究チームは、ウェブサイト所有者の意向を反映するより柔軟な合意が必要であり、許諾される利用ケースと許諾されない利用ケースを分離し、利用規約と同期させる必要があると訴えています。同時に、AI開発者がオープンなウェブ上のデータを使用して学習を行うことを期待しており、将来の法律がそれを支持することを望んでいます。